蘋果AI放大招?新裝置端模型超過GPT-4,有望拯救Siri

机器之心發表於2024-04-02

或許不久之後,Siri就能看懂手機螢幕並幫你點外賣了。

在最近的一篇論文中,蘋果的研究人員宣稱,他們提出了一個可以在裝置端執行的模型,這個模型在某些方面可以超過 GPT-4。具體來說,他們研究的是 NLP 中的指代消解(Reference Resolution)問題,即讓 AI 識別文字中提到的各種實體(如人名、地點、組織等)之間的指代關係的過程。簡而言之,它涉及到確定一個詞或短語所指的具體物件。這個過程對於理解句子的意思至關重要,因為人們在交流時經常使用代詞或其他指示詞(如「他」、「那裡」)來指代之前提到的名詞或名詞短語,避免重複。不過,論文中提到的「實體」更多得與手機、平板電腦等裝置有關,包括:- 螢幕實體(On-screen Entities):使用者在與裝置互動時,螢幕上顯示的實體或資訊。

- 對話實體(Conversational Entities):與對話相關的實體。這些實體可能來自使用者之前的發言(例如,當使用者說「給媽媽打電話」時,「媽媽」的聯絡方式就是相關的實體),或者來自虛擬助手(例如,當助手為使用者提供一系列地點或鬧鐘供選擇時)。

- 後臺實體(Background Entities):這些是與使用者當前與裝置互動的上下文相關的實體,但不一定是使用者直接與虛擬助手互動產生的對話歷史的一部分;例如,開始響起的鬧鐘或在背景中播放的音樂。

蘋果的研究在論文中表示,儘管大型語言模型(LLM)已經證明在多種任務上具有極強的能力,但在用於解決非對話實體(如螢幕實體、後臺實體)的指代問題時,它們的潛力還沒有得到充分利用。在論文中,蘋果的研究者提出了一種新的方法 —— 使用已解析的實體及其位置來重建螢幕,並生成一個純文字的螢幕表示,這個表示在視覺上代表了螢幕內容。然後,他們對螢幕中作為實體的部分進行標記,這樣模型就有了實體出現位置的上下文,以及圍繞它們的文字是什麼的資訊(例如:呼叫業務號碼)。據作者所知,這是第一個使用大型語言模型對螢幕上下文進行編碼的工作。具體來說,他們提出的模型名叫 ReALM,引數量分別為 80M、250M、1B 和 3B,體積都非常小,適合在手機、平板電腦等裝置端執行。研究結果顯示,相比於具有類似功能的現有系統,該系統在不同型別的指代上取得了大幅度的改進,其中最小的模型在處理螢幕上的指代時獲得了超過 5% 的絕對增益。此外,論文還將其效能與 GPT-3.5 和 GPT-4 進行了對比,結果顯示最小模型的效能與 GPT-4 相當,而更大的模型則顯著超過了 GPT-4。這表明透過將指代消解問題轉換為語言建模問題,可以有效利用大型語言模型解決涉及多種型別指代的問題,包括那些傳統上難以僅用文字處理的非對話實體指代。這項研究有望用來改進蘋果裝置上的 Siri 智慧助手,幫助 Siri 更好地理解和處理使用者詢問中的上下文,尤其是涉及螢幕上內容或後臺應用的複雜指代,在在線搜尋、操作應用、讀取通知或與智慧家居裝置互動時都更加智慧。蘋果將於太平洋時間 2024 年 6 月 10 日至 14 日線上舉辦全球開發者大會「WWDC 2024」,並推出全面的人工智慧戰略。有人預計,上述改變可能會出現在即將到來的 iOS 18 和 macOS 15 中,這將代表使用者與 Apple 裝置之間互動的重大進步。- 論文地址:https://arxiv.org/pdf/2403.20329.pdf

- 論文標題:ReALM: Reference Resolution As Language Modeling

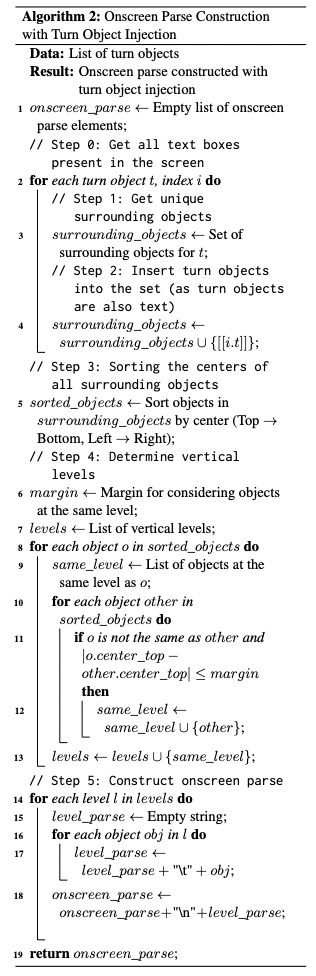

本文任務制定如下:給定相關實體和使用者想要執行的任務,研究者希望提取出與當前使用者查詢相關的實體(或多個實體)。相關實體有 3 種不同型別:螢幕實體、對話實體以及後臺實體(具體內容如上文所述)。在資料集方面,本文采用的資料集包含綜合建立的資料或在註釋器的幫助下建立的資料。資料集的資訊如表 2 所示。其中,對話資料是使用者與智慧體互動相關的實體資料;合成資料顧名思義就是根據模板合成的資料;螢幕資料(如下圖所示)是從各種網頁上收集的資料,包括電話號碼、電子郵件等。研究團隊將 ReALM 模型與兩種基線方法進行了比較:MARRS(不基於 LLM)、ChatGPT。該研究使用以下 pipeline 來微調 LLM(FLAN-T5 模型):首先向模型提供解析後的輸入,並對其進行微調。請注意,與基線方法不同,ReALM 不會在 FLAN-T5 模型上執行廣泛的超引數搜尋,而是使用預設的微調引數。對於由使用者查詢和相應實體組成的每個資料點,研究團隊將其轉換為句子格式,然後將其提供給 LLM 進行訓練。基於型別的指代嚴重依賴於將使用者查詢與實體型別結合使用來識別(一組實體中)哪個實體與所討論的使用者查詢最相關:例如,使用者說「play this」,我們知道「this」指的是歌曲或電影等實體,而不是電話號碼或地址;「call him」則指的是電話號碼或聯絡人,而不是鬧鐘。描述性指代傾向於使用實體的屬性來唯一地標識它:例如「時代廣場的那個」,這種指代可能有助於唯一地指代一組中的一個。請注意,通常情況下,指代可能同時依賴型別和描述來明確指代單個物件。蘋果的研究團隊簡單地對實體的型別和各種屬性進行了編碼。對於螢幕指代,研究團隊假設存在能夠解析螢幕文字以提取實體的上游資料檢測器。然後,這些實體及其型別、邊界框以及圍繞相關實體的非實體文字元素列表都可用。為了以僅涉及文字的方式將這些實體(以及螢幕的相關部分)編碼到 LM 中,該研究採用了演算法 2。

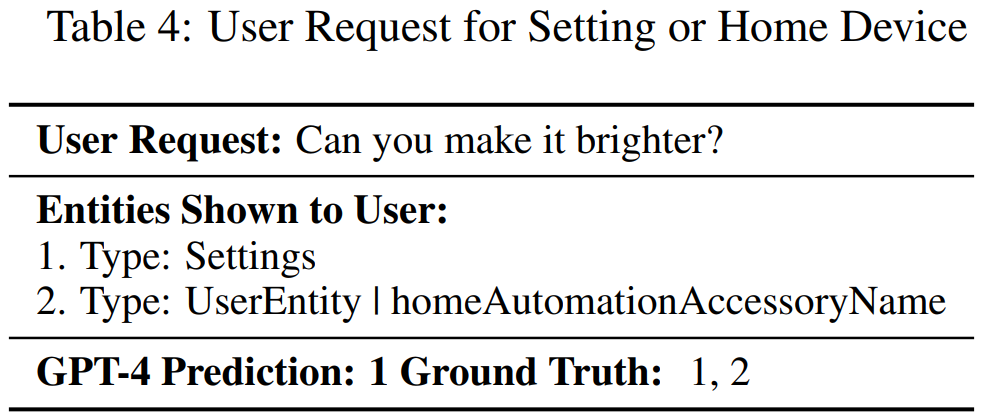

直觀地講,該研究假設所有實體及其周圍物件的位置由它們各自的邊界框的中心來表示,然後從上到下(即垂直、沿 y 軸)對這些中心(以及相關物件)進行排序,並從左到右(即水平、沿 x 軸)使用穩定排序。所有位於邊緣(margin)內的物件都被視為在同一行上,並透過製表符將彼此分隔開;邊緣之外更下方的物件被放置在下一行,這個過程重複進行,有效地從左到右、從上到下以純文字的方式對螢幕進行編碼。表 3 為實驗結果:本文方法在所有型別的資料集中都優於 MARRS 模型。此外,研究者還發現該方法優於 GPT-3.5,儘管後者的引數數量比 ReALM 模型多出幾個數量級。在與 GPT-4 進行對比時,儘管 ReALM 更簡潔,但其效能與最新的 GPT-4 大致相同。此外,本文特別強調了模型在螢幕資料集上的收益,並發現採用文字編碼的模型幾乎能夠與 GPT-4 一樣執行任務,儘管後者提供了螢幕截圖(screenshots)。最後,研究者還嘗試了不同尺寸的模型。GPT-4 ≈ ReaLM ≫ MARRS 用於新用例。作為案例研究,本文探討了模型在未見過領域上的零樣本效能:Alarms(附錄表 11 中顯示了一個樣本資料點)。表 3 結果表明,所有基於 LLM 的方法都優於 FT 模型。本文還發現 ReaLM 和 GPT-4 在未見過領域上的效能非常相似。ReaLM > GPT-4 用於特定領域的查詢。由於對使用者請求進行了微調,ReaLM 能夠理解更多特定於領域的問題。例如表 4 對於使用者請求,GPT-4 錯誤地假設指代僅與設定有關,而真實情況也包含後臺的家庭自動化裝置,並且 GPT-4 缺乏識別領域知識的能力。相比之下,ReaLM 由於接受了特定領域資料的訓練,因此不會出現這種情況。