1. 引言

10月11-17日,萬眾期待的國際計算機視覺大會 ICCV 2021 (International Conference on Computer Vision) 線上上如期舉行,受到全球計算機視覺領域研究者的廣泛關注。

今年阿里雲多媒體 AI 團隊(由阿里雲影片雲和達摩院視覺團隊組成)參加了 MFR 口罩人物身份鑑別全球挑戰賽,並在總共5個賽道中,一舉拿下1個冠軍、1個亞軍和2個季軍,展現了我們在人物身份鑑別領域深厚的技術積澱和業界領先的技術優勢。

2. 競賽介紹

MFR口罩人物身份鑑別全球挑戰賽是由帝國理工學院、清華大學和InsightFace.AI聯合舉辦的一次全球範圍內的挑戰賽,主要為了解決新冠疫情期間佩戴口罩給人物身份鑑別演算法帶來的挑戰。競賽從6月1日開始至10月11日結束,歷時4個多月,共吸引了來自全球近400支隊伍參賽,是目前為止人物身份鑑別領域規模最大、參與人數最多的權威賽事。據官方統計,此次競賽收到的總提交次數超過10000次,各支隊伍競爭異常激烈。

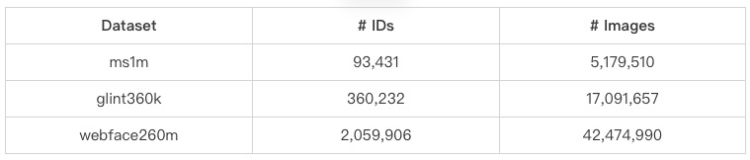

2.1 訓練資料集

此次競賽的訓練資料集只能使用官方提供的3個資料集,不允許使用其它額外資料集以及預訓練模型,以保證各演算法對比的公平公正性。官方提供的3個資料集,分別是ms1m小規模資料集、glint360k中等規模資料集和webface260m大規模資料集,各資料集包含的人物ID數和圖片數如下表所示:

2.2 評測資料集

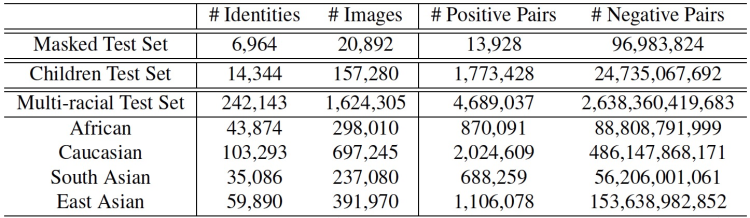

此次競賽的評測資料集包含的正負樣本對規模在萬億量級,是當前業界規模最大、包含資訊最全的權威評測資料集。值得注意的是所有評測資料集均不對外開放,只提供介面在後臺進行自動測評,避免演算法過擬合測試資料集。

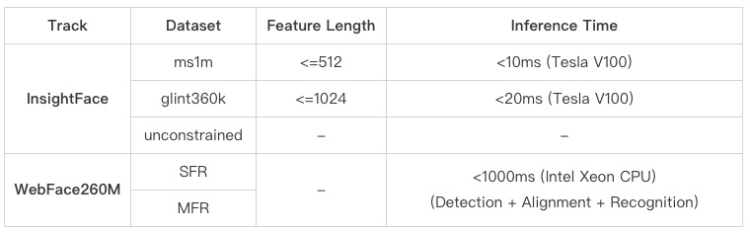

InsightFace賽道評測資料集的詳細統計資訊如下表所示:

WebFace260M賽道評測資料集的詳細統計資訊如下表所示:

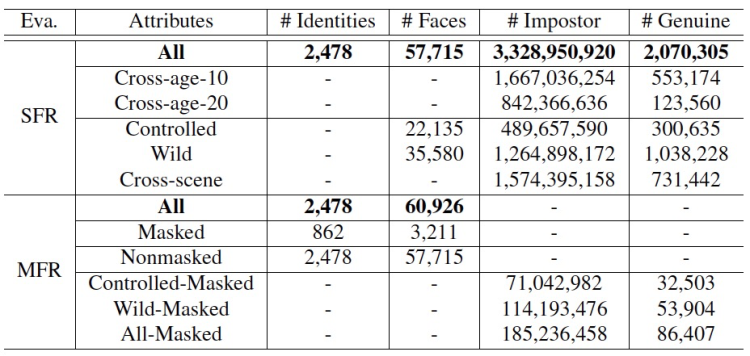

2.3 評測指標

此次競賽的評測指標不僅有效能方面的指標,而且還包含特徵維度和推理時間的限制,因此更加貼近真實業務場景。詳細的評測指標如下表所示:

3. 解決方案

下面,我們將從資料、模型、損失函式等方面,對我們的解決方案進行逐一解構。

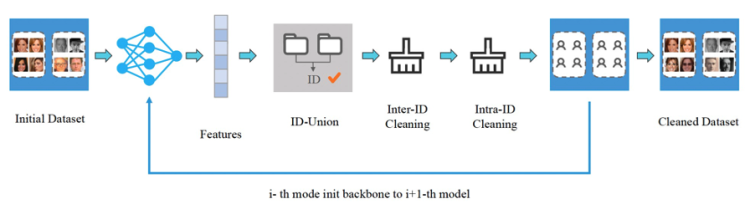

3.1 基於自學習的資料清洗

眾所周知,人物身份鑑別相關的訓練資料集中廣泛存在著噪聲資料,例如同一人物圖片分散到不同人物ID下、多個人物圖片混合在同一人物ID下,資料集中的噪聲會對識別模型的效能產生較大影響。針對上述問題,我們提出了基於自學習的資料清洗框架,如下圖所示:

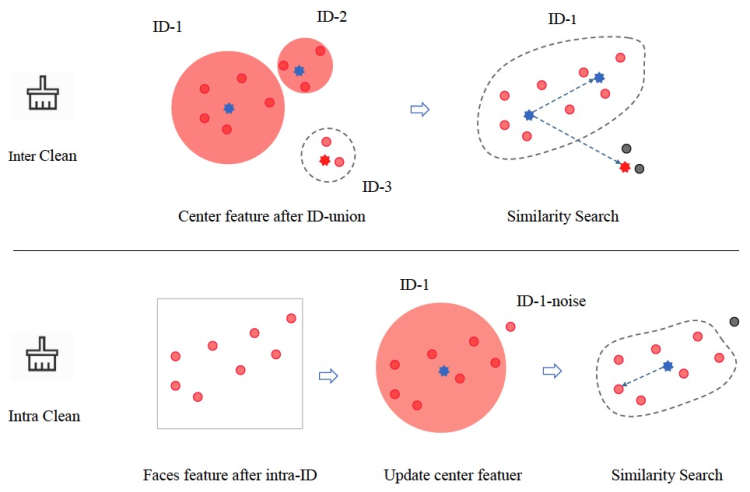

首先,我們使用原始資料訓練初始模型M0,然後使用該模型進行特徵提取、ID合併、類間清洗和類內清洗等一系列操作。對於每個人物ID,我們使用DBSCAN聚類演算法去計算中心特徵,然後使用中心特徵進行相似度檢索,這一步使用的高維向量特徵檢索引擎是達摩院自研的Proxima,它可以快速、精準地召回Doc中與Query記錄相似度最高的topK個結果。緊接著,我們使用清洗完成的資料集,訓練新的模型M1,然後重複資料清洗及新模型訓練過程,透過不斷進行迭代自學習方式,使得資料質量越來越高,模型效能也隨之越來越強。具體來看,類間清洗和類內清洗的示意圖如下圖所示:

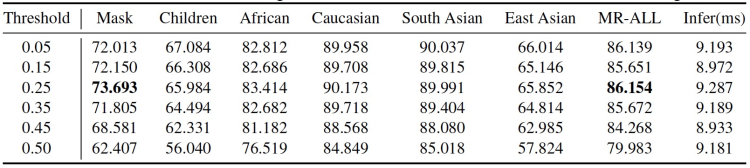

值得注意的是,我們的清洗流程中先進行類間清洗、再進行類內清洗,與CAST[1]資料清洗框架不同,這樣在完成類間清洗後可以更新新的ID中心特徵,使得整個清洗過程更加完備,清洗效果也更好。為了驗證資料清洗對最終效能的影響,我們在ms1m資料集上做了一系列對比實驗,結果如下表所示:

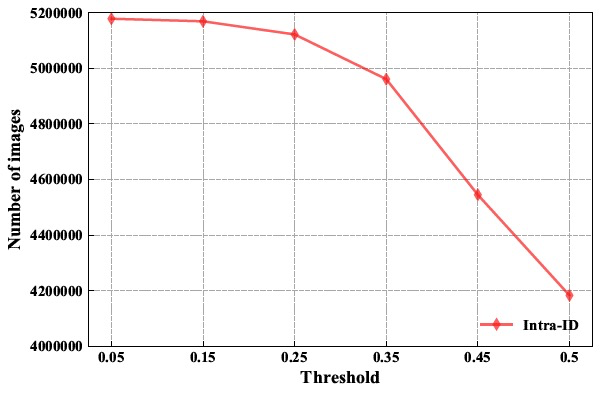

表中的閾值指的是類內清洗的相似度閾值,可以看出當閾值設定過低(如0.05)時,噪聲沒有被清洗乾淨,因此效能表現不是最佳;而當閾值設定過高(如0.50)時,噪聲被清洗的同時難樣本也被清洗了,導致模型泛化能力變弱,在評測資料集上效能反而下降。因此選擇一箇中間閾值0.25,既清洗了大量噪聲,又保留了困難樣本,在各項評測指標上均達到最佳效能。此外,我們還畫出了不同相似度閾值與剩餘圖片數的關係,如下圖所示:

3.2 戴口罩資料生成

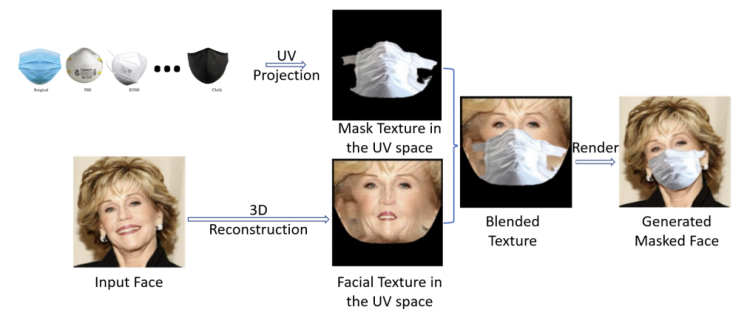

為解決戴口罩資料不足的問題,一種可行的方案是在已有的無口罩影像上繪製口罩。然而,目前大部分的繪製方案屬於位置貼圖式,這種方案生成的戴口罩影像不夠真實且缺乏靈活性。因此,我們借鑑PRNet[2,3]的思路,採用一種影像融合方案[4]來獲取更符合真實情況的戴口罩影像,如下圖所示,

該方案的原理是將口罩影像和原影像透過3D重建分別生成UV Texture Map,然後藉助紋理空間合成戴口罩影像。在資料生成過程中,我們使用了8種型別的口罩,意味著我們可在已有的資料集上對應生成8種不同風格的戴口罩影像。基於UV對映的方案克服了傳統平面投影方式中原影像和口罩影像間的不理想銜接和變形等問題。此外,由於渲染過程的存在,戴口罩影像可以獲得不同的渲染效果,比如調整口罩角度及光照效果等。生成的戴口罩影像示例如下圖所示:

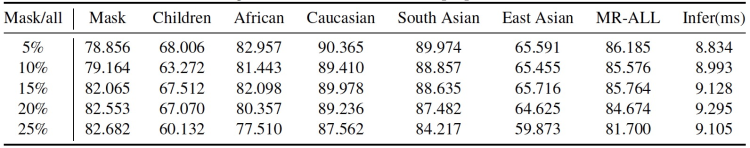

在生成戴口罩資料訓練模型的過程中,我們發現戴口罩資料的比例對模型效能有不同程度的影響。因此,我們將戴口罩資料佔比分別設定為5%、10%、15%、20%和25%,實驗結果如下表所示:

從上表中發現,當戴口罩資料比例為5%時,模型在MR-ALL評測集上的效能最高;當戴口罩資料比例調整至25%時,對Mask戴口罩評測集的效能提升明顯,但在MR-ALL上的效能下降明顯。這說明當混合戴口罩資料和正常資料進行訓練時,其比例是影響模型效能的重要引數。最終,我們選擇戴口罩資料比例為15%,在戴口罩和正常資料上的效能達到一個較好平衡。

3.3 基於NAS的骨幹網路

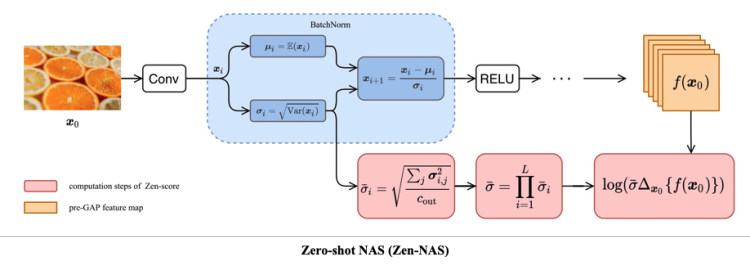

不同骨幹網路對特徵提取的能力差異較大,在人物身份鑑別領域,業界常用的基線骨幹網路是在ArcFace[5]中提出的IR-100。在此次競賽中,我們採用達摩院提出的Zero-shot NAS (Zen-NAS[6]) 正規化,在模型空間搜尋具有更強表徵能力的骨幹網路。Zen-NAS區別於傳統NAS方法,它使用Zen-Score代替搜尋模型的效能評測分數,值得注意的是Zen-Score與模型最終的效能指標成正比關係,因此整個搜尋過程非常高效。Zen-NAS的核心演算法結構如下圖所示:

我們基於IR-SE基線骨幹網路,使用Zen-NAS搜尋3個模型結構相關的變數,分別是:Input層的通道數、Block層的通道數和不同Block層堆疊的次數,限制條件是搜尋出的骨幹網路滿足各賽道的推理時間約束。一個有趣的發現是:Zen-NAS搜尋出的骨幹網路,在ms1m小資料集賽道上的效能表現與IR-SE-100幾乎無差異,但在WebFace260M這樣的大資料集賽道,效能表現會明顯優於基線。原因可能是搜尋空間增大後,NAS可搜尋的範圍隨之增大,搜尋到更強大模型的機率也隨之增加。

3.4 損失函式

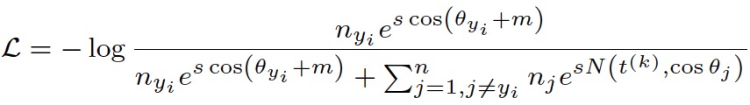

此次競賽我們採用的基線損失函式為Curricular Loss[7],該損失函式在訓練過程中模擬課程學習的思想,按照樣本從易到難的順序進行訓練。然而,由於訓練資料集通常是極度不平衡的,熱門人物包含的圖片數多達數千張,而冷門人物包含的圖片數往往只有1張。為解決資料不均衡帶來的長尾問題,我們將Balanced Softmax Loss[8]的思想引入Curricular Loss中,提出一個新的損失函式:Balanced Curricular Loss,其表示式如下圖所示:

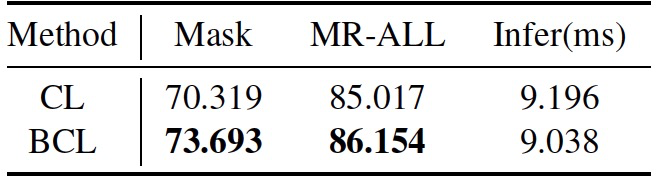

在ms1m賽道上,我們對比了Balanced Curricular Loss (BCL) 與原始Curricular Loss (CL) 的效能,結果如下表所示:

可以看出Balanced Curricular Loss相對於Curricular Loss,無論在Mask還是MR-ALL上的指標均有較大幅度的提升,充分證明了其有效性。

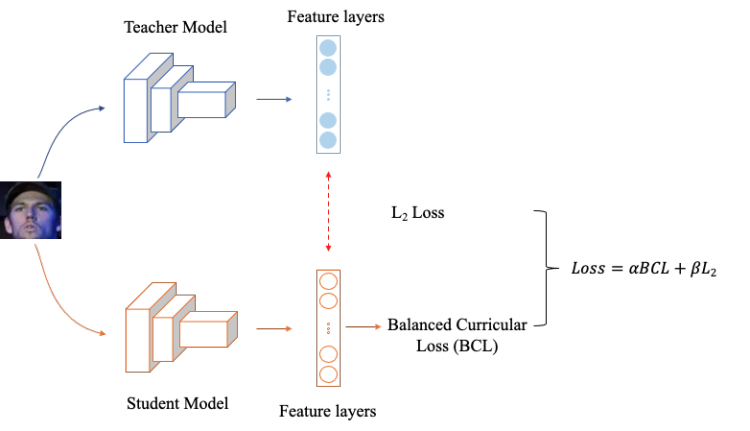

3.5 知識蒸餾

由於此次比賽對模型的推理時間有約束,模型超時會被直接取消成績。因此,我們採用知識蒸餾的方式,將大模型強大的表徵能力傳遞給小模型,然後使用小模型進行推理,以滿足推理時間的要求。此次競賽我們採用的知識蒸餾框架如下圖所示:

其中,蒸餾損失採用最簡單的L2 Loss,用以傳遞教師模型的特徵資訊,同時學生模型使用Balanced Curricular Loss訓練,最終的損失函式是蒸餾損失與訓練損失的加權和。經過知識蒸餾後,學生模型在評測資料集上的部分指標,甚至超過了教師模型,同時推理時間大大縮短,在ms1m小資料集賽道的效能有較大提升。

3.6 模型和資料同時並行

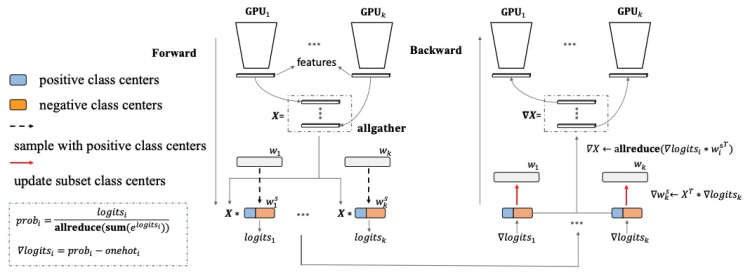

WebFace260M大資料集賽道的訓練資料ID數量>200萬、總圖片數>4000萬,導致傳統的多機多卡資料並行訓練方式已難以容納完整的模型。Partial FC[9]採用將FC層均勻分散到不同GPU上,每個GPU負責計算儲存在自己視訊記憶體單元的sub FC層結果,最終透過所有GPU間的同步通訊操作,得到近似的full FC層結果。Partial FC的示意圖如下所示:

採用Partial FC,可同時使用模型並行與資料並行,使得之前無法訓練的大模型可以正常訓練,另外可採用負樣本取樣的方式,進一步加大訓練的batch size,縮短模型訓練週期。

3.7 其它技巧

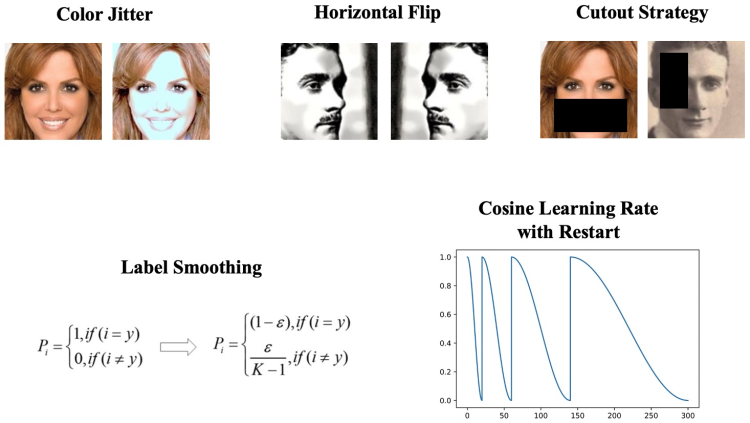

在整個競賽過程中,我們先後嘗試了不同資料增強、標籤重構及學習率改變等策略,其中有效的策略如下圖所示:

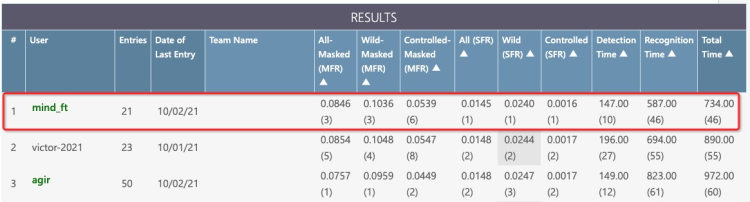

4. 競賽結果

此次競賽我們mind_ft隊在InsightFace和WebFace260M共5個賽道中獲得1個冠軍(WebFace260M SFR)、1個亞軍(InsightFace unconstrained)和2個季軍(WebFace260M Main和InsightFace ms1m)。其中,WebFace260M賽道官方排行榜的最終結果截圖如下所示:

在競賽結束之後的Workshop中,我們受邀在全球範圍內分享此次競賽的解決方案。此外,我們在此次競賽中投稿的論文,也被同步收錄於ICCV 2021 Workshop[10]。最後,展示一下我們在此次競賽中收穫的榮譽證書:

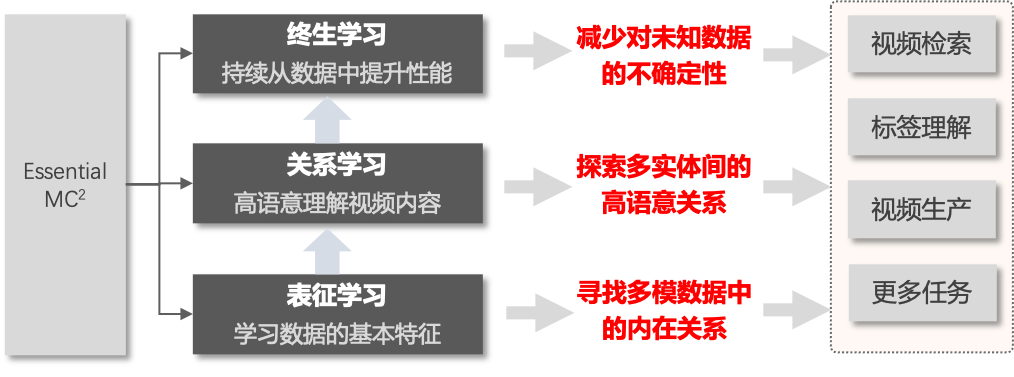

5. EssentialMC2介紹與開源

EssentialMC2,實體時空關係推理多媒體認知計算,是達摩院MinD-數智媒體組對於影片理解技術的一個長期研究結果沉澱的核心演算法架構。核心內容包括表徵學習MHRL、關係推理MECR2和開集學習MOSL3三大基礎模組,三者分別對應從基礎表徵、關係推理和學習方法三個方面對影片理解演算法框架進行最佳化。基於這三大基礎模組,我們總結了一套適合於大規模影片理解演算法研發訓練的程式碼框架,並進行開源,開源工作中包含了組內近期發表的優秀論文和演算法賽事結果。

essmc2是EssentialMC2配套的一整套適合大規模影片理解演算法研發訓練的深度學習訓練框架程式碼包,開源的主要目標是希望提供大量可驗證的演算法和預訓練模型,支援使用者以較低成本快速試錯,同時希望在影片理解領域內建立一個有影響力的開源生態,吸引更多貢獻者參與專案建設。essmc2的主要設計思路是“配置即物件”,透過簡要明瞭的配置檔案配合註冊器的設計模式(Registry),可以將眾多模型定義檔案、最佳化器、資料集、預處理pipeline等引數以配置檔案的形式快速構造出物件並使用,本質上貼合深度學習的日常使用中不斷調參不斷實驗的場景。同時透過一致性的視角實現單機和分散式的無縫切換,使用者僅需定義一次,便可在單機單卡、單機多卡、分散式環境下進行切換,同時實現簡單易用與高可移植性的特性。

目前essmc2的開源工作已經發布了第一個可用版本,歡迎大家試用,後續我們會增加更多演算法和預訓練模型。連結地址:https://github.com/alibaba/EssentialMC2。

6. 產品落地

隨著網際網路內容的影片化以及VR、元宇宙等應用的興起,非結構化影片內容數量正在高速增長,如何對這些內容進行快速識別、準確理解,成為內容價值挖掘關鍵的一環。

人物是影片中的重要內容,高精度的影片人物身份鑑別技術,能夠快速提取影片人物關鍵資訊,實現人物片段剪輯、人物搜尋等智慧應用。另外,對於影片的視覺、語音、文字多維度內容進行分析理解,識別人、事、物、場、標識等更豐富的影片內容實體標籤,可形成影片結構化資訊,幫助更全面地提取影片關鍵資訊。

更進一步,結構化的實體標籤作為語義推理的基礎,透過多模態資訊融合,幫助理解影片核心內容,實現影片內容高層語義分析,進而實現類目、主題理解。

阿里雲多媒體 AI 團隊的高準確率人物身份鑑別及影片分析技術,已整合於EssentialMC2核心演算法架構,並進行產品化輸出,支援對影片、影像的多維度內容進行分析理解並輸出結構化標籤(點選進行體驗:Retina影片雲多媒體 AI 體驗中心-智慧標籤產品 https://retina.aliyun.com/#/Label)。

多媒體AI產品

智慧標籤產品透過對影片中視覺、文字、語音、行為等資訊進行綜合分析,結合多模態資訊融合及對齊技術,實現高準確率內容識別,綜合影片類目分析結果,輸出貼合影片內容的多維度場景化標籤。

類目標籤:實現影片內容高層語義分析,進而實現類目、主題的理解,影片分類標籤,分為一級、二級和三級類目,實現媒資管理及個性化推薦應用。

實體標籤:影片內容識別的實體標籤,維度包括影片類目主題、影視綜漫IP、人物、行為事件、物品、場景、標識、畫面標籤,同時支援人物、IP的知識圖譜資訊。其中,影視綜漫的IP搜尋基於影片指紋技術,將目標影片與庫內的影視綜等資源進行指紋比對檢索,支援6萬餘部電影、電視劇、綜藝、動漫、音樂的IP識別,可分析識別出目標影片內容中包含哪一部電影、電視劇等IP內容,幫助實現精準的個性化推薦、版權檢索等應用。基於優酷、豆瓣、百科等各型別資料,構建了涵蓋影視綜、音樂、人物、地標、物體的資訊圖譜,對於影片識別命中的實體標籤,支援輸出知識圖譜資訊,可用於媒資關聯及相關推薦等應用。

關鍵詞標籤:支援影片語音識別及影片OCR文字識別,結合NLP技術融合分析語音及文字的文字內容,輸出與影片主題內容相關的關鍵詞標籤,用於精細化內容匹配推薦。

完善的標籤體系、靈活的定製化能力

智慧標籤產品綜合優酷、土豆、UC海外等平臺的PGC、UGC影片內容進行學習、訓練,提供最全面完善、高質量的影片標籤體系。在提供通用的標籤類目體系外,支援開放多層面定製化的能力,支援人臉自注冊、自定義實體標籤等擴充套件功能;面向客戶特定標籤體系的業務場景,採用標籤對映、定製化訓練等方式,提供一對一的標籤定製服務,更有針對性地幫助客戶解決平臺的影片處理效率問題。

高品質人機協同服務

針對要求準確的業務場景,智慧標籤產品支援引入人工互動判斷,形成高效、專業的人機協同平臺服務,AI識別演算法與人工相輔相成,提供面向個性化業務場景的精準影片標籤。

人機協同體系具備先進的人機協同平臺工具、專業的標註團隊,透過人員培訓、試執行、質檢、驗收環節等標準化的交付管理流程,確保資料標註質量,幫助快速實現高品質、低成本的標註資料服務。透過AI演算法+人工的人機協同方式,提供人工標註服務作為AI演算法的補充和修正,確保精準、高質量的服務輸出結果,實現業務效率和使用者體驗的提升。

體育行業和影視行業的影片標籤識別

傳媒行業和電商行業的影片標籤識別

以上能力均已整合到阿里雲影片雲智慧標籤產品,提供高品質的影片分析及人機協同服務,歡迎大家瞭解及體驗試用(智慧標籤產品 https://retina.aliyun.com/#/Label),搭建更高效、智慧化的影片業務應用。

參考文獻:

[1] Zheng Zhu, et al. Webface260m: A benchmark unveilingthe power of million-scale deep face recognition. CVPR 2021.

[2] Yao Feng, et al. Joint 3d face reconstruction and dense alignment with position map regression network. ECCV, 2018.

[3] Jun Wang et al. Facex-zoo: A pytorch toolbox for face recognition. _arxiv_, abs/2101.04407, 2021.

[4] Jiankang Deng et al. Masked Face Recognition Challenge: The InsightFace Track Report. arXiv, abs/2108.08191, 2021.

[5] Jiankang Deng, et al. Arcface: Additive angular margin loss for deep face recognition. CVPR 2019.

[6] Ming Lin, et al. Zen-NAS: A Zero-Shot NAS for High-Performance Image Recognition. ICCV 2021.

[7] Yuge Huang et al. Curricularface: Adaptive curriculum learning loss for deep face recognition. CVPR 2020.

[8] Jiawei Ren et al. Balanced meta-softmax for long-tailed visual recognition. NeurIPS, 2020.

[9] Xiang An, et al. Partial fc: Training 10 million identities on a single machine. ICCV 2021.

[10] Tao Feng, et al. Towards Mask-robust Face Recognition. ICCV 2021.