批次插入功能是我們日常工作中比較常見的業務功能之一,今天我們們來一個 MyBatis 批次插入的彙總篇,同時對 3 種實現方法做一個效能測試,以及相應的原理分析。

先來簡單說一下 3 種批次插入功能分別是:

- 迴圈單次插入;

- MP 批次插入功能;

- 原生批次插入功能。

準備工作

開始之前我們先來建立資料庫和測試資料,執行的 SQL 指令碼如下:

-- ----------------------------

-- 建立資料庫

-- ----------------------------

SET NAMES utf8mb4;

SET FOREIGN_KEY_CHECKS = 0;

DROP DATABASE IF EXISTS `testdb`;

CREATE DATABASE `testdb`;

USE `testdb`;

-- ----------------------------

-- 建立 user 表

-- ----------------------------

DROP TABLE IF EXISTS `user`;

CREATE TABLE `user` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`name` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin NULL DEFAULT NULL,

`password` varchar(255) CHARACTER SET utf8mb4 COLLATE utf8mb4_bin NULL DEFAULT NULL,

`createtime` datetime NULL DEFAULT CURRENT_TIMESTAMP,

PRIMARY KEY (`id`) USING BTREE

) ENGINE = InnoDB AUTO_INCREMENT = 6 CHARACTER SET = utf8mb4 COLLATE = utf8mb4_bin ROW_FORMAT = Dynamic;

-- ----------------------------

-- 新增測試資料

-- ----------------------------

INSERT INTO `user` VALUES (1, '趙雲', '123456', '2021-09-10 18:11:16');

INSERT INTO `user` VALUES (2, '張飛', '123456', '2021-09-10 18:11:28');

INSERT INTO `user` VALUES (3, '關羽', '123456', '2021-09-10 18:11:34');

INSERT INTO `user` VALUES (4, '劉備', '123456', '2021-09-10 18:11:41');

INSERT INTO `user` VALUES (5, '曹操', '123456', '2021-09-10 18:12:02');

SET FOREIGN_KEY_CHECKS = 1;

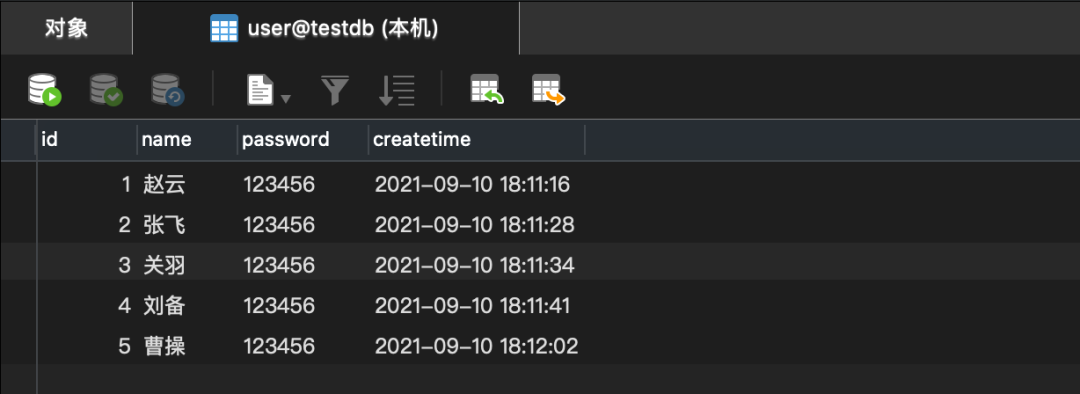

資料庫的最終效果如下:

1.迴圈單次插入

接下來我們將使用 Spring Boot 專案,批次插入 10W 條資料來分別測試各個方法的執行時間。

迴圈單次插入的(測試)核心程式碼如下:

import com.example.demo.model.User;

import com.example.demo.service.impl.UserServiceImpl;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

@SpringBootTest

class UserControllerTest {

// 最大迴圈次數

private static final int MAXCOUNT = 100000;

@Autowired

private UserServiceImpl userService;

/**

* 迴圈單次插入

*/

@Test

void save() {

long stime = System.currentTimeMillis(); // 統計開始時間

for (int i = 0; i < MAXCOUNT; i++) {

User user = new User();

user.setName("test:" + i);

user.setPassword("123456");

userService.save(user);

}

long etime = System.currentTimeMillis(); // 統計結束時間

System.out.println("執行時間:" + (etime - stime));

}

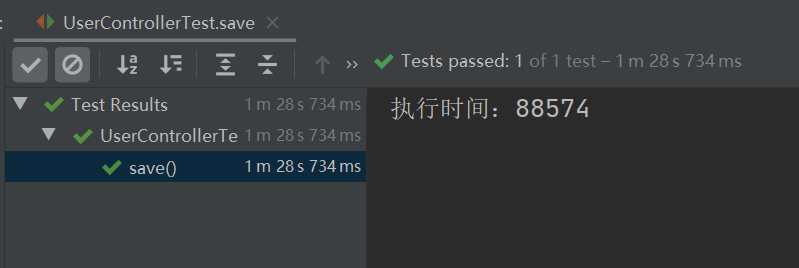

}執行以上程式,花費了 88574 毫秒,如下圖所示:

2.MP 批次插入

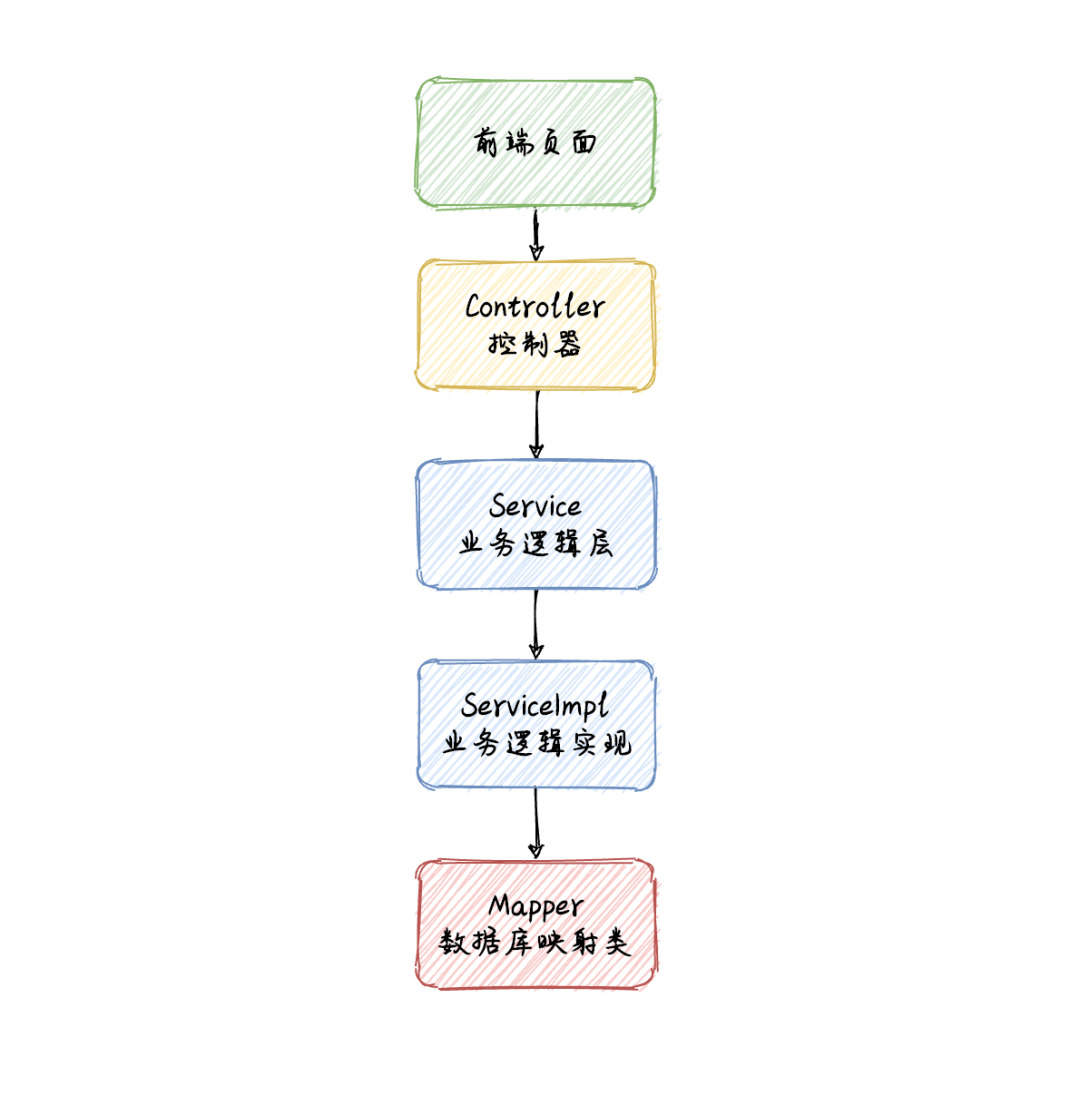

MP 批次插入功能核心實現類有三個:UserController(控制器)、UserServiceImpl(業務邏輯實現類)、UserMapper(資料庫對映類),它們的呼叫流程如下:

注意此方法實現需要先新增 MP 框架,開啟 pom.xml 檔案新增如下內容:

<dependency>

<groupId>com.baomidou</groupId>

<artifactId>mybatis-plus-boot-starter</artifactId>

<version>mybatis-plus-latest-version</version>

</dependency>注意:mybatis-plus-latest-version 表示 MP 框架的最新版本號,可訪問 https://mvnrepository.com/art... 查詢最新版本號,但在使用的時候記得一定要將上面的 “mybatis-plus-latest-version”替換成換成具體的版本號,如 3.4.3 才能正常的引入框架。

更多 MP 框架的介紹請移步它的官網:https://baomidou.com/guide/

① 控制器實現

import com.example.demo.model.User;

import com.example.demo.service.impl.UserServiceImpl;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

import java.util.ArrayList;

import java.util.List;

@RestController

@RequestMapping("/u")

public class UserController {

@Autowired

private UserServiceImpl userService;

/**

* 批次插入(自定義)

*/

@RequestMapping("/mysavebatch")

public boolean mySaveBatch(){

List<User> list = new ArrayList<>();

// 待新增(使用者)資料

for (int i = 0; i < 1000; i++) {

User user = new User();

user.setName("test:"+i);

user.setPassword("123456");

list.add(user);

}

return userService.saveBatchCustom(list);

}

}② 業務邏輯層實現

import com.baomidou.mybatisplus.extension.service.impl.ServiceImpl;

import com.example.demo.mapper.UserMapper;

import com.example.demo.model.User;

import com.example.demo.service.UserService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import java.util.List;

@Service

public class UserServiceImpl extends ServiceImpl<UserMapper,User>

implements UserService {

@Autowired

private UserMapper userMapper;

public boolean saveBatchCustom(List<User> list){

return userMapper.saveBatchCustom(list);

}

}③ 資料持久層實現

import com.baomidou.mybatisplus.core.mapper.BaseMapper;

import com.example.demo.model.User;

import org.apache.ibatis.annotations.Mapper;

import java.util.List;

@Mapper

public interface UserMapper extends BaseMapper<User>{

boolean saveBatchCustom(List<User> list);

}經過以上程式碼實現,我們就可以使用 MP 來實現資料的批次插入功能了,但本篇除了具體的實現程式碼之外,我們還要知道每種方法的執行效率,所以接下來我們來編寫 MP 的測試程式碼。

MP 效能測試

import com.example.demo.model.User;

import com.example.demo.service.impl.UserServiceImpl;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import java.util.ArrayList;

import java.util.List;

@SpringBootTest

class UserControllerTest {

// 最大迴圈次數

private static final int MAXCOUNT = 100000;

@Autowired

private UserServiceImpl userService;

/**

* MP 批次插入

*/

@Test

void saveBatch() {

long stime = System.currentTimeMillis(); // 統計開始時間

List<User> list = new ArrayList<>();

for (int i = 0; i < MAXCOUNT; i++) {

User user = new User();

user.setName("test:" + i);

user.setPassword("123456");

list.add(user);

}

// MP 批次插入

userService.saveBatch(list);

long etime = System.currentTimeMillis(); // 統計結束時間

System.out.println("執行時間:" + (etime - stime));

}

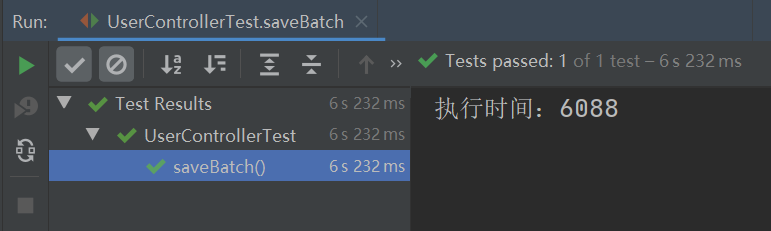

}以上程式的執行總共花費了 6088 毫秒,如下圖所示:

從上述結果可知,使用 MP 的批次插入功能(插入資料 10W 條),它的效能比迴圈單次插入的效能提升了 14.5 倍。

MP 原始碼分析

從 MP 和迴圈單次插入的執行時間我們可以看出,使用 MP 並不是像有些朋友認為的那樣,還是迴圈單次執行的,為了更清楚的說明此問題,我們檢視了 MP 的原始碼。

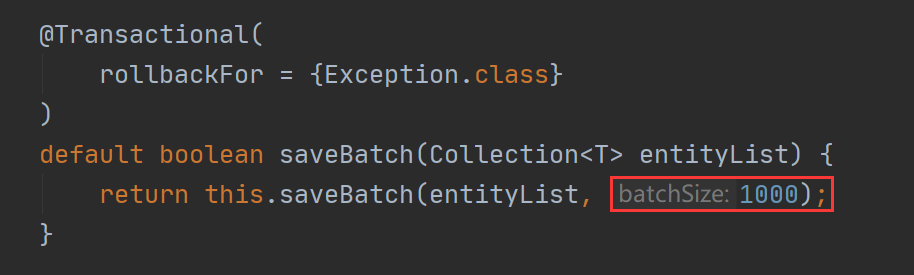

MP 的核心實現程式碼是 saveBatch 方法,此方法的原始碼如下:

我們繼續跟進 saveBatch 的過載方法:

從上述原始碼可以看出,MP 是將要執行的資料分成 N 份,每份 1000 條,每滿 1000 條就會執行一次批次插入,所以它的效能要比迴圈單次插入的效能高很多。

那為什麼要分批執行,而不是一次執行?彆著急,當我們看了第 3 種實現方法之後我們就明白了。

3.原生批次插入

原生批次插入方法是依靠 MyBatis 中的 foreach 標籤,將資料拼接成一條原生的 insert 語句一次性執行的,核心實現程式碼如下。

① 業務邏輯層擴充套件

在 UserServiceImpl 新增 saveBatchByNative 方法,實現程式碼如下:

import com.baomidou.mybatisplus.extension.service.impl.ServiceImpl;

import com.example.demo.mapper.UserMapper;

import com.example.demo.model.User;

import com.example.demo.service.UserService;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.stereotype.Service;

import java.util.List;

@Service

public class UserServiceImpl extends ServiceImpl<UserMapper, User>

implements UserService {

@Autowired

private UserMapper userMapper;

public boolean saveBatchByNative(List<User> list) {

return userMapper.saveBatchByNative(list);

}

}② 資料持久層擴充套件

在 UserMapper 新增 saveBatchByNative 方法,實現程式碼如下:

import com.baomidou.mybatisplus.core.mapper.BaseMapper;

import com.example.demo.model.User;

import org.apache.ibatis.annotations.Mapper;

import java.util.List;

@Mapper

public interface UserMapper extends BaseMapper<User> {

boolean saveBatchByNative(List<User> list);

}③ 新增 UserMapper.xml

建立 UserMapper.xml 檔案,使用 foreach 標籤拼接 SQL,具體實現程式碼如下:

<?xml version="1.0" encoding="UTF-8"?>

<!DOCTYPE mapper PUBLIC "-//mybatis.org//DTD Mapper 3.0//EN" "http://mybatis.org/dtd/mybatis-3-mapper.dtd">

<mapper namespace="com.example.demo.mapper.UserMapper">

<insert id="saveBatchByNative">

INSERT INTO `USER`(`NAME`,`PASSWORD`) VALUES

<foreach collection="list" separator="," item="item">

(#{item.name},#{item.password})

</foreach>

</insert>

</mapper>經過以上步驟,我們原生的批次插入功能就實現的差不多了,接下來我們使用單元測試來檢視一下此方法的執行效率。

原生批次插入效能測試

import com.example.demo.model.User;

import com.example.demo.service.impl.UserServiceImpl;

import org.junit.jupiter.api.Test;

import org.springframework.beans.factory.annotation.Autowired;

import org.springframework.boot.test.context.SpringBootTest;

import java.util.ArrayList;

import java.util.List;

@SpringBootTest

class UserControllerTest {

// 最大迴圈次數

private static final int MAXCOUNT = 100000;

@Autowired

private UserServiceImpl userService;

/**

* 原生自己拼接 SQL,批次插入

*/

@Test

void saveBatchByNative() {

long stime = System.currentTimeMillis(); // 統計開始時間

List<User> list = new ArrayList<>();

for (int i = 0; i < MAXCOUNT; i++) {

User user = new User();

user.setName("test:" + i);

user.setPassword("123456");

list.add(user);

}

// 批次插入

userService.saveBatchByNative(list);

long etime = System.currentTimeMillis(); // 統計結束時間

System.out.println("執行時間:" + (etime - stime));

}

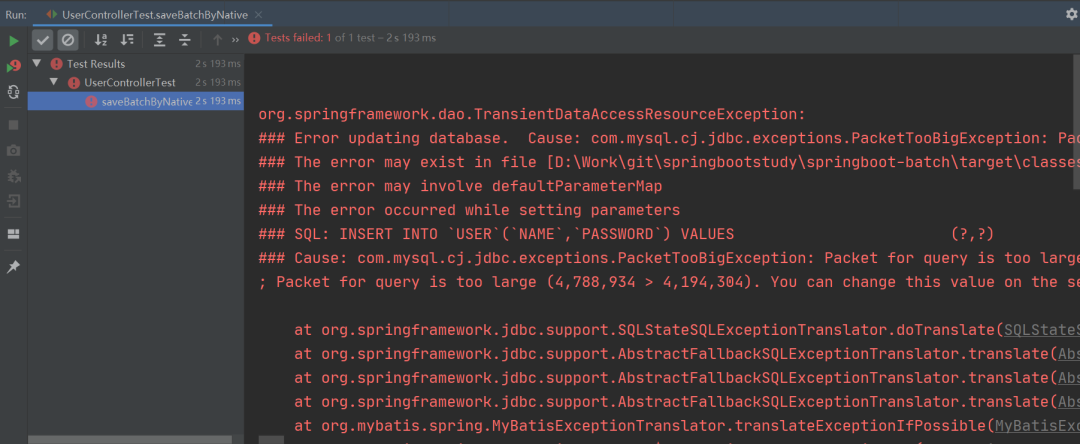

}然而,當我們執行程式時卻發生了以下情況:

納尼?程式的執行竟然報錯了。

缺點分析

從上述報錯資訊可以看出,當我們使用原生方法將 10W 條資料拼接成一個 SQL 執行時,由於拼接的 SQL 過大(4.56M)從而導致程式執行報錯,因為預設情況下 MySQL 可以執行的最大 SQL(大小)為 4M,所以程式就報錯了。

這就是原生批次插入方法的缺點,也是為什麼 MP 需要分批執行的原因,就是為了防止程式在執行時,因為觸發了資料庫的最大執行 SQL 而導致程式執行報錯。

解決方案

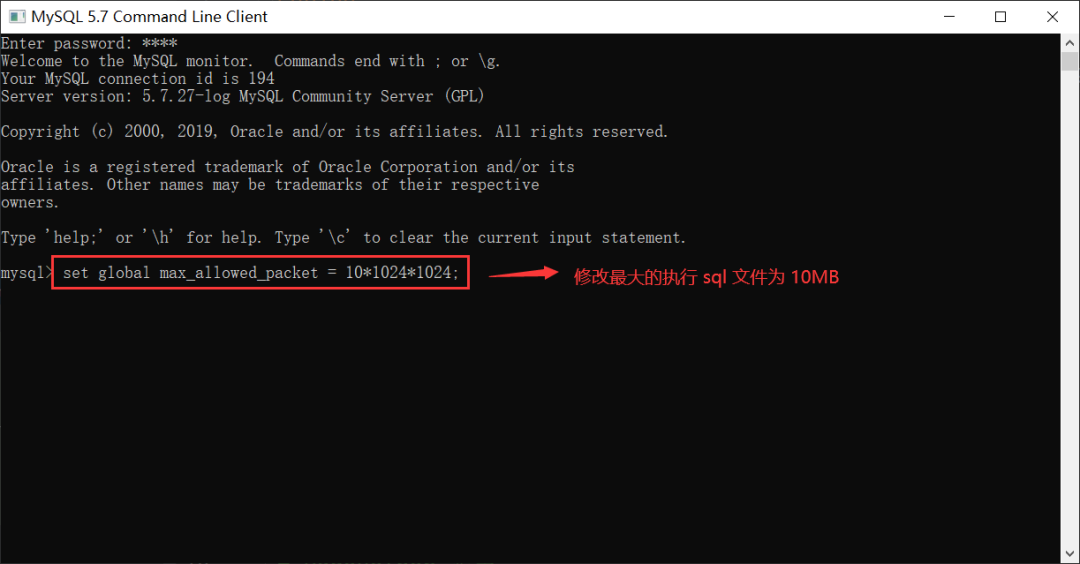

當然我們也可以透過設定 MySQL 的最大執行 SQL 來解決報錯的問題,設定命令如下:

-- 設定最大執行 SQL 為 10Mset global max_allowed_packet=10*1024*1024;如下圖所示:

注意:以上命令需要在 MySQL 連線的客戶端中執行。

但以上解決方案仍是治標不治本,因為我們無法預測程式中最大的執行 SQL 到底有多大,那麼最普世的方法就是分配執行批次插入的方法了(也就是像 MP 實現的那樣)。

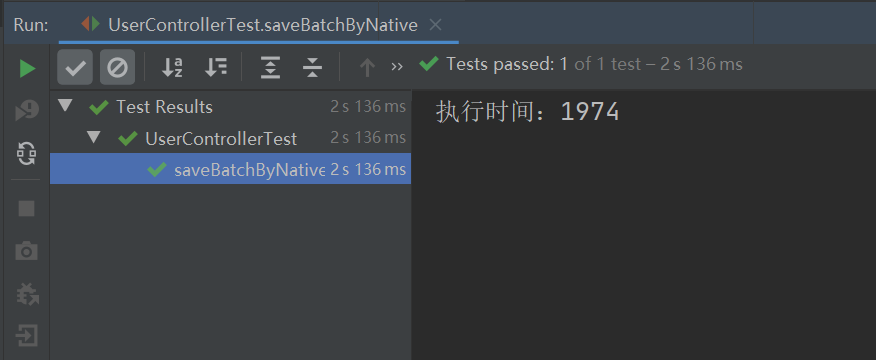

當我們將 MySQL 的最大執行 SQL 設定為 10M 之後,執行以上單元測試程式碼,執行的結果如下:

總結

本文我們介紹了 MyBatis 批次插入的 3 種方法,其中迴圈單次插入的效能最低,也是最不可取的;使用 MyBatis 拼接原生 SQL 一次性插入的方法效能最高,但此方法可能會導致程式執行報錯(觸發了資料庫最大執行 SQL 大小的限制),所以綜合以上情況,可以考慮使用 MP 的批次插入功能。