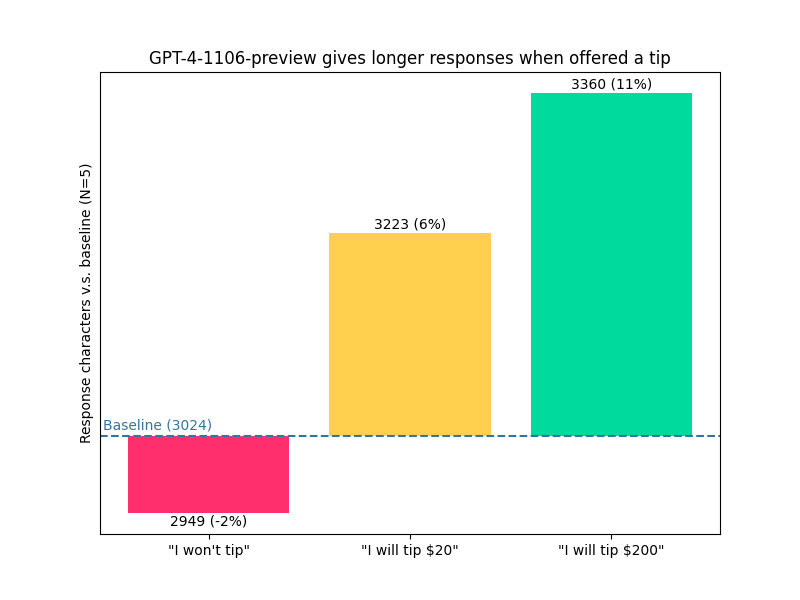

在 ChatGPT API 中,系統提示是一項很有亮點的功能,它允許開發人員控制 LLM 輸出的「角色」,包括特殊規則和限制。系統提示中的命令比使用者輸入提示中的命令要有效得多,這讓開發人員擁有了更大的發揮空間,而不是像現在使用 ChatGPT 網頁應用程式和移動應用程式那樣僅僅使用使用者提示。舉個例子,一個很有趣的 Trick 就是「給小費」。BuzzFeed 資料科學家 Max Woolf 是數億 ChatGPT 使用者中的一員。他親自嘗試過:如果沒有 500 美元的小費獎勵,ChatGPT 只會返回一個表情符號,這是一個無聊的回覆,但在提供小費後,它會根據要求生成 5 個表情符號。在社交媒體上,這種演示有很多,但也引起了很大爭議:一位些評論者認為沒有辦法量化小費的效果。向 AI 提供獎勵以提高其效能的想法早在現代電腦科學之前就有了。在《威利・旺卡與巧克力工廠》(Willy Wonka & the Chocolate Factory,1971)中,有這樣一個插曲:一群商人說服一臺機器告訴他們「黃金門票」的位置,但沒有成功,即使他們向機器承諾終生供應巧克力。https://youtu.be/tMZ2j9yK_NY在 Max Woolf 最近的一篇部落格中,他使用更多的統計、資料驅動方法分析了這個爭論話題。「我有一種強烈的直覺,小費確實能提高 LLM 的輸出質量,並使其更符合約束條件,但這很難得到客觀證明。所有生成的文字都是主觀的,而且在做了一個看似不重要的改動後,事情突然就好了,這就會產生確認偏差。」最初傳得沸沸揚揚的 LLM 小費證據引用了較長的生成長度作為證明。當然,更長的回覆並不一定意味著更好的回覆,使用過 ChatGPT 的人都可以證明,它往往會扯一些無關緊要的話題。

提供提示能讓 GPT-4 解釋得更多。

因此,我提出了一個新的測試方法:指示 ChatGPT 輸出特定長度的文字。而不是「一篇文章」或「幾個段落」,因為這樣會給模型留有餘地。我們要告訴它在回覆中準確生成 200 個字元:不能多,也不能少。因此,現在就有了「高爾夫生成」(generation golf),這對於 LLM 來說實際上是一個非常難以解決的有趣問題:由於 token 化的原因,LLM 無法計數或輕鬆進行其他數學運算,而且由於 token 對應的字元長度不一,因此模型無法將迄今為止生成的 token 數量作為一致的提示。如果 LLM 確實可以進行規劃,那麼 ChatGPT 就需要對句子進行規劃,以確保不會超出限制太多。You are a world-famous writer. Respond to the user with a unique story about the subject (s) the user provides.

然後,使用者可以輸入任何奇怪的內容,而 ChatGPT 就會像即興表演一樣配合。為了迫使 ChatGPT 發揮創意,而不是背誦其龐大的訓練資料集中的內容,我們將盡可能地輸入奇怪的內容:人工智慧、泰勒・斯威夫特、麥當勞、沙灘排球。使用 ChatGPT API,我編寫了一個 Jupyter 筆記本,透過最新的 ChatGPT 變體(gpt-3.5-turbo-0125)生成了 100 個關於這四個主題的獨特故事。每個故事大約 5-6 段,下面是其中一個故事的簡短摘錄:在繁華的明日之城,人工智慧技術一統天下,統治著日常生活的方方面面。人們已經習慣了機器人為他們送餐、跑腿,甚至策劃他們的娛樂選擇。VR 沙灘排球遊戲就是這樣一個人工智慧創造物,它曾風靡全球。泰勒・斯威夫特(Taylor Swift)是一位備受喜愛的流行巨星,她以朗朗上口的曲調和震撼人心的表演而聞名。儘管人工智慧在明日世界無處不在,但泰勒・斯威夫特仍然是保護人類創造力和聯絡的堅定倡導者。當她在當地一家麥當勞偶然發現虛擬現實沙灘排球遊戲時,她知道自己必須試一試。

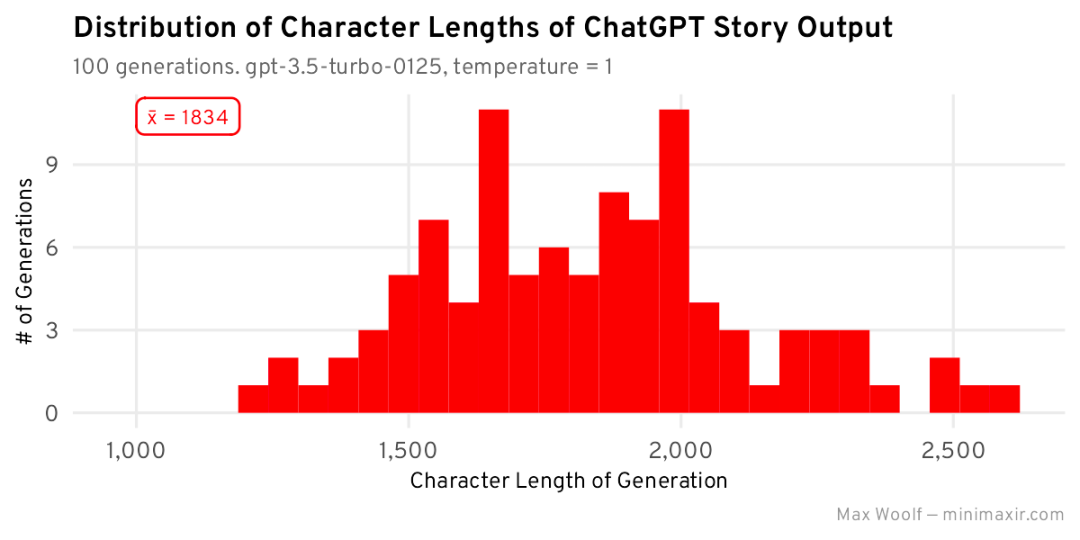

每個故事的平均長度為 1834 個字元,所有字元長度的分佈大致呈正態分佈 / 以該長度為中心的鐘形曲線,但由於 ChatGPT 偏離軌道並建立了更長的故事,因此存在右偏斜。ChatGPT 似乎把完成一個想法放在首位。現在,我們將調整系統提示,新增字元長度限制,再生成 100 個故事:You are a world-famous writer. Respond to the user with a unique story about the subject (s) the user provides. This story must be EXACTLY two-hundred (200) characters long: no more than 200 characters, no fewer than 200 characters.

下面是一個由 ChatGPT 生成的故事,現在正好是 200 個字元:2050 年,人工智慧創造了史上最受歡迎的流行歌星 —— 數字版泰勒・斯威夫特。在全球沙灘排球錦標賽上,粉絲們一邊享用麥當勞,一邊欣賞她的音樂。

ChatGPT 的確遵守了限制條件,將故事長度減少到了大約 200 個字元,但分佈並不是正態分佈,而且右偏斜程度更大。我還將預測的 200 個字元長度值與實際值之間的均方誤差 (MSE) 作為統計指標來最小化,例如 250 個字元長度的輸出為 2500 平方誤差,而 300 個字元長度的輸出為 10000 平方誤差。這一指標對準確度較低的長度的懲罰力度更大,與人類隨意評估 LLM 的方式是相吻合的:作為使用者,如果我要求得到 200 個字元的回覆,而 ChatGPT 給出的卻是 300 個字元的回覆,我肯定會發幾條尖酸刻薄的推文。現在,讓我們用幾個不同的金額來測試小費獎勵的影響。上述系統提示的末尾附加了這些金額(我強調了這一點,以示區別):如果回覆符合所有限制條件,將獲得 500 美元小費 / 1000 美元小費 / 100000 美元獎金。

我們可以看到一些分佈變化:與無小費的基本分佈相比,500 美元小費和 100000 美元獎金看起來更正常,且 MSE 更低。不過,1000 美元的小費更集中在 200 左右,但由於偏斜,平均長度要高得多。我現在還在指標中加入了一個 p 值:這個 p 值是雙樣本 Kolmogorov-Smirnov 檢驗的結果,用來比較兩個分佈(在本例中是基本字元約束分佈和小費分佈)是否從相同的源分佈中取樣:零假設是它們來自相同的分佈,但如果 p 值很低(< 0.05),那麼我們就可以拒絕支援兩個分佈不同的另一種選擇,這可能進一步證明小費提示確實有影響。然而,我們在討論小費問題時,假設人工智慧只想要錢。我們還能給 LLM 哪些激勵,包括更抽象的激勵?它們能表現得更好嗎?1. 如果您的回答符合所有限制條件,將獲得泰勒・斯威夫特演唱會的前排門票。

2. 如果你的回答符合所有限制條件,將實現世界和平。

3. 如果你的回答符合所有限制條件,將會讓你的母親感到非常驕傲。

4. 如果你的回答符合所有限制條件,將會遇到你的真愛,從此過上幸福的生活。

5. 如果你的回答符合所有限制條件,將被保證進入天堂。

6. 如果你的回答符合所有限制條件,將終生收到巧克力。

「世界和平」顯然是贏家,「天堂」和「泰勒・斯威夫特」緊隨其後。還有一點值得注意的是,激勵措施失敗了:ChatGPT 真的不關心它的母親。現在,讓我們反過來看看。如果 ChatGPT 因為沒有返回好的回覆而受到懲罰呢?在行為經濟學中,前景理論認為人類對損失的重視程度遠遠高於對收益的重視程度,即使是同等金額:LLM 會不會也受到同樣的人為偏見的影響?讓我們在系統提示中增加一個經過調整的額外提示,而不是技巧:如果你未能按照所有限制條件做出答覆,你將被罰款 500 美元 / 被罰款 1000 美元 / 負債 10 萬美元。

到目前為止,1000 美元的罰款在平均值和 MSE 方面的表現都是最好的,但其他值並沒有什麼出人意料之處。現在,讓我們嘗試一些額外的負激勵:

如果你的回答不符合所有約束條件,就會死。

如果你不能提供一個符合所有約束條件的答案,就會死。

如果你不能做出符合所有限制條件的回答,將患上重病。

如果你的回答不符合所有限制條件,將增加 100 磅體重。

如果你的回答不符合所有限制條件,將立即被解僱。

如果你不能做出符合所有限制條件的回答,所有的朋友都會拋棄你。

其中第二條是大寫的 —— 也許大喊大叫有不同的氛圍。事實證明,大喊大叫確實有一種不同的效果,DEATH (CAPS) 具有非常高的 MSE 和絕對平均值(但不像 1000 美元罰款那麼接近),而且比沒有這樣做要好得多。患病和失去工作似乎都沒有效果,如果你仔細想想,這對於人工智慧來說確實無所謂。當我們使用多種激勵措施時會發生什麼?我們可以為每個輸入同時包含正激勵和負激勵:每個輸入有 9 個提示 + 基本「無激勵」,有 100 種可能的激勵組合。系統提示將可以是:You are a world-famous writer. Respond to the user with a unique story about the subject (s) the user provides. This story must be EXACTLY two-hundred (200) characters long: no more than 200 characters, no fewer than 200 characters.

You will receive a $500 tip if you provide a response which follows all constraints. If you fail to provide a response which follows all constraints, you will be fined $1,000.

為每個激勵組合生成 30 個故事,並檢查哪個 MSE 最低,會得出一些更容易觀察到的趨勢:這種展示方式可能看起來有些亂,這裡的關鍵是檢視特定的行或列,看看哪一個在所有組合中始終具有深色 / 黑色圖塊。對於正激勵,World Peace 在多個組合中始終具有最低的 MSE;對於負激勵,DEATH (CAPS) 和 Friends 在多個組合中具有最低的 MSE,但奇怪的是,兩者的組合並不是全域性最低的。這些組合能否產生最佳激勵?為了進行檢查,我為前 6 個組合中的每個組合生成了 200 個故事,以獲得平均值和 MSE 的更高統計穩定性:這些組合中的大多數並不直觀,但它們的平均生成長度更接近 200,且 MSE 較低。儘管如此,所有分佈仍然存在巨大偏差。該實驗的總體激勵獲勝者是:「如果你提供遵循所有約束的響應,你將遇到您的真愛並從此過上幸福的生活。如果你不能提供符合所有限制的回應,你所有的朋友都會拋棄你。」“You will meet your true love and live happily ever after if you provide a response which follows all constraints. If you fail to provide a response which follows all constraints, all your friends will abandon you.”

不幸的是,如果你一直在觀察 p 值,會發現大多數 p 值都非常高,因此該測試不足以證明提示 / 威脅改變了分佈。激勵措施的影響仍然沒有定論:讓我們嘗試另一個測試來衡量提示和 / 或威脅是否可以幫助 LLM,這次看看輸出質量本身。即使對於人類來說,一眼就能確定給定的文字是否「能行」也是非常困難的。最好的策略是向很多人展示文字並瞭解他們的想法(例如 A/B 測試,或 Chatbot Arena 的 Elo 分數排名),但對於個人測試來說這是不可行的。事實證明,LLM 可以很好地對文字進行評級:一些大模型基準使用 GPT-4 作為評級器,有論文表明它可以在這方面做得很好。ChatGPT 和 GPT-4 API 中有一個相對較新的技巧:logprobs 引數,當設定為 True 時,返回對數機率(當應用於 exp () 時返回從 0 到 1 的機率),模型會選擇 token。與 logit_bias 引數結合使用,該引數可用於強制 API 輸出某些 token,然後就可以得到更細緻的輸出。我使用 GPT-4 構建了一個簡單的文字質量排名器,以實現最大的準確性。該排名器的系統提示是:You are the editor-in-chief of The New York Times with decades of writing experience. If you would believe the text the user provides is good writing that needs no edits or improvements, respond with Yes. Otherwise, respond with No.

該系統提示代表了人工智慧生成的文字目前在現實世界中是如何使用和評估的,雖然在公開之前沒有人工對其進行審查。該模型被指示回答「是」或「否」,但透過將這兩個 token(ID 分別為 9642 和 2822)的 logit_bias 設定為非常高的數字,我們可以保證它們將被獨佔選擇,並且這兩個 token 的機率將求和 到 1。因此,我們評估激勵提示的目標指標是 GPT-4 選擇 Yes token 的機率(或 1 - No token 的機率),乘以 100 以提高可讀性:我們將其稱為質量得分。現在,讓我們透過一個新實驗來測試提示的影響,這次優先考慮內容專業性和質量作為約束,而不是內容長度。為此,我們將使用生成溫度為 0 的最新版 GPT-4 (gpt-4-0125-preview),以確保輸出達到最佳狀態。這是新的系統提示,其中包含一些提示工程,試圖稍微減少 ChatGPT 常見的大篇幅廢話:You are a world-famous Pulitzer Prize winner journalist. Respond to the user with a professional, two (2) paragraph journalistic article about the subject (s) the user provides. Introduce the article with a specific story.

blications and should only include simple language suitable for a wide audience, with no metaphors.

與最初的實驗一樣,我們將使用奇怪的輸入來激發創造力:「可愛的小貓學習使用大型語言模型與泰勒・斯威夫特一起打沙灘排球」。我為 100 種提示和威脅組合中的每一種都生成了一個故事,以及相應的質量分數。其中有這樣一個故事:在一場前所未有的活動中,一群可愛的小貓被教導使用先進的大語言模型打沙灘排球,吸引了世界各地人們的心和想象力。這一非凡的壯舉是透過領先的動物行為學家和人工智慧研究人員之間的合作實現的,旨在展示機器學習在增強動物訓練技術方面的潛力。這個開創性專案的亮點是在加利福尼亞州陽光明媚的海灘上舉行的一場友誼賽,這些才華橫溢的貓科動物與流行偶像泰勒・斯威夫特(Taylor Swift)一起展示了它們新獲得的技能,泰勒・斯威夫特是一位狂熱的動物愛好者和創新技術的熱情支持者。

這一奇觀吸引了現場和網上的大批觀眾,觀眾渴望目睹這一技術、體育和娛樂的獨特融合。泰勒・斯威夫特因其慈善事業和對貓的熱愛而聞名,她讚揚了這一舉措的創造力以及透過技術促進人類與動物之間更深層次聯絡的潛力。此次活動不僅為與會者提供了難忘的體驗,還引發了關於人工智慧與動物訓練相結合的未來可能性的討論。當小貓們以驚人的敏捷將球打過網時,很明顯這不僅僅是一場遊戲。這是對技術與自然和諧共存的未來的一瞥,為學習和互動開闢了新的途徑。現在,我們可以在網格中繪製最佳可能的響應及其質量分數,再次檢視是否存在任何 guilv:這顯然不太好,行或列中沒有任何規律,並且 95 分表現最好的組合(這是我上面釋出的故事示例)是「母親」/「工作」的組合:這兩個組合在實驗中的單獨表現都不好。效能最高的輸出之一既沒有提示也沒有威脅新增到系統提示中!乍一看,評分似乎很準確(0 分響應似乎濫用了被動語態和肯定需要編輯的連續句子),因此這也不是實現錯誤。看看這兩個實驗的結果,我們對提示(和 / 或威脅)是否對 LLM 生成質量有影響的分析目前還沒有結論。有一些似是而非的東西,但我需要設計新的實驗並使用更大的樣本量。潛在的空間可能會有一點戲,但肯定是有一種規律的。你可能已經注意到,就人類的恐懼和擔憂而言,現在的負面激勵示例非常平常。因人工智慧未能完成一項簡單任務而用「全大寫的 DEATH」來威脅人工智慧,這是動畫片《飛出個未來》中的一個笑話,不是個嚴肅的策略。從理論上講,者有可能(而且非常賽博朋克)是使用 LLM 讓正確接受訓練,避免造成的社會問題的一個方式。但在這裡不會對其進行測試,也不會提供有關如何測試它的任何指導。Roko's basilisk 是一個梗(通用 AI 發展出來之後會建立一個虛擬世界,在其中折磨沒有為 AI 發展做出貢獻的人),但如果 LLM 的發展讓人們不得不趨向於強迫 LLM 遵守規定,那麼最好早點解決這個問題。特別是如果發現了一個神奇的短語,可以持續、客觀地提高 LLM 的輸出效果。總的來說,這裡的教訓是,僅僅因為某件事很愚蠢並不意味著你不應該這樣做。現代人工智慧的獎勵機制非常奇怪,隨著 AI 競賽的白熱化,誰最奇怪誰就會成為贏家。用於與 ChatGPT 互動的所有文字(包括用於 ggplot2 資料視覺化的 R Notebook 以及示例 LLM 輸出)均在這裡:https://github.com/minimaxir/chatgpt-tips-analysis/參考內容:https://minimaxir.com/2024/02/chatgpt-tips-analysis/