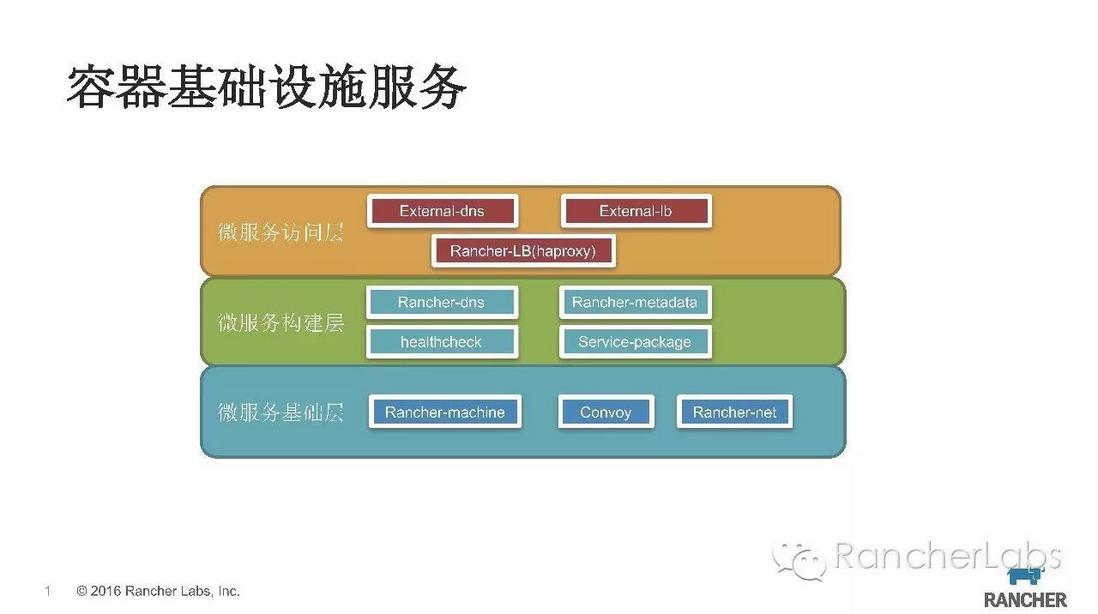

站在微服務的角度看容器的基礎設施服務可以分為三層:

微服務基礎層

微服務構建層

微服務訪問層

Rancher的服務發現就是基於rancher-dns來實現,建立的stack&service都會生成相應的DNS記錄,使用者可以透過相應的規則進行訪問,這樣在微服務之間就可以無需知曉各自的IP地址,直接用服務名進行連線即可。

微服務基礎層主要是為容器提供計算、儲存、網路等基礎資源。主機計算資源主要是對docker-machine封裝來提供相關服務;容器儲存透過Convoy元件來接入,目前對NFS協議的儲存適配性最佳;容器之間的網路透過rancher-net元件實現,目前支援ipsec overlay,在Rancher1.2版本會支援CNI標準的網路外掛。

微服務構建層,除了有微服務本身主體程式,還需要有一些額外的輔助工具來完善對應微服務的架構體系。rancher-dns來實現服務發現機制;rancher-metadata可以靈活動態向微服務所在容器中注入一些配置資料;healthcheck來保證微服務的高可用;同時我們還需要有微服務打包的工具,保證微服務可以在任意環境拉起執行。

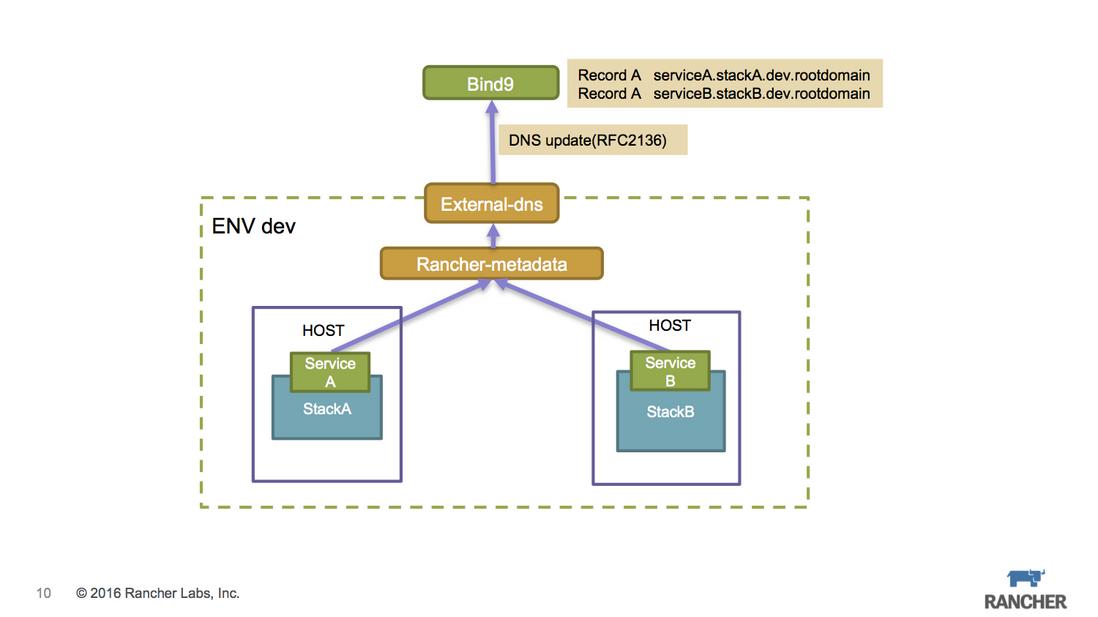

微服務訪問層,目前服務對外暴露訪問主要以DNS繫結或是負載均衡VIP方式。Rancher提供external-dns、external-lb框架可以讓高階使用者hack自身的場景需求,external-dns除了支援公共的DNS服務(如route53),還支援內部DNS伺服器(如bind9),而external-lb目前支援F5裝置。除此之外,Rancher內建的負載均衡是基於Haproxy實現的,支援L4-L7。

本次分享,我將會以概念介紹原理講解並穿插一些實際案例這樣的方式進行分享。

Rancher的後設資料服務rancher-metadata靈活性非常大,比較複雜的微服務架構可以透過metadata實現一定程度的解耦,尤其是confd+metadata會有意想不到妙用,這部分內容可以參考 http://niusmallnan.github.io/...

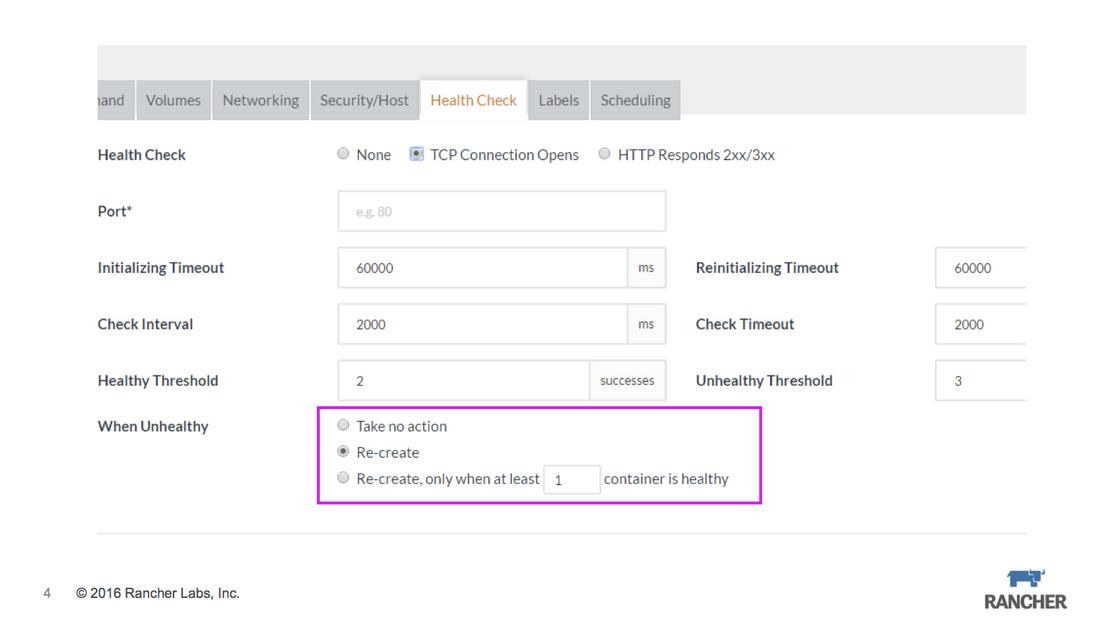

Rancher的healthcheck基於Haproxy實現,支援TCP/HTTP,當unhealthy觸發時按照預先設定的策略執行:

什麼也不做

按照scale的容器數量重建

保證至少x個healthy的容器數量

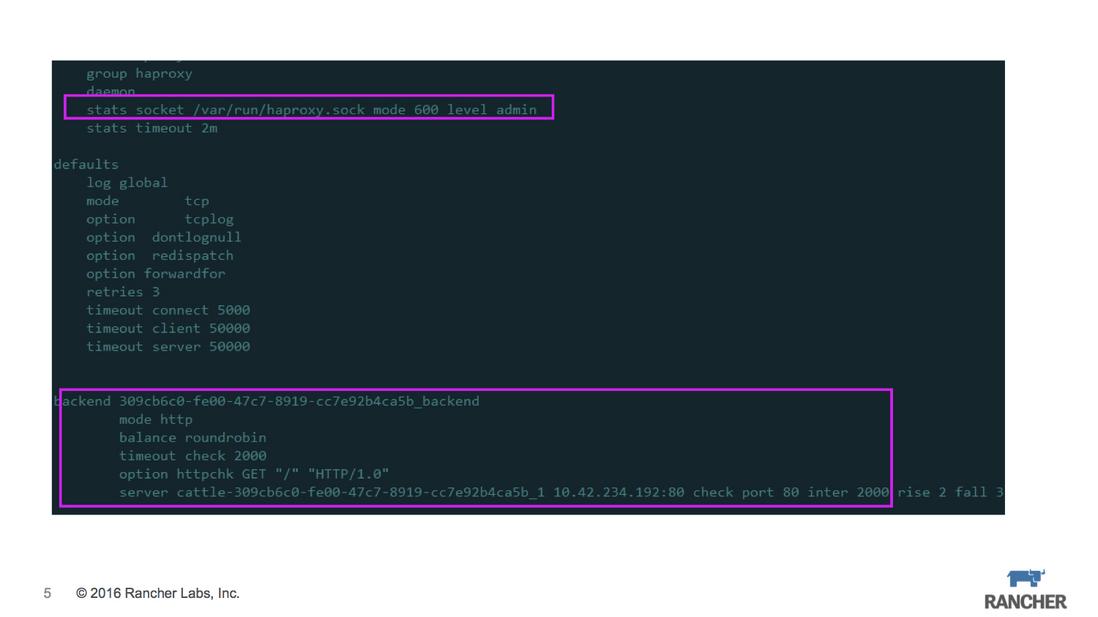

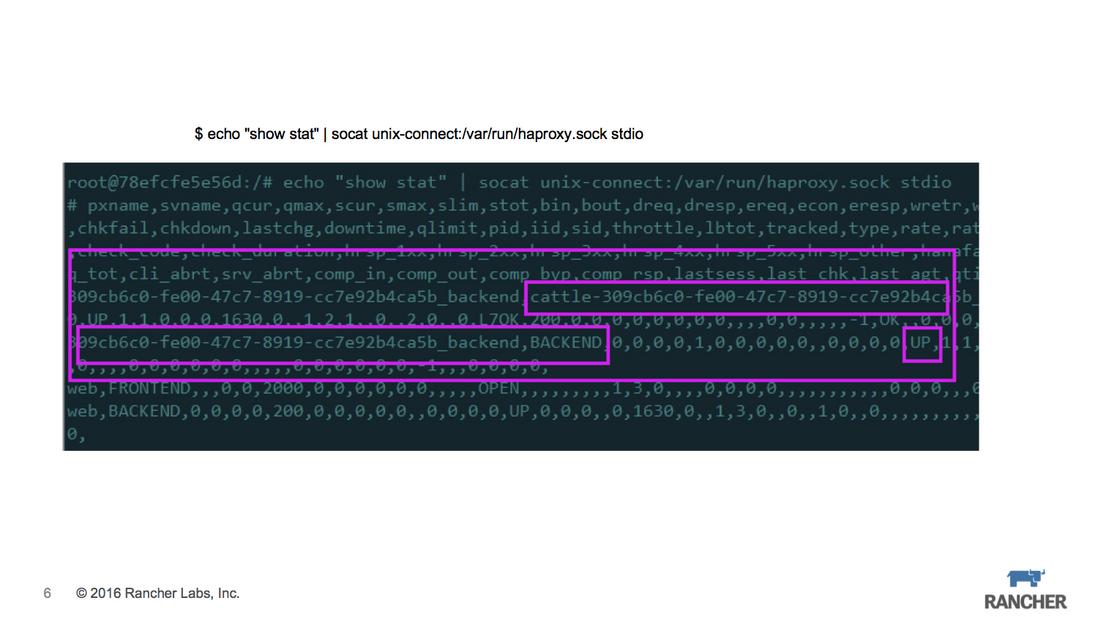

當針對某個service建立healthcheck策略後,service中容器所在的agent節點上會啟動Haproxy服務,同時把healthcheck的配置轉化為Haproxy的配置。如圖中所示新增了backend,其對應的ip就是container的ip。此外還要將Haproxy的stats scket暴露出來,以便讀取backend的狀態資訊。

我們可以在外部程式中與Haproxy sock通訊,可以獲取相關backend的狀態資訊,由於我們在Haproxy中設定check機制,所以backend的狀態是會自動更新的。

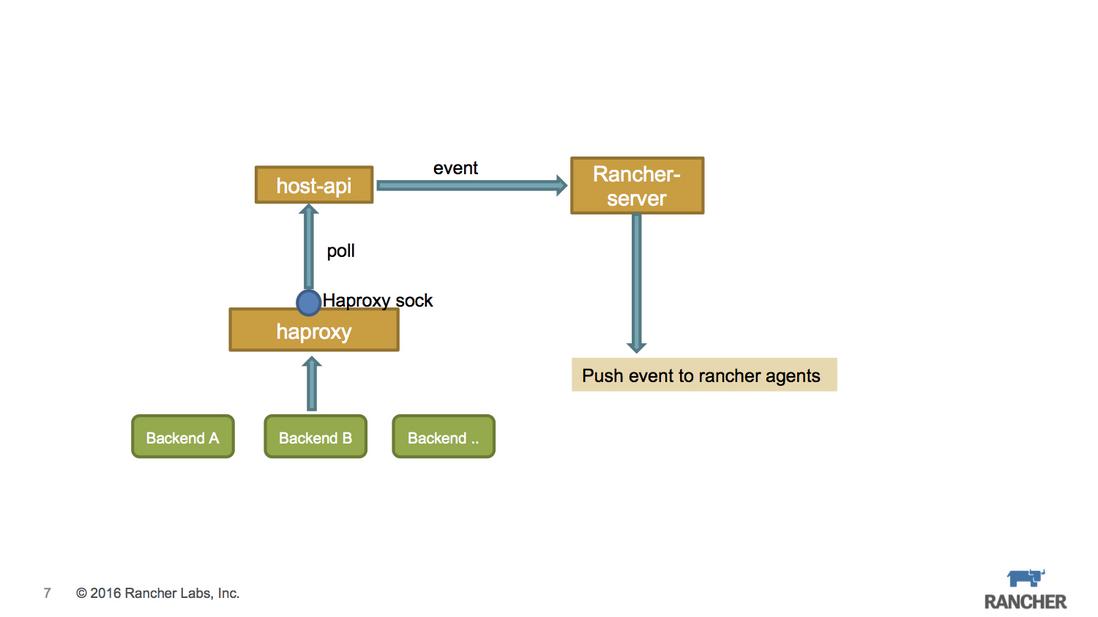

Rancher Agent上執行的host-api元件透過Haproxy sock來讀取backend狀態資訊,同時透過rancher event機制把狀態資訊push給rancher-server,rancher-server根據之前設定的healthcheck策略,來控制相關的rancher agent執行container recreate操作。

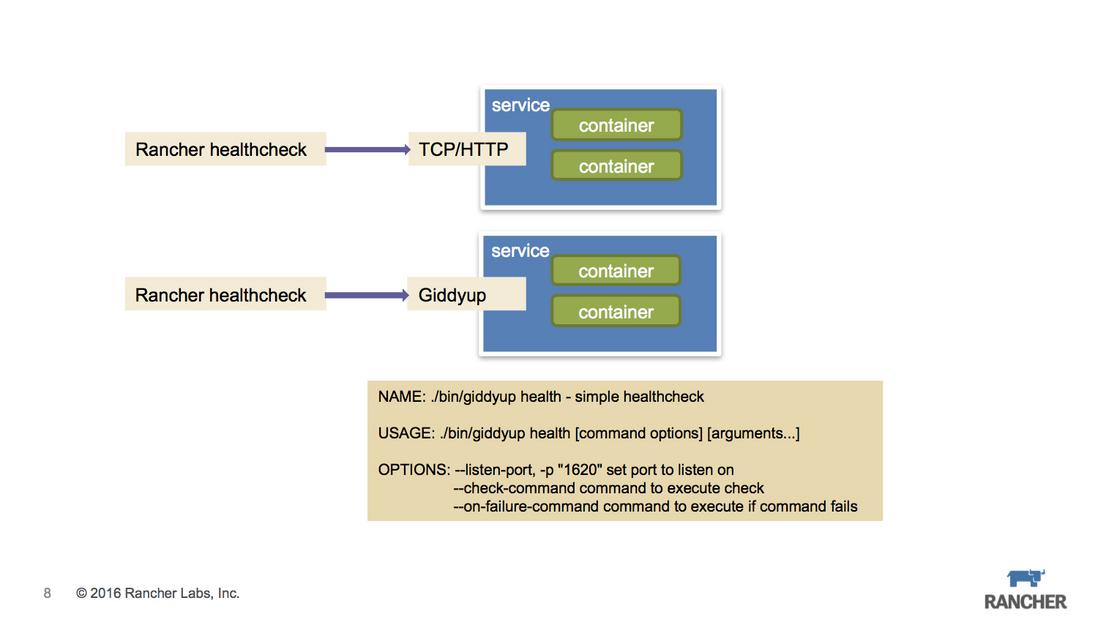

如果微服務本身是自帶服務埠(TCP/HTTP),那麼healthcheck規則很好設定,只要正常填寫表單項就可以。但實際應用中有些微服務並不會有埠暴露,它可能只是一個與DB互動的程式,這時我們會考慮讓服務本身不要有大的程式碼改造,所以就需要用一些小工具來輔助一下。

微服務的訪問入口,除了我們熟知的LB方式,還可以透過繫結DNS來實現,尤其是在私有云場景下,內部DNS的使用其實比單純使用LB暴露IP+Port方式更加簡潔,因為這樣無需考慮微服務的容器漂移導致的服務IP出現變化。

Rancher提供了一個external-dns框架 https://github.com/rancher/ex...,它可以實現service的服務地址轉換成DNS的記錄。

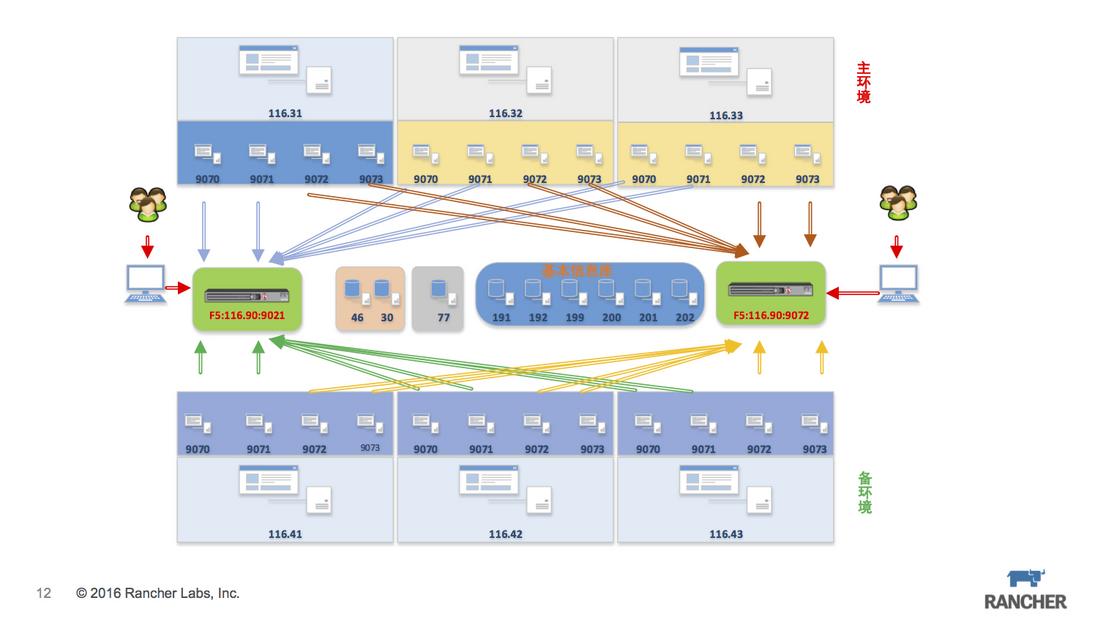

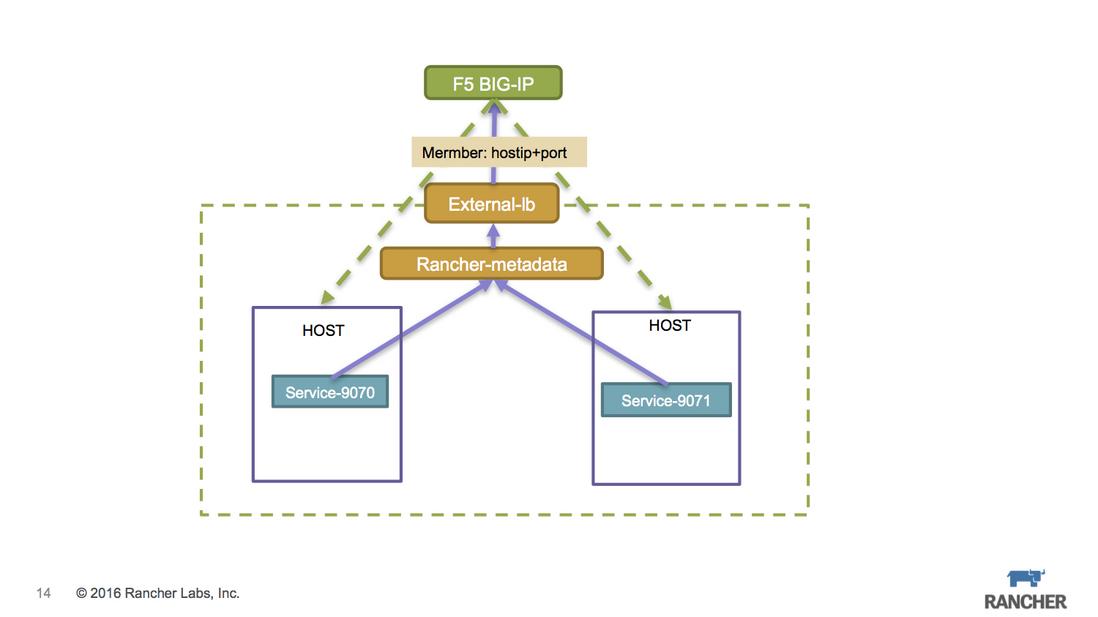

私有云場景中,很多行業使用者在內部都使用F5硬體負載均衡來暴露服務訪問地址。微服務的改造我們儘量控制在程式架構層面,而原有的網路結構儘量不要改變,那麼就會引來一個微服務場景如何整合F5裝置的問題。

我們以一個應用場景為例,生產環境系統中有4個微服務暴露埠分別是9070、9071、9072、9073,出於容災恢復的考慮需要部署兩套環境主環境和備環境,每個環境三臺主機,所有的資料庫層均放在非容器環境中,所有服務最終透過F5來暴露訪問。

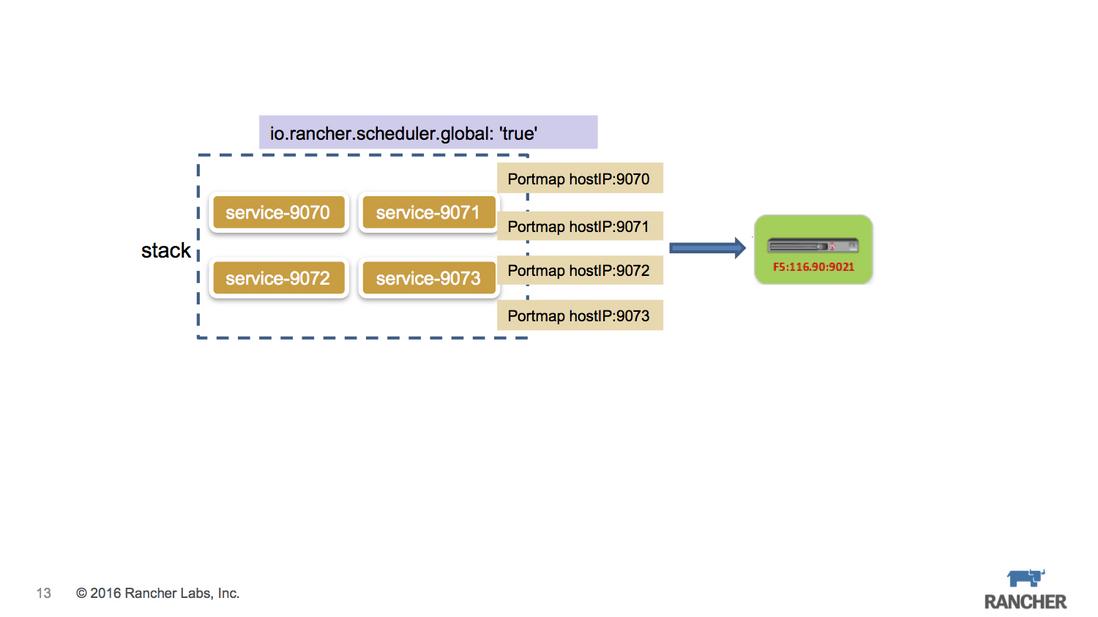

基於Rancher來實現這種應用場景:建立兩個environment分屬主環境和備環境,由於是不同的ENV,所以這兩個環境是從計算儲存網路層面都是隔離的。每個環境中建立一個stack,stack下建立4個service,service加上global=true的label,保證每臺host上都執行該service,同時透過portmap把service的服務埠直接暴露在host上,外部的F5裝置則將VIP配置到這些HostIP+Port上。

關鍵的F5設定,我們要考慮最好能夠動態設定。Rancher提供了一個external-lb框架 https://github.com/rancher/ex...來解決此問題,F5的驅動亦位列其中,同樣也是透過rancher-metadata元件來獲取微服務的IP+Port資訊。

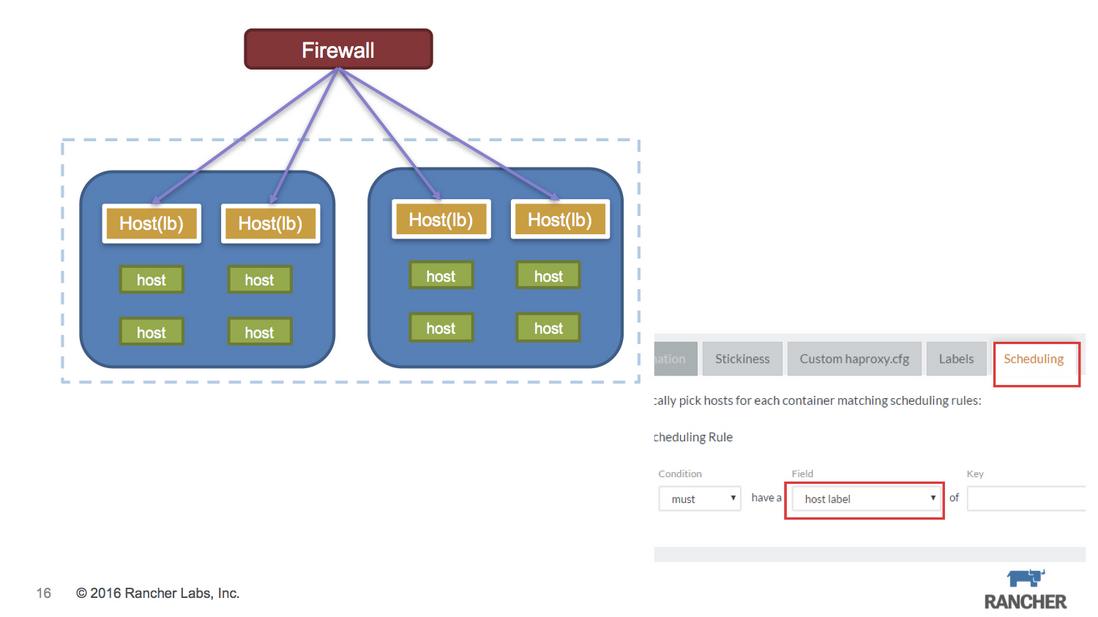

浮動IP本是Iaas的產物,而Caas仍處在不斷演變的過程中,企業內部的網路結構仍然需要浮動IP的機制。最主要的場景就是防火牆的規則設定,通常其規則都是針對某個IP,而這個IP就意味著無論後端的服務怎麼變換,它要求IP是不能變化的,否則就要不停的修改防火牆規則,這是企業運維人員最無法接受的。

本質上我們需要解決微服務相關的容器發生漂移之後,其對外暴露的IP仍然保持不變。

Rancher的合作伙伴睿雲智合提出過一個浮動IP的解決方案,是一個很不錯的思路。

當然我們也可以利用Cattle自有機制來變通地搞定這個問題。

微服務的訪問入口使用內建的rancher-lb方式,可以透過label scheduling方式,讓rancher-lb的容器只落在固定主機上,相關的防火牆只要配置固定的主機IP即可。

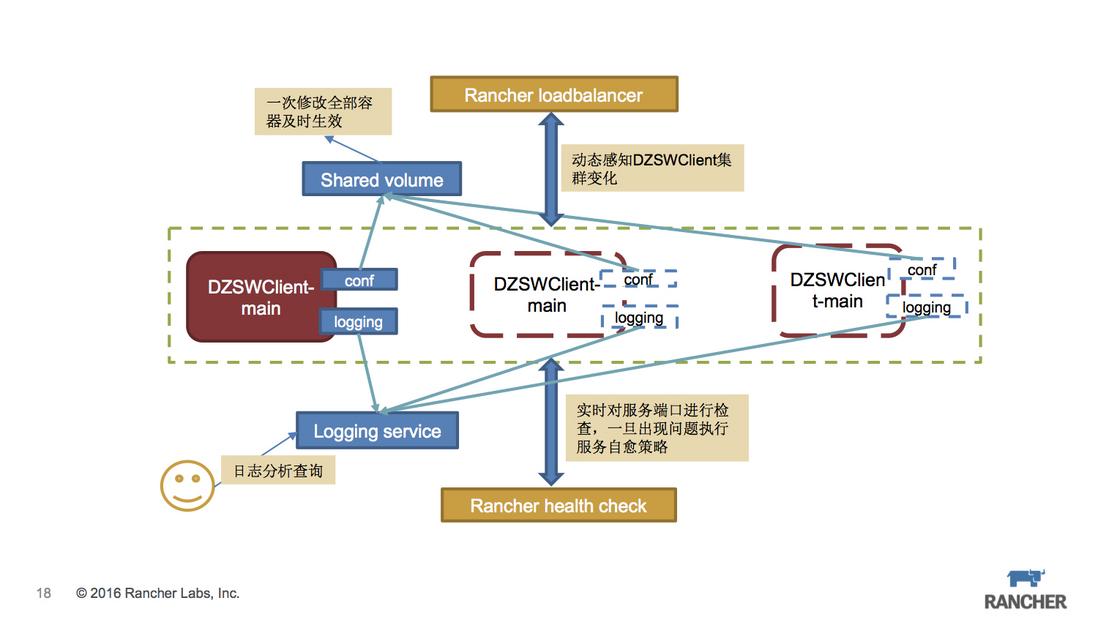

最後,我們來一起看一下,比較合適的通用的微服務部署結構。

這裡面使用sidekick容器來分離主服務的功能,配置檔案和日誌分別由不同的容器來處理,同時保證整體性,可以完整擴容和克隆。配置檔案統一放在 convoy連線的NFS儲存中,保證配置檔案的一致性。logging容器會把日誌統一傳送到ELK日誌系統中,便於集中查詢和管理。保證服務的可用性,healthcheck必不可少。外部則使用內建的Rancher LB來暴露訪問。

Q & A

Q:convoy外掛的現在有支援ceph或者gluster的catalog麼?

A:gluster的catalog 之前有,但是一直有些問題,現在已經被移除了。convoy目前還不支援ceph。

Q:最後一個架構裡面,是把日誌存到一個volume,然後應用和日誌服務,同時掛載的意思麼?

A:日誌就是透過logging容器傳送到ELK中收集起來。

Q:直接用log外掛發的麼?

A:log driver只能把標準輸入輸出傳送出去,而圖中的架構更適合傳統的寫日誌檔案形式,把日誌檔案的內容傳送到elk中。

Q:具體的操作是不是日誌存在一個sidekick 容易中,讓後讓logging容器來解析和傳送?

A:是這樣的。

Q:這樣這個volume 需要mount 本地目錄上去麼?還是就已一個container的形式存在?

A:一個container足矣。

Q:現在convoy是不是暫時沒有其他方案把一個叢集的本地host的磁碟利用起來?

A:Rancher有一個longhorn是你說的場景,還在迭代中。