使用PyTorch從零開始構建Elman迴圈神經網路

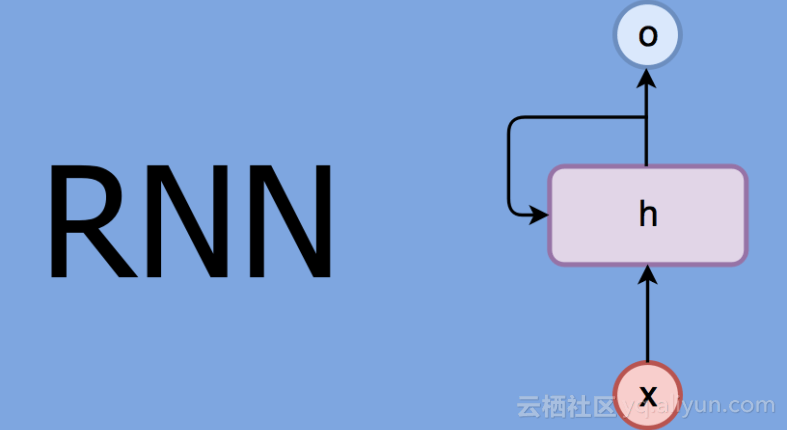

本文以最簡單的RNNs模型為例:Elman迴圈神經網路,講述迴圈神經網路的工作原理,即便是你沒有太多迴圈神經網路(RNNs)的基礎知識,也可以很容易的理解。為了讓你更好的理解RNNs,我們使用Pytorch張量包和autograd庫從頭開始構建Elman迴圈神經網路。該文中完整程式碼在Github上是可實現的。

在這裡,假設你對前饋神經網路略有了解。Pytorch和autograd庫更為詳細的內容請檢視我的其他教程。

Elman迴圈神經網路

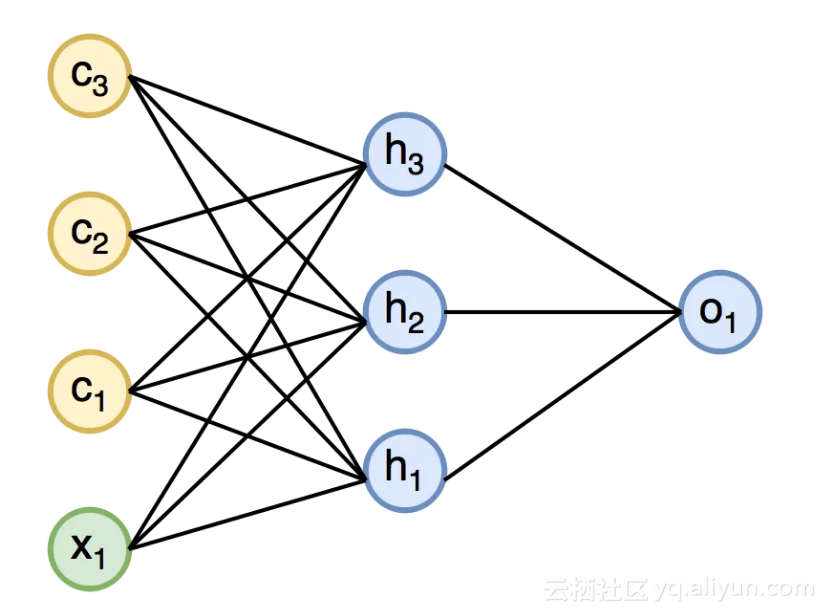

Jeff Elman首次提出了Elman迴圈神經網路,並發表在論文《Finding structure in time》中:它只是一個三層前饋神經網路,輸入層由一個輸入神經元x1和一組上下文神經元單元{c1 … cn}組成。隱藏層前一時間步的神經元作為上下文神經元的輸入,在隱藏層中每個神經元都有一個上下文神經元。由於前一時間步的狀態作為輸入的一部分,因此我們可以說,Elman迴圈神經網路擁有一定的記憶體——上下文神經元代表一個記憶體。

預測正弦波

現在,我們來訓練RNNs學習正弦函式。在訓練過程中,一次只為模型提供一個資料,這就是為什麼我們只需要一個輸入神經元x1,並且我們希望在下一時間步預測該值。輸入序列x由20個資料組成,並且目標序列與輸入序列相同。

模型實現

首先匯入包。

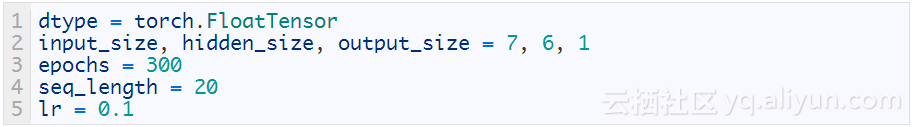

接下來,設定模型的超引數。設定輸入層的大小為7(6個上下文神經元和1個輸入神經元),seq_length用來定義輸入和目標序列的長度。

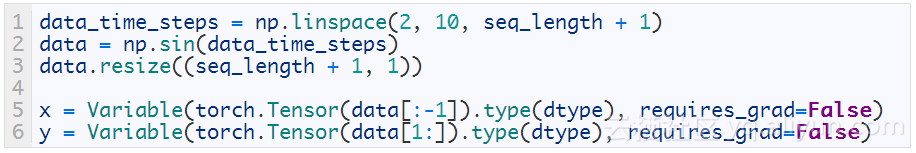

生成訓練資料:x是輸入序列,y是目標序列。

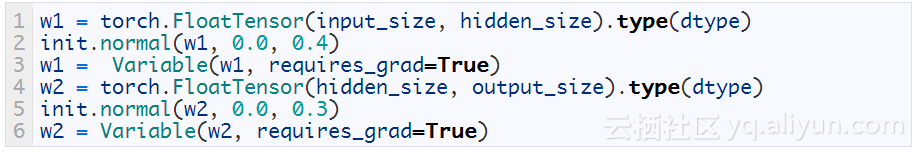

建立兩個權重矩陣。大小為(input_size,hidden_size)的矩陣w1用於隱藏連線的輸入,大小為(hidden_size,output_size)的矩陣w2用於隱藏連線的輸出。 用零均值的正態分佈對權重矩陣進行初始化。

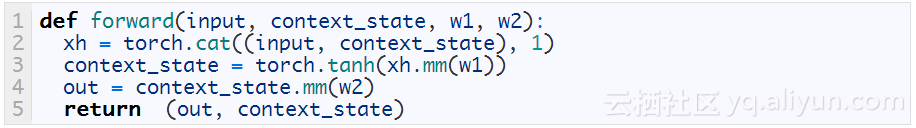

定義forward方法,其引數為input向量、context_state向量和兩個權重矩陣,連線input和context_state建立xh向量。對xh向量和權重矩陣w1執行點積運算,然後用tanh函式作為非線性函式,在RNNs中tanh比sigmoid效果要好。 然後對新的context_state和權重矩陣w2再次執行點積運算。 我們想要預測連續值,因此這個階段不使用任何非線性。

請注意,context_state向量將在下一時間步填充上下文神經元。 這就是為什麼我們要返回context_state向量和out。

訓練

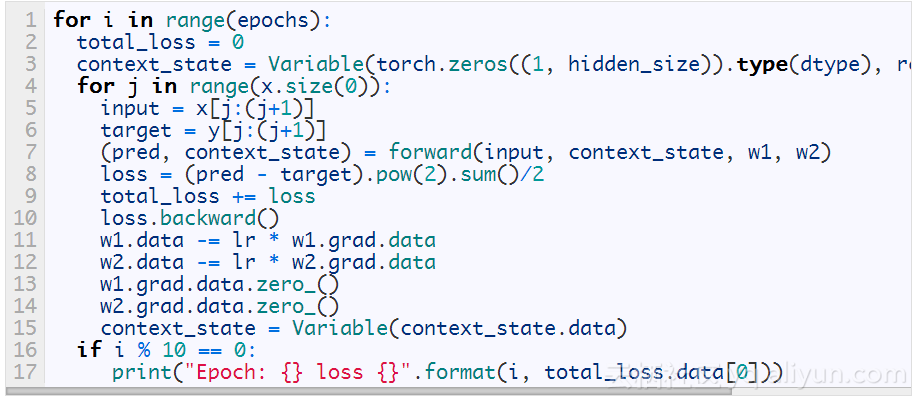

訓練迴圈的結構如下:

1.外迴圈遍歷每個epoch。epoch被定義為所有的訓練資料全部通過訓練網路一次。在每個epoch開始時,將context_state向量初始化為0。

2.內部迴圈遍歷序列中的每個元素。執行forward方法進行正向傳遞,該方法返回pred和context_state,將用於下一個時間步。然後計算均方誤差(MSE)用於預測連續值。執行backward()方法計算梯度,然後更新權重w1和w2。每次迭代中呼叫zero_()方法清除梯度,否則梯度將會累計起來。最後將context_state向量包裝放到新變數中,以將其與歷史值分離開來。

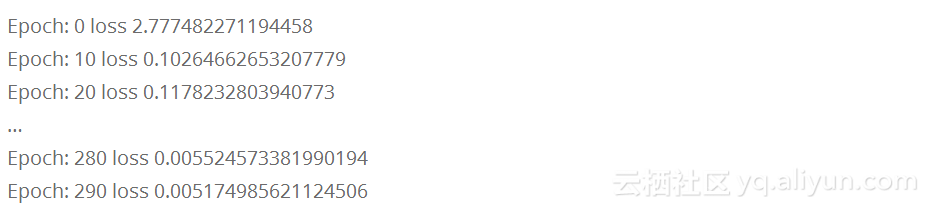

訓練期間產生的輸出顯示了每個epoch的損失是如何減少的,這是一個好的衡量方式。損失的逐漸減少則意味著我們的模型正在學習。

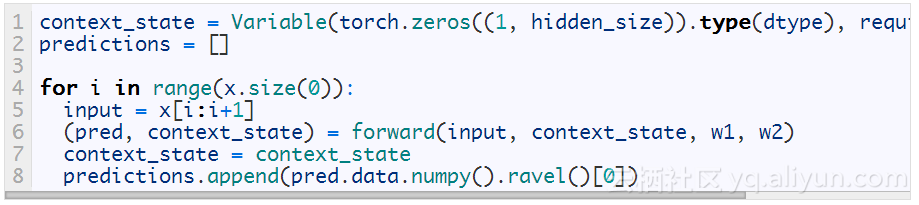

預測

一旦模型訓練完畢,我們就可以進行預測。在序列的每一步我們只為模型提供一個資料,並要求模型在下一個步預測一個值。

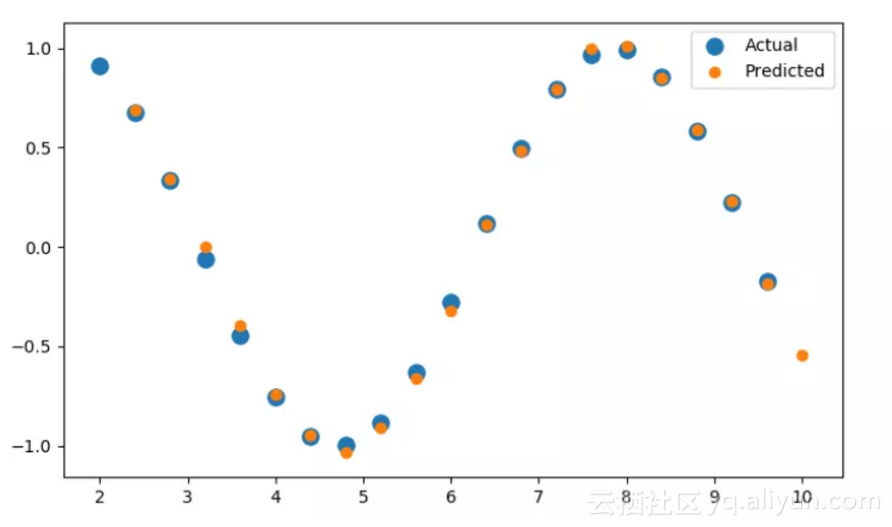

預測結果如下圖所示:黃色圓點表示預測值,藍色圓點表示實際值,二者基本吻合,因此模型的預測效果非常好。

結論

在這裡,我們使用了Pytorch從零開始構建一個基本的RNNs模型,並且學習瞭如何將RNNs應用於簡單的序列預測問題。

以上為譯文。

本文由北郵@愛可可-愛生活 老師推薦,阿里云云棲社群組織翻譯。

文章原標題《Introduction to Recurrent Neural Networks in Pytorch》,譯者:Mags,審校:袁虎。

文章為簡譯,更為詳細的內容,請檢視原文。

相關文章

- 從零開始用 Python 構建迴圈神經網路Python神經網路

- pytorch--迴圈神經網路PyTorch神經網路

- [譯] 如何用 Python 從零開始構建你自己的神經網路Python神經網路

- 資料科學家的必備讀物:從零開始用Python構建迴圈神經網路(附程式碼)資料科學Python神經網路

- 從網路架構方面簡析迴圈神經網路RNN架構神經網路RNN

- 從零開始構建並編寫神經網路【學習筆記】[2/2]神經網路筆記

- 迴圈神經網路神經網路

- 從零開始:教你如何訓練神經網路神經網路

- 從零開始構建並編寫神經網路---Keras【學習筆記】[1/2]神經網路Keras筆記

- 常見迴圈神經網路結構神經網路

- 迴圈神經網路(RNN)神經網路RNN

- 迴圈神經網路 RNN神經網路RNN

- 迴圈神經網路之embedding,padding,模型構建與訓練神經網路padding模型

- Pytorch | Tutorial-04 構建神經網路模型PyTorch神經網路模型

- 迴圈神經網路介紹神經網路

- 從零開始學Python—第六課:迴圈結構Python

- 第五週:迴圈神經網路神經網路

- 迴圈神經網路(Recurrent Neural Network,RNN)神經網路RNN

- 動畫圖解迴圈神經網路動畫圖解神經網路

- (一)線性迴圈神經網路(RNN)神經網路RNN

- keras構建神經網路Keras神經網路

- (二)非線性迴圈神經網路(RNN)神經網路RNN

- YJango的迴圈神經網路——實現LSTMGo神經網路

- 深度學習之RNN(迴圈神經網路)深度學習RNN神經網路

- 深度學習迴圈神經網路詳解深度學習神經網路

- 4.5 RNN迴圈神經網路(recurrent neural network)RNN神經網路

- 純Python和PyTorch對比實現迴圈神經網路RNNCell及反向傳播PythonPyTorch神經網路RNN反向傳播

- 從前饋到反饋:解析迴圈神經網路(RNN)及其tricks神經網路RNN

- YJango的迴圈神經網路——scan實現LSTMGo神經網路

- NLP與深度學習(二)迴圈神經網路深度學習神經網路

- 深度學習四從迴圈神經網路入手學習LSTM及GRU深度學習神經網路

- 使用PyTorch演示實現神經網路過程PyTorch神經網路

- 迴圈神經網路LSTM RNN迴歸:sin曲線預測神經網路RNN

- [譯] 如何在 keras 中使用迴圈神經網路創作音樂Keras神經網路

- 從零開始的 TensorFlow:第 4 章、深刻理解第一個神經網路 (一)神經網路

- [譯] Keras 速查表:使用 Python 構建神經網路KerasPython神經網路

- [譯] RNN 迴圈神經網路系列 2:文字分類RNN神經網路文字分類

- 一文讀懂LSTM和迴圈神經網路神經網路