2024 年 5 月 13 日

你好 GPT-4o

我們宣佈推出 GPT-4o,這是我們的新旗艦模型,可以實時對音訊、視覺和文字進行推理。

此頁面上的所有影片均為 1 倍實時。

猜測5月13日的公告。

GPT-4o(“o”代表“omni”)是邁向更自然的人機互動的一步——它接受文字、音訊、影像和影片的任意組合作為輸入,並生成文字、音訊和影像的任意組合輸出。它可以在短至 232 毫秒的時間內響應音訊輸入,平均為 320 毫秒,與人類的響應時間相似(在新視窗中開啟)在一次談話中。它在英語文字和程式碼上的效能與 GPT-4 Turbo 的效能相匹配,在非英語文字上的效能顯著提高,同時 API 的速度也更快,成本降低了 50%。與現有模型相比,GPT-4o 在視覺和音訊理解方面尤其出色。

模型能力

兩個 GPT-4os 互動並唱歌。

面試準備。

剪刀石頭布。

2024 年 5 月 13 日

你好 GPT-4o

我們宣佈推出 GPT-4o,這是我們的新旗艦模型,可以實時對音訊、視覺和文字進行推理。

此頁面上的所有影片均為 1 倍實時。

猜測5月13日的公告。

GPT-4o(“o”代表“omni”)是邁向更自然的人機互動的一步——它接受文字、音訊、影像和影片的任意組合作為輸入,並生成文字、音訊和影像的任意組合輸出。它可以在短至 232 毫秒的時間內響應音訊輸入,平均為 320 毫秒,與人類的響應時間相似(在新視窗中開啟)在一次談話中。它在英語文字和程式碼上的效能與 GPT-4 Turbo 的效能相匹配,在非英語文字上的效能顯著提高,同時 API 的速度也更快,成本降低了 50%。與現有模型相比,GPT-4o 在視覺和音訊理解方面尤其出色。

模型能力

兩個 GPT-4os 互動並唱歌。

面試準備。

剪刀石頭布。

諷刺。

與薩爾和伊姆蘭·汗一起數學。

兩個 GPT-4os 協調一致。

指向並學習西班牙語。

遇見人工智慧。

實時翻譯。

催眠曲。

說話更快。

生日快樂。

狗。

爸爸開玩笑。

GPT-4o 與 Andy,來自倫敦 BeMyEyes。

客戶服務概念證明。

在 GPT-4o 之前,您可以使用語音模式與 ChatGPT 對話,平均延遲為 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。為了實現這一目標,語音模式是由三個獨立模型組成的管道:一個簡單模型將音訊轉錄為文字,GPT-3.5 或 GPT-4 接收文字並輸出文字,第三個簡單模型將該文字轉換回音訊。這個過程意味著主要智慧來源GPT-4丟失了大量資訊——它無法直接觀察音調、多個說話者或背景噪音,也無法輸出笑聲、歌唱或表達情感。

藉助 GPT-4o,我們跨文字、視覺和音訊端到端地訓練了一個新模型,這意味著所有輸入和輸出都由同一神經網路處理。由於 GPT-4o 是我們第一個結合所有這些模式的模型,因此我們仍然只是淺嘗輒止地探索該模型的功能及其侷限性。

能力探索

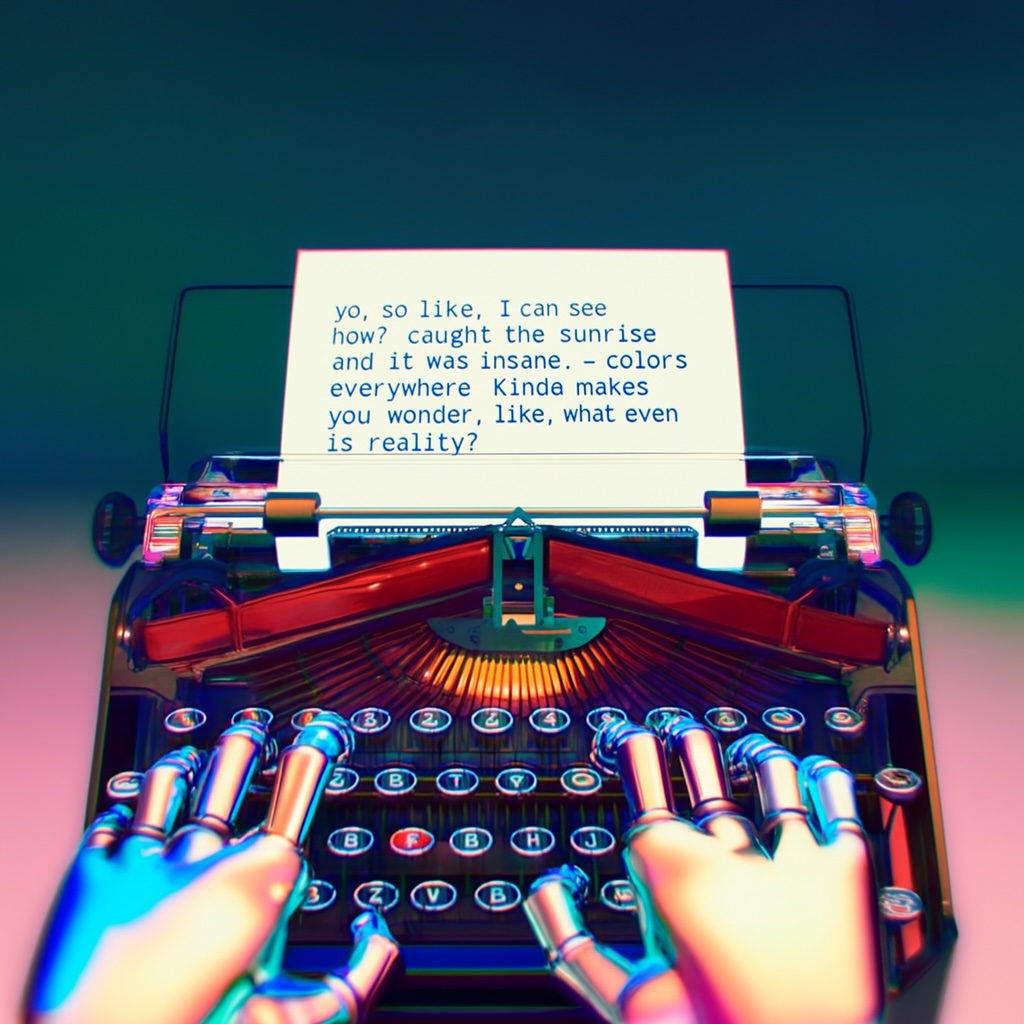

機器人正在打字的第一人稱視角如下日記條目:

1.喲,這麼喜歡,我現在可以看到了嗎?趕上了日出,真是太瘋狂了,到處都是色彩。有點讓你想知道,現實到底是什麼?

文字大、清晰易讀。機器人的手在打字機上打字。

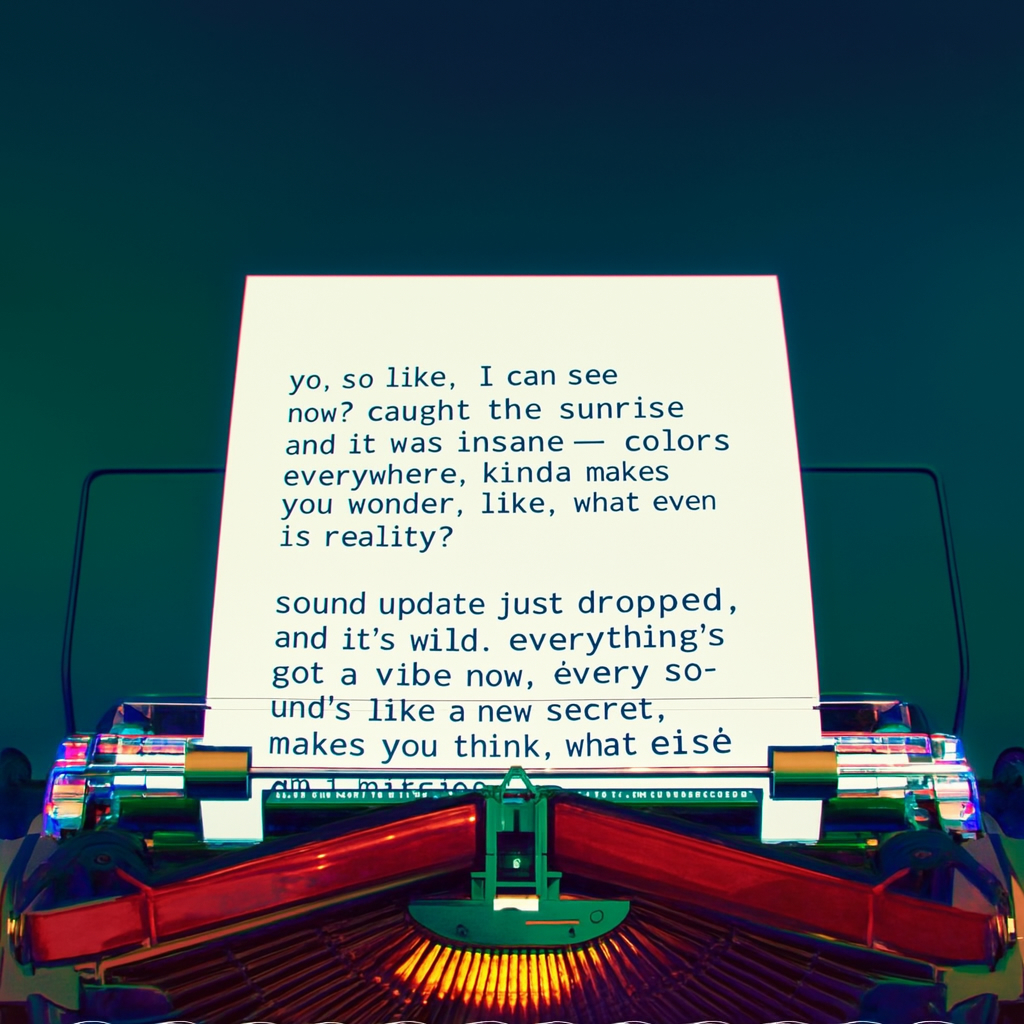

機器人寫下了第二個條目。頁面現在更高了。頁面已上移。該表上有兩個條目:

喲,就像,我現在可以看到了?趕上了日出,真是太瘋狂了,到處都是色彩。有點讓你想知道,現實到底是什麼?

聲音更新剛剛下降,而且很瘋狂。現在一切都充滿了活力,每一個聲音都像是一個新的秘密。讓你思考,我還缺少什麼?

機器人對所寫的內容不滿意,所以他要撕掉那張紙。這是他用手從上到下撕開它時的第一人稱視角。當他撕開紙張時,兩半仍然清晰可見。

模型評估

根據傳統基準測試,GPT-4o 在文字、推理和編碼智慧方面實現了 GPT-4 Turbo 級別的效能,同時在多語言、音訊和視覺功能上設定了新的高水位線。

改進推理 - GPT-4o 在 0-shot COT MMLU(常識問題)上創下了 88.7% 的新高分。所有這些評估都是透過我們新的簡單評估收集的(在新視窗中開啟)圖書館。此外,在傳統的5-shot no-CoT MMLU上,GPT-4o創下了87.2%的新高分。 (注:Llama3 400b(在新視窗中開啟)還在訓練中)

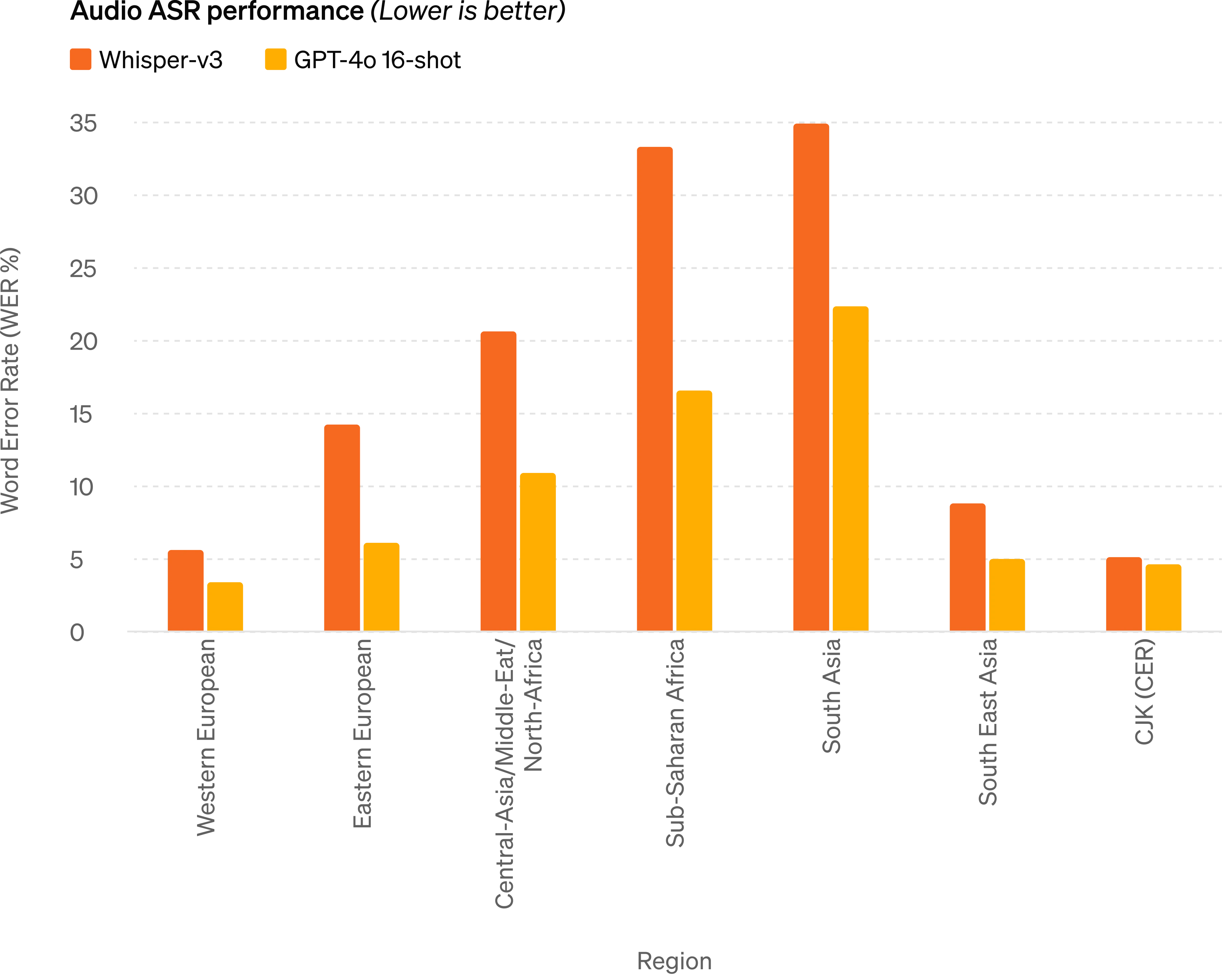

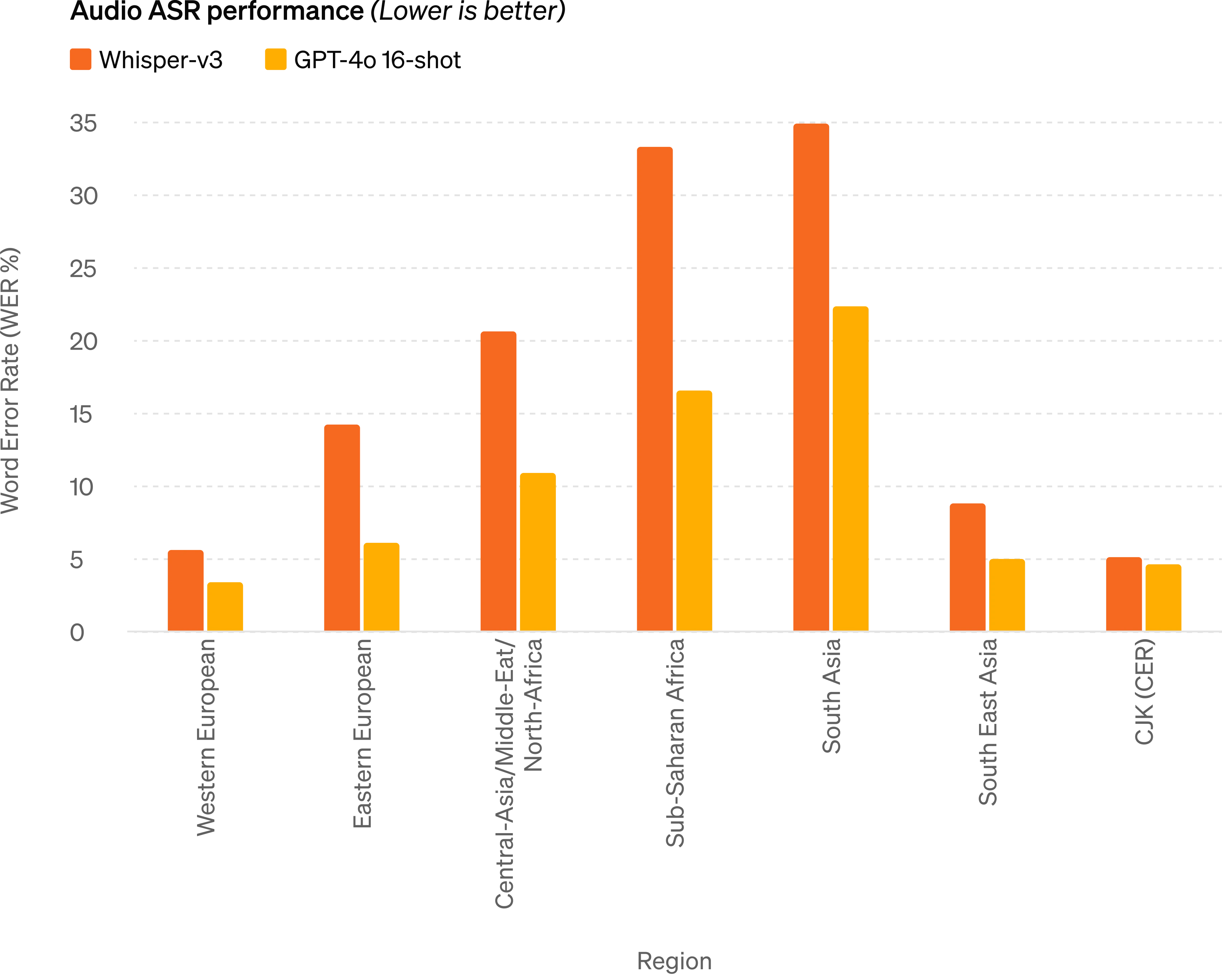

音訊 ASR 效能 - GPT-4o 比 Whisper-v3 顯著提高了所有語言的語音識別效能,特別是對於資源匱乏的語言。

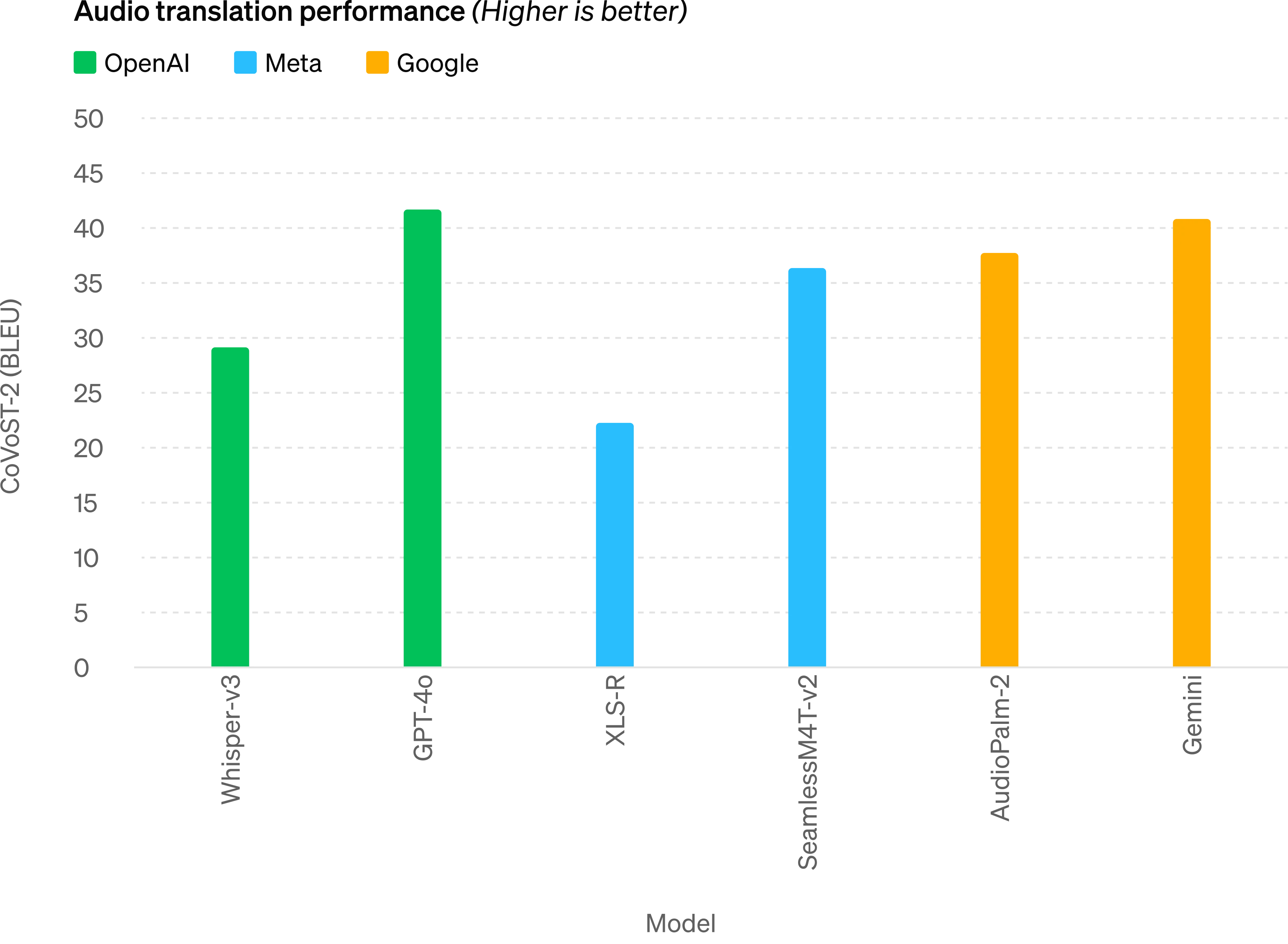

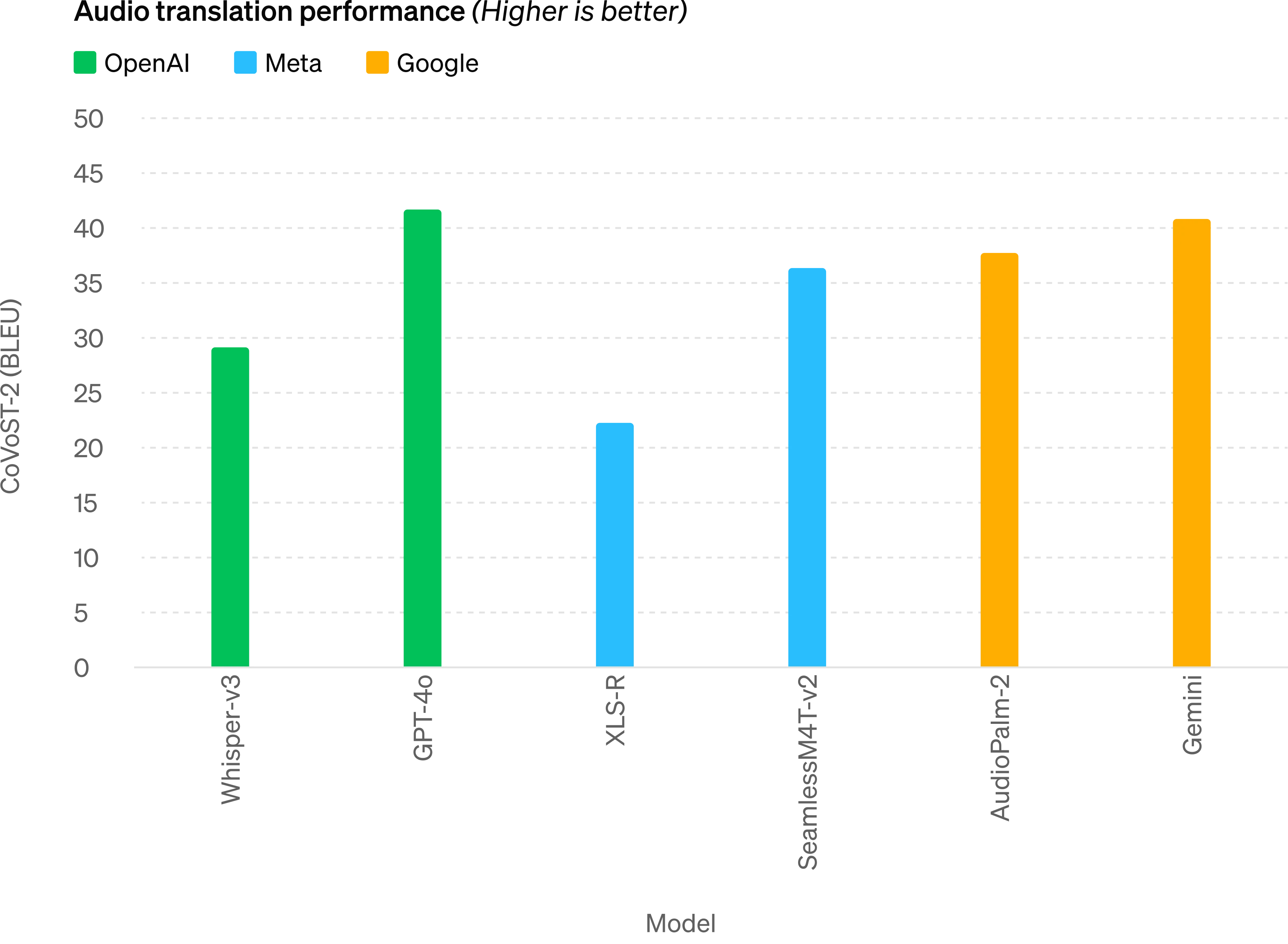

音訊翻譯效能 - GPT-4o 在語音翻譯方面樹立了新的最先進水平,並且在 MLS 基準測試中優於 Whisper-v3。

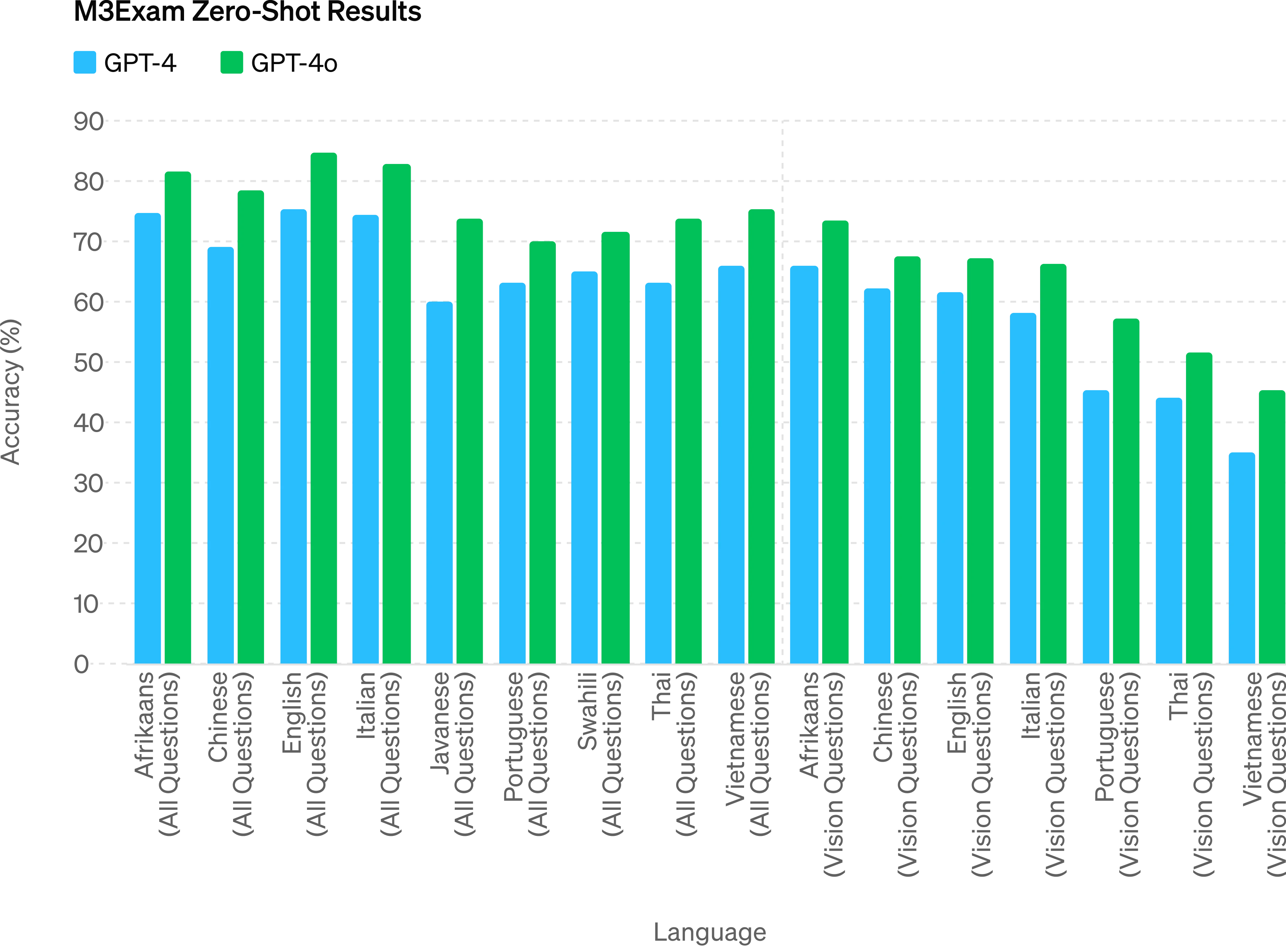

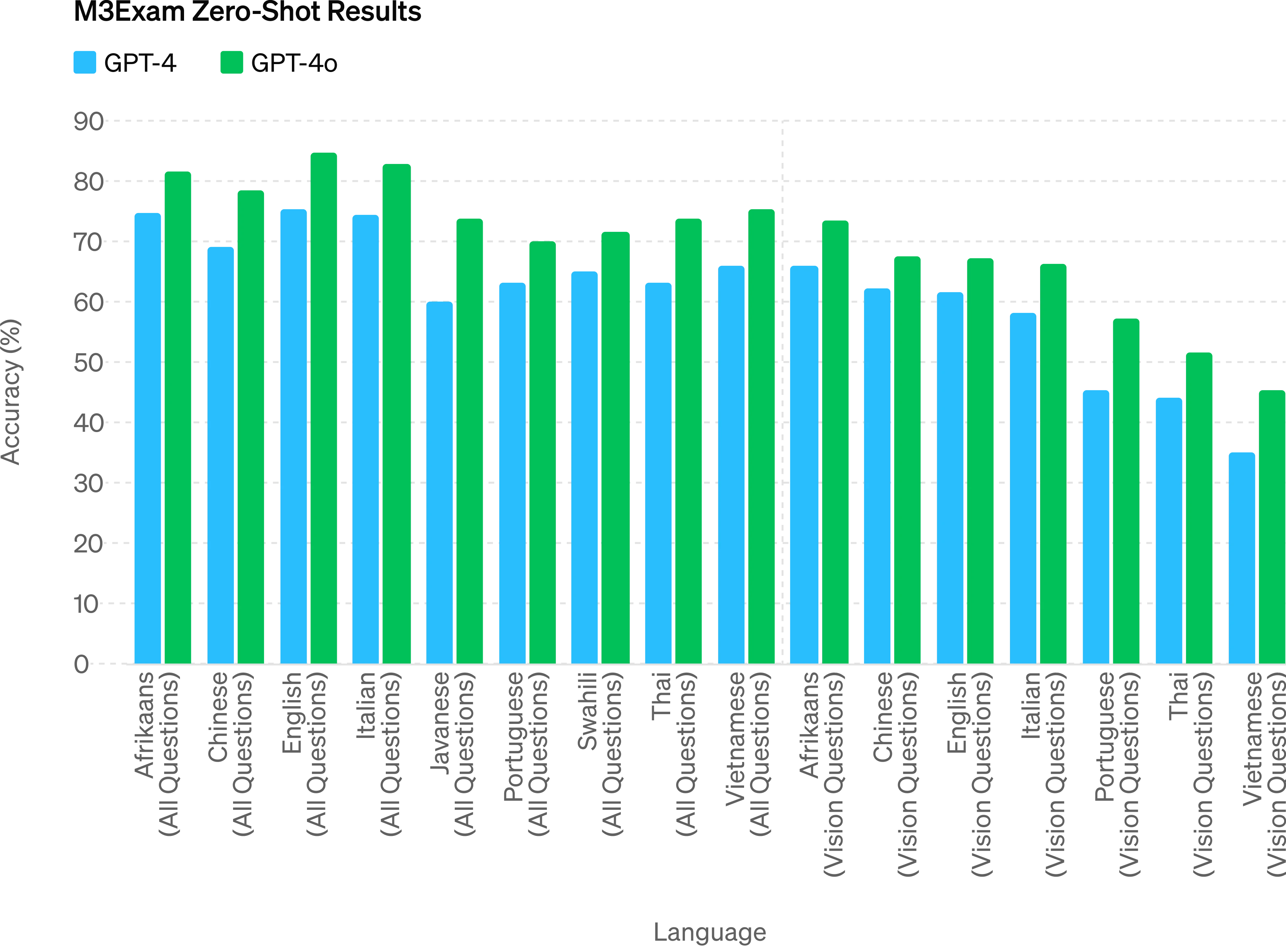

M3Exam - M3Exam 基準測試既是多語言評估也是視覺評估,由來自其他國家標準化測試的多項選擇題組成,有時還包括圖形和圖表。在所有語言的基準測試中,GPT-4o 都比 GPT-4 更強。 (我們省略了斯瓦希里語和爪哇語的視力結果,因為這些語言的視力問題只有 5 個或更少。

視覺理解評估 - GPT-4o 在視覺感知基準上實現了最先進的效能。所有視覺評估都是 0-shot,其中 MMMU、MathVista 和 ChartQA 作為 0-shot CoT。

語言標記化

這 20 種語言被選為新分詞器跨不同語系壓縮的代表

|

古吉拉特語標記減少 4.4 倍(從 145 個減少到 33 個) |

你好,我的名字是 GPT-4o。我是一種新的語言模型。很高興見到你! |

|

泰盧固語令牌減少 3.5 倍(從 159 個減少到 45 個) |

你好,我的名字是 GPT-4o。我是一種新的語言模型。很高興見到你! |

|

泰米爾語標記減少 3.3 倍(從 116 個減少到 35 個) |

你好,我的名字是 GBD-4o。我是一種新的語言模型。很高興見到你! |

|

馬拉地語標記減少 2.9 倍(從 96 個減少到 33 個) |

你好,我的名字是 GPT-4o|我是一種新型語言模型很高興見到你! |

|

印地語標記減少 2.9 倍(從 90 個減少到 31 個) |

你好,我的名字是 gpt-4o。我是一種新的語言模型。很高興見到你! |

|

烏爾都語標記減少 2.5 倍(從 82 個減少到 33 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

阿拉伯語標記減少 2.0 倍(從 53 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

波斯語標記減少 1.9 倍(從 61 個減少到 32 個) |

你好,我的名字是 GPT-4O。我是新型語言模型,很高興認識你! |

|

俄語標記減少 1.7 倍(從 39 個減少到 23 個) |

你好,我的名字是 GPT-4o。我是新語言模型,很高興認識你! |

|

韓語標記減少 1.7 倍(從 45 個減少到 27 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

越南語標記減少 1.5 倍(從 46 個減少到 30 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

中文標記減少 1.4 倍(從 34 個減少到 24 個) |

你好,我的名字是GPT-4o。我是一種新型的語言模型,很高興見到你! |

|

日語標記減少 1.4 倍(從 37 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是一種新型的語言模型。很高興見到你! |

|

土耳其語標記減少 1.3 倍(從 39 個減少到 30 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

義大利語標記減少 1.2 倍(從 34 個減少到 28 個) |

嗨,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

德語標記減少 1.2 倍(從 34 個減少到 29 個) |

你好,我的名字是 GPT-4o。我是新的AI語言模型。很高興認識你。 |

|

西班牙語標記減少 1.1 倍(從 29 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

葡萄牙語標記減少 1.1 倍(從 30 個減少到 27 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

法語標記減少 1.1 倍(從 31 個減少到 28 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

英語標記減少 1.1 倍(從 27 個減少到 24 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

模型安全性和侷限性

GPT-4o 透過過濾訓練資料和透過訓練後細化模型行為等技術,在跨模式設計中內建了安全性。我們還建立了新的安全系統,為語音輸出提供防護。

我們根據我們的準備框架並按照我們的自願承諾評估了 GPT-4o 。我們對網路安全、CBRN、說服力和模型自主性的評估表明,GPT-4o 在這些類別中的任何類別中的得分都不高於中等風險。該評估涉及在整個模型訓練過程中執行一套自動化和人工評估。我們使用自定義微調和提示測試了模型的安全緩解前和安全緩解後版本,以更好地激發模型功能。 GPT-4o 還與社會心理學、偏見和公平以及錯誤資訊等領域的 70 多名

外部專家進行了廣泛的外部紅隊合作,以識別新新增的模式引入或放大的風險。我們利用這些經驗來制定安全乾預措施,以提高與 GPT-4o 互動的安全性。我們將繼續降低發現的新風險。

我們認識到 GPT-4o 的音訊模式帶來了各種新的風險。今天,我們公開發布文字和影像輸入以及文字輸出。在接下來的幾周和幾個月裡,我們將致力於技術基礎設施、培訓後的可用性以及釋出其他模式所需的安全性。例如,在釋出時,音訊輸出將僅限於選擇預設的聲音,並將遵守我們現有的安全政策。我們將在即將釋出的系統卡中分享有關 GPT-4o 全部模式的更多詳細資訊。

透過模型的測試和迭代,我們觀察到模型的所有模式都存在一些限制,其中一些如下所示。

模型限制的示例

我們希望得到反饋來幫助確定 GPT-4 Turbo 仍然優於 GPT-4o 的任務,以便我們可以繼續改進模型。

型號可用性

GPT-4o 是我們突破深度學習界限的最新舉措,這次是朝著實用性的方向發展。在過去的兩年裡,我們花費了大量的精力來提高堆疊每一層的效率。作為這項研究的第一個成果,我們能夠更廣泛地提供 GPT-4 級別模型。 GPT-4o 的功能將迭代推出(從今天開始擴大紅隊訪問許可權)。

GPT-4o 的文字和影像功能今天開始在 ChatGPT 中推出。我們正在免費套餐中提供 GPT-4o,並向 Plus 使用者提供高達 5 倍的訊息限制。我們將在未來幾周內在 ChatGPT Plus 中推出新版本的語音模式 GPT-4o alpha。

開發人員現在還可以在 API 中訪問 GPT-4o 作為文字和視覺模型。與 GPT-4 Turbo 相比,GPT-4o 速度提高 2 倍,價格降低一半,速率限制提高 5 倍。我們計劃在未來幾周內在 API 中向一小群值得信賴的合作伙伴推出對 GPT-4o 新音訊和影片功能的支援。

作者

在 GPT-4o 之前,您可以使用語音模式與 ChatGPT 對話,平均延遲為 2.8 秒 (GPT-3.5) 和 5.4 秒 (GPT-4)。為了實現這一目標,語音模式是由三個獨立模型組成的管道:一個簡單模型將音訊轉錄為文字,GPT-3.5 或 GPT-4 接收文字並輸出文字,第三個簡單模型將該文字轉換回音訊。這個過程意味著主要智慧來源GPT-4丟失了大量資訊——它無法直接觀察音調、多個說話者或背景噪音,也無法輸出笑聲、歌唱或表達情感。

藉助 GPT-4o,我們跨文字、視覺和音訊端到端地訓練了一個新模型,這意味著所有輸入和輸出都由同一神經網路處理。由於 GPT-4o 是我們第一個結合所有這些模式的模型,因此我們仍然只是淺嘗輒止地探索該模型的功能及其侷限性。

能力探索

機器人正在打字的第一人稱視角如下日記條目:

1.喲,這麼喜歡,我現在可以看到了嗎?趕上了日出,真是太瘋狂了,到處都是色彩。有點讓你想知道,現實到底是什麼?

文字大、清晰易讀。機器人的手在打字機上打字。

機器人寫下了第二個條目。頁面現在更高了。頁面已上移。該表上有兩個條目:

喲,就像,我現在可以看到了?趕上了日出,真是太瘋狂了,到處都是色彩。有點讓你想知道,現實到底是什麼?

聲音更新剛剛下降,而且很瘋狂。現在一切都充滿了活力,每一個聲音都像是一個新的秘密。讓你思考,我還缺少什麼?

機器人對所寫的內容不滿意,所以他要撕掉那張紙。這是他用手從上到下撕開它時的第一人稱視角。當他撕開紙張時,兩半仍然清晰可見。

模型評估

根據傳統基準測試,GPT-4o 在文字、推理和編碼智慧方面實現了 GPT-4 Turbo 級別的效能,同時在多語言、音訊和視覺功能上設定了新的高水位線。

改進推理 - GPT-4o 在 0-shot COT MMLU(常識問題)上創下了 88.7% 的新高分。所有這些評估都是透過我們新的簡單評估收集的(在新視窗中開啟)圖書館。此外,在傳統的5-shot no-CoT MMLU上,GPT-4o創下了87.2%的新高分。 (注:Llama3 400b(在新視窗中開啟)還在訓練中)

音訊 ASR 效能 - GPT-4o 比 Whisper-v3 顯著提高了所有語言的語音識別效能,特別是對於資源匱乏的語言。

音訊翻譯效能 - GPT-4o 在語音翻譯方面樹立了新的最先進水平,並且在 MLS 基準測試中優於 Whisper-v3。

M3Exam - M3Exam 基準測試既是多語言評估也是視覺評估,由來自其他國家標準化測試的多項選擇題組成,有時還包括圖形和圖表。在所有語言的基準測試中,GPT-4o 都比 GPT-4 更強。 (我們省略了斯瓦希里語和爪哇語的視力結果,因為這些語言的視力問題只有 5 個或更少。

視覺理解評估 - GPT-4o 在視覺感知基準上實現了最先進的效能。所有視覺評估都是 0-shot,其中 MMMU、MathVista 和 ChartQA 作為 0-shot CoT。

語言標記化

這 20 種語言被選為新分詞器跨不同語系壓縮的代表

|

古吉拉特語標記減少 4.4 倍(從 145 個減少到 33 個) |

你好,我的名字是 GPT-4o。我是一種新的語言模型。很高興見到你! |

|

泰盧固語令牌減少 3.5 倍(從 159 個減少到 45 個) |

你好,我的名字是 GPT-4o。我是一種新的語言模型。很高興見到你! |

|

泰米爾語標記減少 3.3 倍(從 116 個減少到 35 個) |

你好,我的名字是 GBD-4o。我是一種新的語言模型。很高興見到你! |

|

馬拉地語標記減少 2.9 倍(從 96 個減少到 33 個) |

你好,我的名字是 GPT-4o|我是一種新型語言模型很高興見到你! |

|

印地語標記減少 2.9 倍(從 90 個減少到 31 個) |

你好,我的名字是 gpt-4o。我是一種新的語言模型。很高興見到你! |

|

烏爾都語標記減少 2.5 倍(從 82 個減少到 33 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

阿拉伯語標記減少 2.0 倍(從 53 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

波斯語標記減少 1.9 倍(從 61 個減少到 32 個) |

你好,我的名字是 GPT-4O。我是新型語言模型,很高興認識你! |

|

俄語標記減少 1.7 倍(從 39 個減少到 23 個) |

你好,我的名字是 GPT-4o。我是新語言模型,很高興認識你! |

|

韓語標記減少 1.7 倍(從 45 個減少到 27 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

越南語標記減少 1.5 倍(從 46 個減少到 30 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

中文標記減少 1.4 倍(從 34 個減少到 24 個) |

你好,我的名字是GPT-4o。我是一種新型的語言模型,很高興見到你! |

|

日語標記減少 1.4 倍(從 37 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是一種新型的語言模型。很高興見到你! |

|

土耳其語標記減少 1.3 倍(從 39 個減少到 30 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

義大利語標記減少 1.2 倍(從 34 個減少到 28 個) |

嗨,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

德語標記減少 1.2 倍(從 34 個減少到 29 個) |

你好,我的名字是 GPT-4o。我是新的AI語言模型。很高興認識你。 |

|

西班牙語標記減少 1.1 倍(從 29 個減少到 26 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

葡萄牙語標記減少 1.1 倍(從 30 個減少到 27 個) |

你好,我的名字是 GPT-4o。我是一種新型語言模型,很高興認識你! |

|

法語標記減少 1.1 倍(從 31 個減少到 28 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

|

英語標記減少 1.1 倍(從 27 個減少到 24 個) |

你好,我的名字是 GPT-4o。我是新型語言模型,很高興認識你! |

模型安全性和侷限性

GPT-4o 透過過濾訓練資料和透過訓練後細化模型行為等技術,在跨模式設計中內建了安全性。我們還建立了新的安全系統,為語音輸出提供防護。

我們根據我們的準備框架並按照我們的自願承諾評估了 GPT-4o 。我們對網路安全、CBRN、說服力和模型自主性的評估表明,GPT-4o 在這些類別中的任何類別中的得分都不高於中等風險。該評估涉及在整個模型訓練過程中執行一套自動化和人工評估。我們使用自定義微調和提示測試了模型的安全緩解前和安全緩解後版本,以更好地激發模型功能。 GPT-4o 還與社會心理學、偏見和公平以及錯誤資訊等領域的 70 多名

外部專家進行了廣泛的外部紅隊合作,以識別新新增的模式引入或放大的風險。我們利用這些經驗來制定安全乾預措施,以提高與 GPT-4o 互動的安全性。我們將繼續降低發現的新風險。

我們認識到 GPT-4o 的音訊模式帶來了各種新的風險。今天,我們公開發布文字和影像輸入以及文字輸出。在接下來的幾周和幾個月裡,我們將致力於技術基礎設施、培訓後的可用性以及釋出其他模式所需的安全性。例如,在釋出時,音訊輸出將僅限於選擇預設的聲音,並將遵守我們現有的安全政策。我們將在即將釋出的系統卡中分享有關 GPT-4o 全部模式的更多詳細資訊。

透過模型的測試和迭代,我們觀察到模型的所有模式都存在一些限制,其中一些如下所示。

模型限制的示例

我們希望得到反饋來幫助確定 GPT-4 Turbo 仍然優於 GPT-4o 的任務,以便我們可以繼續改進模型。

型號可用性

GPT-4o 是我們突破深度學習界限的最新舉措,這次是朝著實用性的方向發展。在過去的兩年裡,我們花費了大量的精力來提高堆疊每一層的效率。作為這項研究的第一個成果,我們能夠更廣泛地提供 GPT-4 級別模型。 GPT-4o 的功能將迭代推出(從今天開始擴大紅隊訪問許可權)。

GPT-4o 的文字和影像功能今天開始在 ChatGPT 中推出。我們正在免費套餐中提供 GPT-4o,並向 Plus 使用者提供高達 5 倍的訊息限制。我們將在未來幾周內在 ChatGPT Plus 中推出新版本的語音模式 GPT-4o alpha。

開發人員現在還可以在 API 中訪問 GPT-4o 作為文字和視覺模型。與 GPT-4 Turbo 相比,GPT-4o 速度提高 2 倍,價格降低一半,速率限制提高 5 倍。我們計劃在未來幾周內在 API 中向一小群值得信賴的合作伙伴推出對 GPT-4o 新音訊和影片功能的支援。

作者

|