從運維角度淺談MySQL資料庫最佳化

一個成熟的資料庫架構並不是一開始設計就具備高可用、高伸縮等特性的,它是隨著使用者量的增加,基礎架構才逐漸完善。這篇博文主要談MySQL資料庫發展週期中所面臨的問題及最佳化方案,暫且拋開前端應用不說,大致分為以下五個階段:

1、資料庫表設計

專案立項後,開發部根據產品部需求開發專案,開發工程師工作其中一部分就是對錶結構設計。對於資料庫來說,這點很重要,如果設計不當,會直接影響訪問速度和使用者體驗。影響的因素很多,比如慢查詢、低效的查詢語句、沒有適當建立索引、資料庫堵塞(死鎖)等。當然,有測試工程師的團隊,會做壓力測試,找bug。對於沒有測試工程師的團隊來說,大多數開發工程師初期不會太多考慮資料庫設計是否合理,而是儘快完成功能實現和交付,等專案有一定訪問量後,隱藏的問題就會暴露,這時再去修改就不是這麼容易的事了。

2、資料庫部署

該運維工程師出場了,專案初期訪問量不會很大,所以單臺部署足以應對在1500左右的QPS(每秒查詢率)。考慮到高可用性,可採用MySQL主從複製+Keepalived做雙機熱備,常見叢集軟體有Keepalived、Heartbeat。

3、資料庫效能最佳化

如果將MySQL部署到普通的X86伺服器上,在不經過任何最佳化情況下,MySQL理論值正常可以處理2000左右QPS,經過最佳化後,有可能會提升到2500左右QPS,否則,訪問量當達到1500左右併發連線時,資料庫處理效能就會變慢,而且硬體資源還很富裕,這時就該考慮軟體問題了。那麼怎樣讓資料庫最大化發揮效能呢?一方面可以單臺執行多個MySQL例項讓伺服器效能發揮到最大化,另一方面是對資料庫進行最佳化,往往作業系統和資料庫預設配置都比較保守,會對資料庫發揮有一定限制,可對這些配置進行適當的調整,儘可能的處理更多連線數。

具體最佳化有以下三個層面:

3.1 資料庫配置最佳化

MySQL常用有兩種儲存引擎,一個是MyISAM,不支援事務處理,讀效能處理快,表級別鎖。另一個是InnoDB,支援事務處理(ACID),設計目標是為處理大容量資料發揮最大化效能,行級別鎖。

- 表鎖:開銷小,鎖定粒度大,發生死鎖機率高,相對併發也低。

- 行鎖:開銷大,鎖定粒度小,發生死鎖機率低,相對併發也高。

為什麼會出現表鎖和行鎖呢?主要是為了保證資料的完整性,舉個例子,一個使用者在操作一張表,其他使用者也想操作這張表,那麼就要等第一個使用者操作完,其他使用者才能操作,表鎖和行鎖就是這個作用。否則多個使用者同時操作一張表,肯定會資料產生衝突或者異常。

根據以上看來,使用InnoDB儲存引擎是最好的選擇,也是MySQL5.5以後版本中預設儲存引擎。每個儲存引擎相關聯引數比較多,以下列出主要影響資料庫效能的引數。

公共引數預設值:

max_connections = 151

#同時處理最大連線數,推薦設定最大連線數是上限連線數的80%左右

sort_buffer_size = 2M

#查詢排序時緩衝區大小,只對order by和group by起作用,可增大此值為16M

query_cache_limit = 1M

#查詢快取限制,只有1M以下查詢結果才會被快取,以免結果資料較大把快取池覆蓋

query_cache_size = 16M

#檢視緩衝區大小,用於快取SELECT查詢結果,下一次有同樣SELECT查詢將直接從快取池返回結果,可適當成倍增加此值

open_files_limit = 1024

#開啟檔案數限制,如果show global status like 'open_files'檢視的值等於或者大於open_files_limit值時,程式會無法連線資料庫或卡死MyISAM引數預設值:

key_buffer_size = 16M

#索引快取區大小,一般設定實體記憶體的30-40%

read_buffer_size = 128K

#讀操作緩衝區大小,推薦設定16M或32MInnoDB引數預設值:

innodb_buffer_pool_size = 128M

#索引和資料緩衝區大小,一般設定實體記憶體的60%-70%

innodb_buffer_pool_instances = 1

#緩衝池例項個數,推薦設定4個或8個

innodb_flush_log_at_trx_commit = 1

#關鍵引數,0代表大約每秒寫入到日誌並同步到磁碟,資料庫故障會丟失1秒左右事務資料。1為每執行一條SQL後寫入到日誌並同步到磁碟,I/O開銷大,執行完SQL要等待日誌讀寫,效率低。2代表只把日誌寫入到系統快取區,再每秒同步到磁碟,效率很高,如果伺服器故障,才會丟失事務資料。對資料安全性要求不是很高的推薦設定2,效能高,修改後效果明顯。

innodb_file_per_table = OFF

#預設是共享表空間,共享表空間idbdata檔案不斷增大,影響一定的I/O效能。推薦開啟獨立表空間模式,每個表的索引和資料都存在自己獨立的表空間中,可以實現單表在不同資料庫中移動。

innodb_log_buffer_size = 8M

#日誌緩衝區大小,由於日誌最長每秒鐘重新整理一次,所以一般不用超過16M3.2 系統核心最佳化

大多數MySQL都部署在linux系統上,所以作業系統的一些引數也會影響到MySQL效能,以下對linux核心進行適當最佳化。

net.ipv4.tcp_fin_timeout = 30

#TIME_WAIT超時時間,預設是60s

net.ipv4.tcp_tw_reuse = 1

#1表示開啟複用,允許TIME_WAIT socket重新用於新的TCP連線,0表示關閉

net.ipv4.tcp_tw_recycle = 1

#1表示開啟TIME_WAIT socket快速回收,0表示關閉

net.ipv4.tcp_max_tw_buckets = 4096

#系統保持TIME_WAIT socket最大數量,如果超出這個數,系統將隨機清除一些TIME_WAIT並列印警告資訊

net.ipv4.tcp_max_syn_backlog = 4096

#進入SYN佇列最大長度,加大佇列長度可容納更多的等待連線在linux系統中,如果程式開啟的檔案控制程式碼數量超過系統預設值1024,就會提示“too many files open”資訊,所以要調整開啟檔案控制程式碼限制。

# vi /etc/security/limits.conf #加入以下配置,*代表所有使用者,也可以指定使用者,重啟系統生效

* soft nofile 65535

* hard nofile 65535

# ulimit -SHn 65535 #立刻生效3.3 硬體配置

加大實體記憶體,提高檔案系統效能。linux核心會從記憶體中分配出快取區(系統快取和資料快取)來存放熱資料,透過檔案系統延遲寫入機制,等滿足條件時(如快取區大小到達一定百分比或者執行sync命令)才會同步到磁碟。也就是說實體記憶體越大,分配快取區越大,快取資料越多。當然,伺服器故障會丟失一定的快取資料。

SSD硬碟代替SAS硬碟,將RAID級別調整為RAID1+0,相對於RAID1和RAID5有更好的讀寫效能(IOPS),畢竟資料庫的壓力主要來自磁碟I/O方面。

4、資料庫架構擴充套件

隨著業務量越來越大,單臺資料庫伺服器效能已無法滿足業務需求,該考慮加機器了,該做叢集了~~~。主要思想是分解單臺資料庫負載,突破磁碟I/O效能,熱資料存放快取中,降低磁碟I/O訪問頻率。

4.1 主從複製與讀寫分離

因為生產環境中,資料庫大多都是讀操作,所以部署一主多從架構,主資料庫負責寫操作,並做雙擊熱備,多臺從資料庫做負載均衡,負責讀操作,主流的負載均衡器有LVS、HAProxy、Nginx。怎麼來實現讀寫分離呢?大多數企業是在程式碼層面實現讀寫分離,效率比較高。另一個種方式透過代理程式實現讀寫分離,企業中應用較少,常見代理程式有MySQL Proxy、Amoeba。在這樣資料庫叢集架構中,大大增加資料庫高併發能力,解決單臺效能瓶頸問題。如果從資料庫一臺從庫能處理2000 QPS,那麼5臺就能處理1w QPS,資料庫橫向擴充套件性也很容易。

有時,面對大量寫操作的應用時,單臺寫效能達不到業務需求。如果做雙主,就會遇到資料庫資料不一致現象,產生這個原因是在應用程式不同的使用者會有可能操作兩臺資料庫,同時的更新操作造成兩臺資料庫資料庫資料發生衝突或者不一致。在單庫時MySQL利用儲存引擎機制表鎖和行鎖來保證資料完整性,怎樣在多臺主庫時解決這個問題呢?有一套基於perl語言開發的主從複製管理工具,叫MySQL-MMM(Master-Master replication managerfor Mysql,Mysql主主複製管理器),這個工具最大的優點是在同一時間只提供一臺資料庫寫操作,有效保證資料一致性。

- 主從複製博文: http://lizhenliang.blog.51cto.com/7876557/1290431

- 讀寫分離博文: http://lizhenliang.blog.51cto.com/7876557/1305083

- MySQL-MMM博文: http://lizhenliang.blog.51cto.com/7876557/1354576

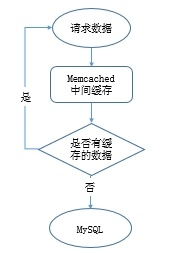

4.2 增加快取

給資料庫增加快取系統,把熱資料快取到記憶體中,如果記憶體快取中有要請求的資料就不再去資料庫中返回結果,提高讀效能。快取實現有本地快取和分散式快取,本地快取是將資料快取到本地伺服器記憶體中或者檔案中,速度快。分散式可以快取海量資料,擴充套件容易,主流的分散式快取系統有memcached、redis,memcached效能穩定,資料快取在記憶體中,速度很快,QPS可達8w左右。如果想資料持久化那就用redis,效能不低於memcached。

工作過程:

4.3 分庫

分庫是根據業務不同把相關的表切分到不同的資料庫中,比如web、bbs、blog等庫。如果業務量很大,還可將切分後的庫做主從架構,進一步避免單個庫壓力過大。

4.4 分表

資料量的日劇增加,資料庫中某個表有幾百萬條資料,導致查詢和插入耗時太長,怎麼能解決單表壓力呢?你就該考慮是否把這個表拆分成多個小表,來減輕單個表的壓力,提高處理效率,此方式稱為分表。

分表技術比較麻煩,要修改程式程式碼裡的SQL語句,還要手動去建立其他表,也可以用merge儲存引擎實現分表,相對簡單許多。分表後,程式是對一個總表進行操作,這個總表不存放資料,只有一些分表的關係,以及更新資料的方式,總表會根據不同的查詢,將壓力分到不同的小表上,因此提高併發能力和磁碟I/O效能。

分表分為垂直拆分和水平拆分:

- 垂直拆分:把原來的一個很多欄位的表拆分多個表,解決表的寬度問題。你可以把不常用的欄位單獨放到一個表中,也可以把大欄位獨立放一個表中,或者把關聯密切的欄位放一個表中。

- 水平拆分:把原來一個表拆分成多個表,每個表的結構都一樣,解決單表資料量大的問題。

4.5 分割槽

分割槽就是把一張表的資料分成多個區塊,這些區塊可以在一個磁碟上,也可以在不同的磁碟上,分割槽後,表面上還是一張表,但資料雜湊在多個位置,這樣一來,多塊硬碟同時處理不同的請求,從而提高磁碟I/O讀寫效能,實現比較簡單。

注:增加快取、分庫、分表和分割槽主要由程式猿來實現。

5、資料庫維護

資料庫維護是運維工程師或者DBA主要工作,包括效能監控、效能分析、效能調優、資料庫備份和恢復等。

5.1 效能狀態關鍵指標

- QPS,Queries Per Second:每秒查詢數,一臺資料庫每秒能夠處理的查詢次數

- TPS,Transactions Per Second:每秒處理事務數

透過show status檢視執行狀態,會有300多條狀態資訊記錄,其中有幾個值幫可以我們計算出QPS和TPS,如下:

- Uptime:伺服器已經執行的實際,單位秒

- Questions:已經傳送給資料庫查詢數

- Com_select:查詢次數,實際運算元據庫的

- Com_insert:插入次數

- Com_delete:刪除次數

- Com_update:更新次數

- Com_commit:事務次數

- Com_rollback:回滾次數

那麼,計算方法來了,基於Questions計算出QPS:

mysql> show global status like 'Questions';

mysql> show global status like 'Uptime';QPS = Questions / Uptime

基於Com_commit和Com_rollback計算出TPS:

mysql> show global status like 'Com_commit';

mysql> show global status like 'Com_rollback';

mysql> show global status like 'Uptime';另一計算方式:基於Com_select、Com_insert、Com_delete、Com_update計算出QPS:

mysql> show global status where Variable_name in('com_select','com_insert','com_delete','com_update');等待1秒再執行,獲取間隔差值,第二次每個變數值減去第一次對應的變數值,就是QPS。

TPS計算方法:

mysql> show global status where Variable_name in('com_select','com_insert','com_delete','com_update');計算TPS,就不算查詢操作了,計算出插入、刪除、更新四個值即可。

經網友對這兩個計算方式的測試得出,當資料庫中myisam表比較多時,使用Questions計算比較準確。當資料庫中innodb表比較多時,則以Com_*計算比較準確。

5.2 開啟慢查詢日誌

MySQL開啟慢查詢日誌,分析出哪條SQL語句比較慢,使用set設定變數,重啟服務失效,可以在my.cnf新增引數永久生效。

mysql> set global slow-query-log=on #開啟慢查詢功能

mysql> set global slow_query_log_file='/var/log/mysql/mysql-slow.log'; #指定慢查詢日誌檔案位置

mysql> set global log_queries_not_using_indexes=on; #記錄沒有使用索引的查詢

mysql> set global long_query_time=1; #只記錄處理時間1s以上的慢查詢分析慢查詢日誌,可以使用MySQL自帶的mysqldumpslow工具,分析的日誌較為簡單。

# mysqldumpslow -t 3 /var/log/mysql/mysql-slow.log #檢視最慢的前三個查詢也可以使用percona公司的pt-query-digest工具,日誌分析功能全面,可分析slow log、binlog、general log。

分析慢查詢日誌:

pt-query-digest /var/log/mysql/mysql-slow.log分析binlog日誌:

mysqlbinlog mysql-bin.000001 >mysql-bin.000001.sql

pt-query-digest –type=binlog mysql-bin.000001.sql分析普通日誌:

pt-query-digest –type=genlog localhost.log5.3 資料庫備份

備份資料庫是最基本的工作,也是最重要的,否則後果很嚴重,你懂得!但由於資料庫比較大,上百G,往往備份都很耗費時間,所以就該選擇一個效率高的備份策略,對於資料量大的資料庫,一般都採用增量備份。常用的備份工具有mysqldump、mysqlhotcopy、xtrabackup等,mysqldump比較適用於小的資料庫,因為是邏輯備份,所以備份和恢復耗時都比較長。mysqlhotcopy和xtrabackup是物理備份,備份和恢復速度快,不影響資料庫服務情況下進行熱複製,建議使用xtrabackup,支援增量備份。

- Xtrabackup備份工具使用博文: http://lizhenliang.blog.51cto.com/7876557/1612800

5.4 資料庫修復

有時候MySQL伺服器突然斷電、異常關閉,會導致表損壞,無法讀取表資料。這時就可以用到MySQL自帶的兩個工具進行修復,myisamchk和mysqlcheck。

myisamchk:只能修復myisam表,需要停止資料庫。

常用引數:

- -f –force 強制修復,覆蓋老的臨時檔案,一般不使用

- -r –recover 恢復模式

- -q –quik 快速恢復

- -a –analyze 分析表

- -o –safe-recover 老的恢復模式,如果-r無法修復,可以使用此引數試試

- -F –fast 只檢查沒有正常關閉的表

快速修復weibo資料庫:

# cd /var/lib/mysql/weibo

# myisamchk -r -q *.MYImysqlcheck:myisam和innodb表都可以用,不需要停止資料庫,如修復單個表,可在資料庫後面新增表名,以空格分割

常用引數:

- -a –all-databases 檢查所有的庫

- -r –repair 修復表

- -c –check 檢查表,預設選項

- -a –analyze 分析表

- -o –optimize 最佳化表

- -q –quik 最快檢查或修復表

- -F –fast 只檢查沒有正常關閉的表

快速修復weibo資料庫:

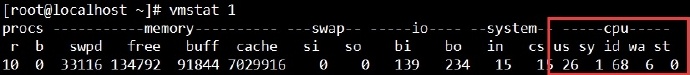

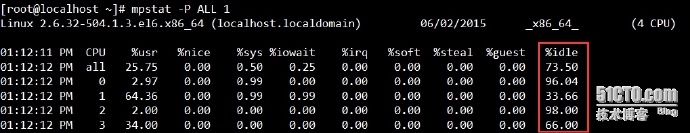

mysqlcheck -r -q -uroot -p123 weibo5.5 另外,檢視CPU和I/O效能方法

檢視CPU效能

引數-P是顯示CPU數,ALL為所有,也可以只顯示第幾顆

檢視I/O效能

引數-m是以M單位顯示,預設K。

- %util:當達到100%時,說明I/O很忙。

- await:請求在佇列中等待時間,直接影響read時間。

- I/O極限:IOPS(r/s+w/s),一般在1200左右。(IOPS,每秒進行讀寫(I/O)操作次數)

- I/O頻寬:在順序讀寫模式下SAS硬碟理論值在300M/s左右,SSD硬碟理論值在600M/s左右。

以上是本人使用MySQL三年來總結的一些主要最佳化方案,能力有限,有些不太全面,但這些基本能夠滿足中小型企業資料庫需求。由於關係型資料庫初衷設計限制,一些BAT公司海量資料放到關係型資料庫中,在海量資料查詢和分析方面已經達不到更好的效能。因此NoSQL火起來了,非關係型資料庫,大資料量,具有高效能,同時也彌補了關係型資料庫某方面不足,漸漸大多數公司已經將部分業務資料庫存放到NoSQL中,如MongoDB、HBase等。資料儲存方面採用分散式檔案系統,如HDFS、GFS等。海量資料計算分析採用Hadoop、Spark、Storm等。這些都是與運維相關的前沿技術,也是在儲存方面主要學習物件,小夥伴們共同加油吧!哪位博友有更好的最佳化方案,歡迎交流哦。

相關文章

- 從運維角度淺談 MySQL 資料庫優化運維MySql資料庫優化

- 運維角度淺談MySQL資料庫優化運維MySql資料庫優化

- 運維角度淺談 MySQL 資料庫優化運維MySql資料庫優化

- 從一個Oracle DBA的角度來談談PG資料庫的最佳化Oracle資料庫

- 從資料庫角度談業務連續性資料庫

- 淺談IT運維運維

- MySQL 資料庫日常運維文件MySql資料庫運維

- 從最佳化的角度淺談醫院his以及社保系統

- 梧桐資料庫淺談查詢最佳化技巧資料庫

- 從科研角度談“如何實現基於機器學習的智慧運維”機器學習運維

- MySQL資料庫是什麼?linux資料庫運維MySql資料庫Linux運維

- 從心理學角度淺談三消遊戲遊戲

- Mysql運維-資料庫及表相關操作MySql運維資料庫

- [資料庫] 淺談mysql的serverId/serverUuid資料庫MySqlServerUI

- 從資料庫的角度談-元組(Tuple)和記錄(record)資料庫

- 淺談圖資料庫資料庫

- 圖資料庫淺談資料庫

- 談談資料從sql server資料庫匯入mysql資料庫的體驗(轉)Server資料庫MySql

- 從玩家角度淺談:Roguelike為何令人著迷

- 淺談資料結構最佳化DP資料結構

- 淺談資料庫事務資料庫

- 淺談資料庫連線資料庫

- 【MySQL】資料庫最佳化MySql資料庫

- mysql資料庫最佳化MySql資料庫

- 淺談前端線上部署與運維前端運維

- 資料庫運維 | 攜程分散式圖資料庫NebulaGraph運維治理實踐資料庫運維分散式

- 從使用者角度淺談玩家的遊戲社交之道遊戲

- 淺談資料庫備份方案資料庫

- 淺談資料庫生命週期資料庫

- 淺談資料庫設計技巧資料庫

- MySQL資料庫效能最佳化MySql資料庫

- mysql資料庫SQL最佳化MySql資料庫

- 重新學習MySQL資料庫6:淺談MySQL的中事務與鎖MySql資料庫

- 資料庫運維管理規範資料庫運維

- 達夢資料庫日常運維資料庫運維

- oracle資料庫運維筆記Oracle資料庫運維筆記

- 資料庫運維工作內容資料庫運維

- 淺談資料庫的攻擊(轉)資料庫