2017北京ArchSummit-參會感想

大會背景

時間:2017.12.8~2017.7.9

地點:北京

會議:ArchSummit -北京 2017架構師峰會

日程:http://bj2017.archsummit.com/schedule

我關注的點

- 架構升級和優化

- 高可用體系的一些專題

架構升級和優化

愛奇藝移動端架構演進

- 分享了愛奇藝從php到java的技術轉型中遇到的問題:技術棧的切換,開發人員的技術轉型,技術組建更替迭代。

- 從三個方面愛奇藝的移動架構優化:快(cache+非同步)、穩(熔斷+限流+災備)、準(系統監控+業務檢測)

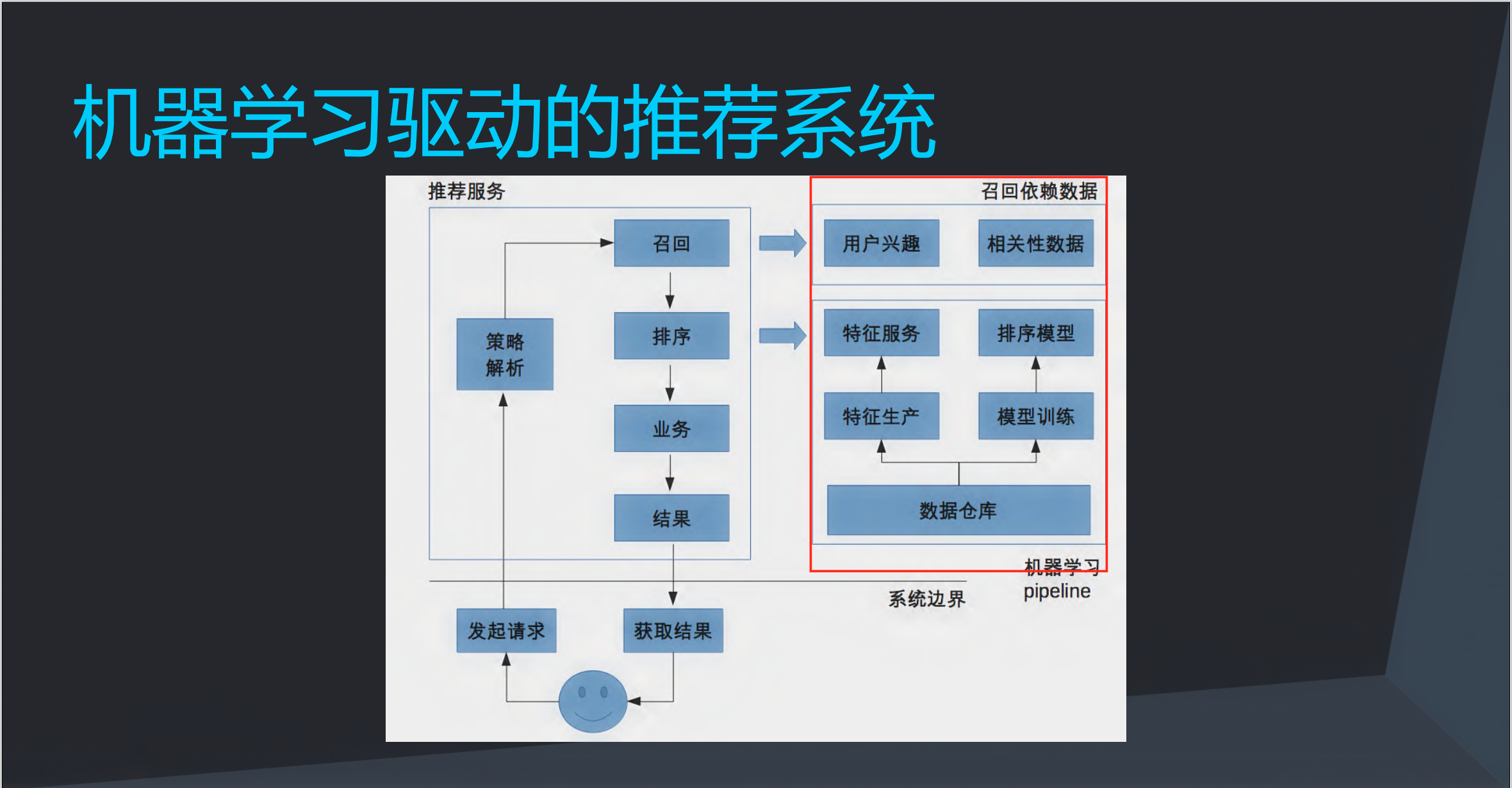

轉轉的推薦系統升級之路

分享了轉轉的推薦系統架構的升級之路:

- 粗力度的個性化推薦

- 細粒度多維度個性化推薦:增加使用者畫像,增強資料複用性,屬性級別細化

- 實時的推薦系統:離線處理使用者畫像,使用者興趣實時化

- 基於ML的排序模型、找回模型、使用者興趣模型

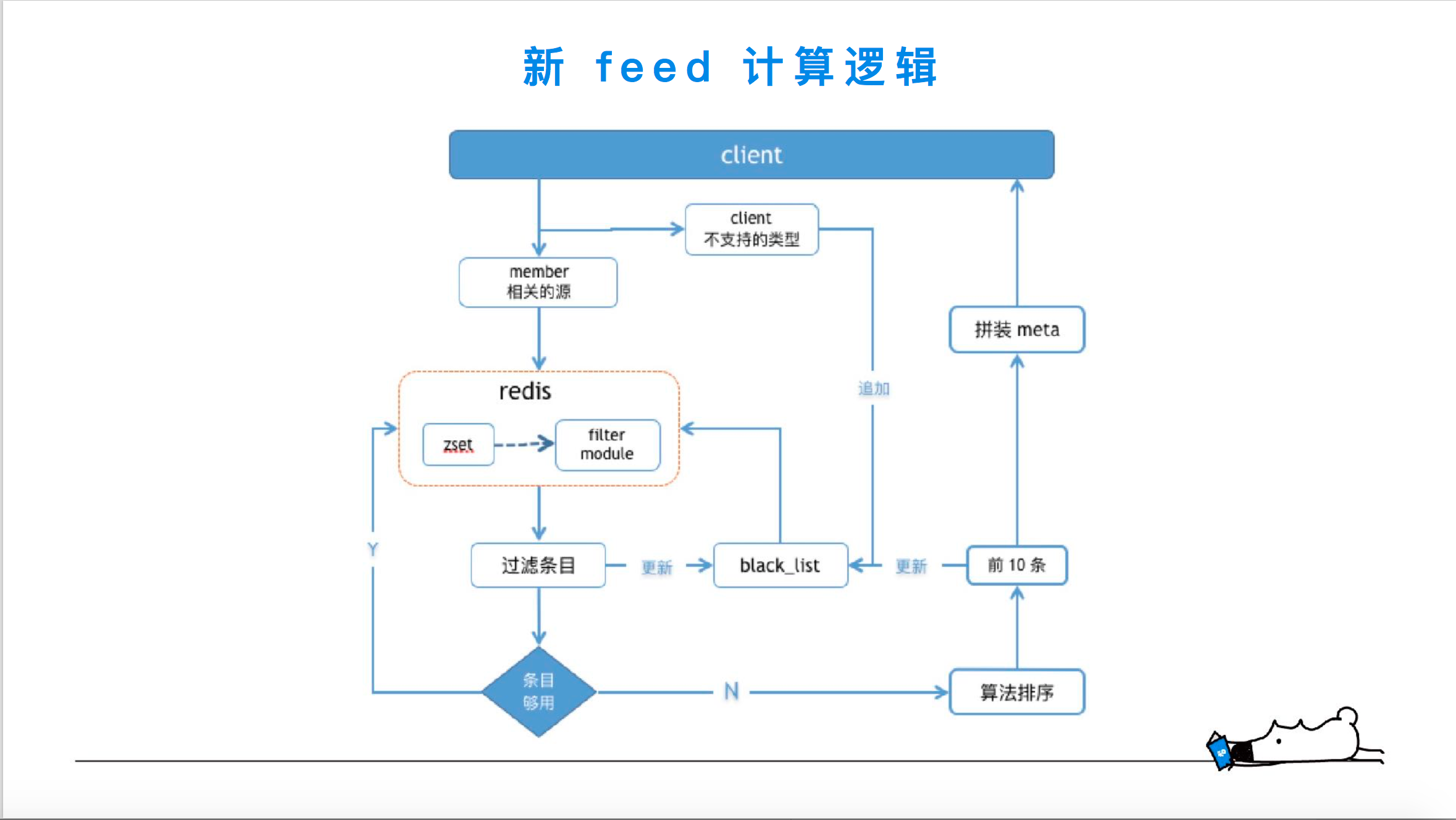

知乎feed流架構演進

- 所有人的Feed 都一樣(熱門榜單)

- Feed 個性化,推模型:大V的粉絲難以實時分發、資源消耗大、排序難以實時調整、基於關係鏈的變更過濾難做

- Feed 個性化,拉模型 + 離線計算(預計算):資源冗餘大、rt長、計算策略複雜、演算法難以實時調整

- Feed 個性化,拉模型,採用 Redis Module,將計算下沉接近儲存:

高可用架構體系

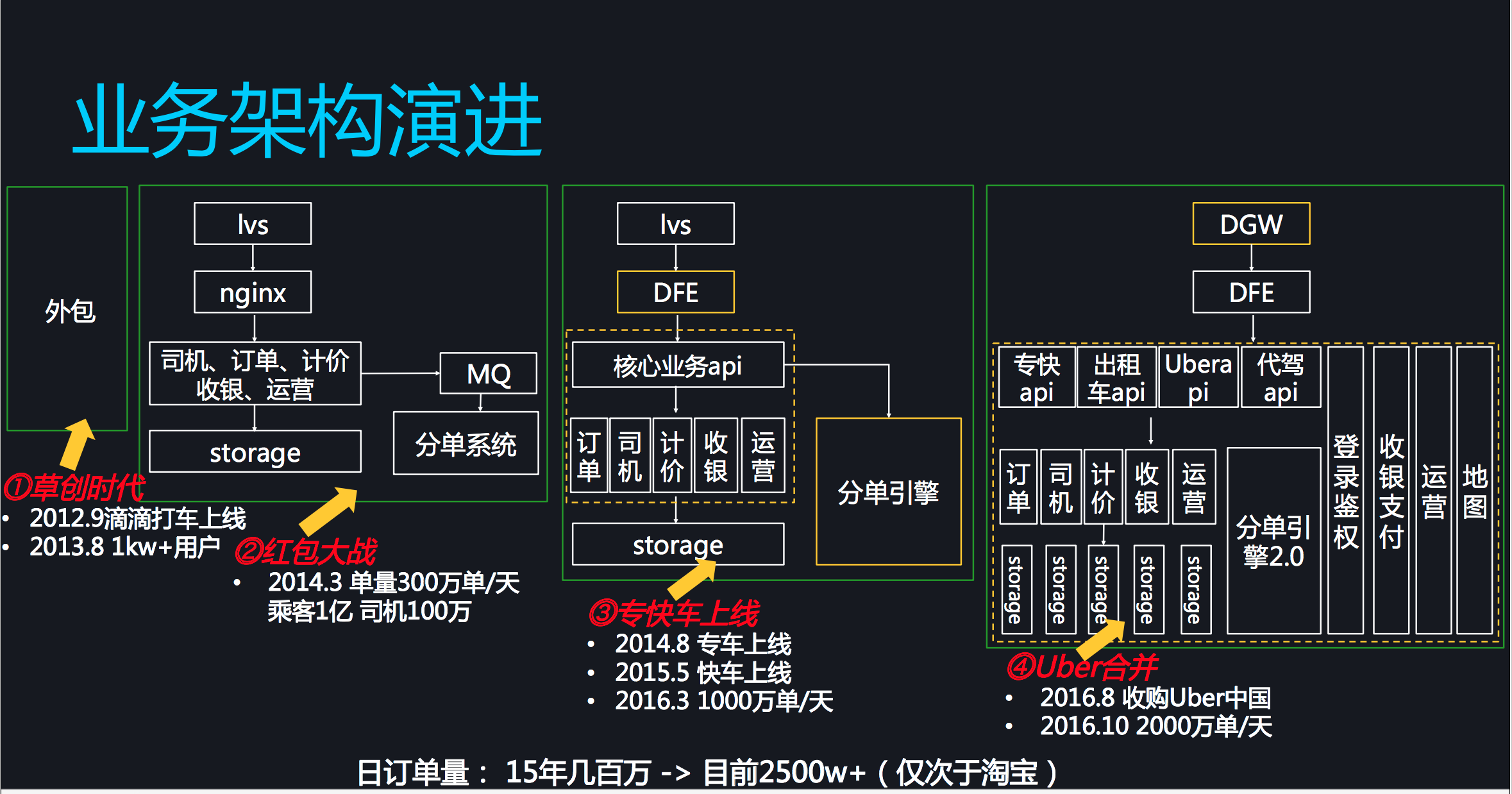

滴滴的高可用架構

1.業務增加的壓力下帶來的架構演進

2.高可用的抓手

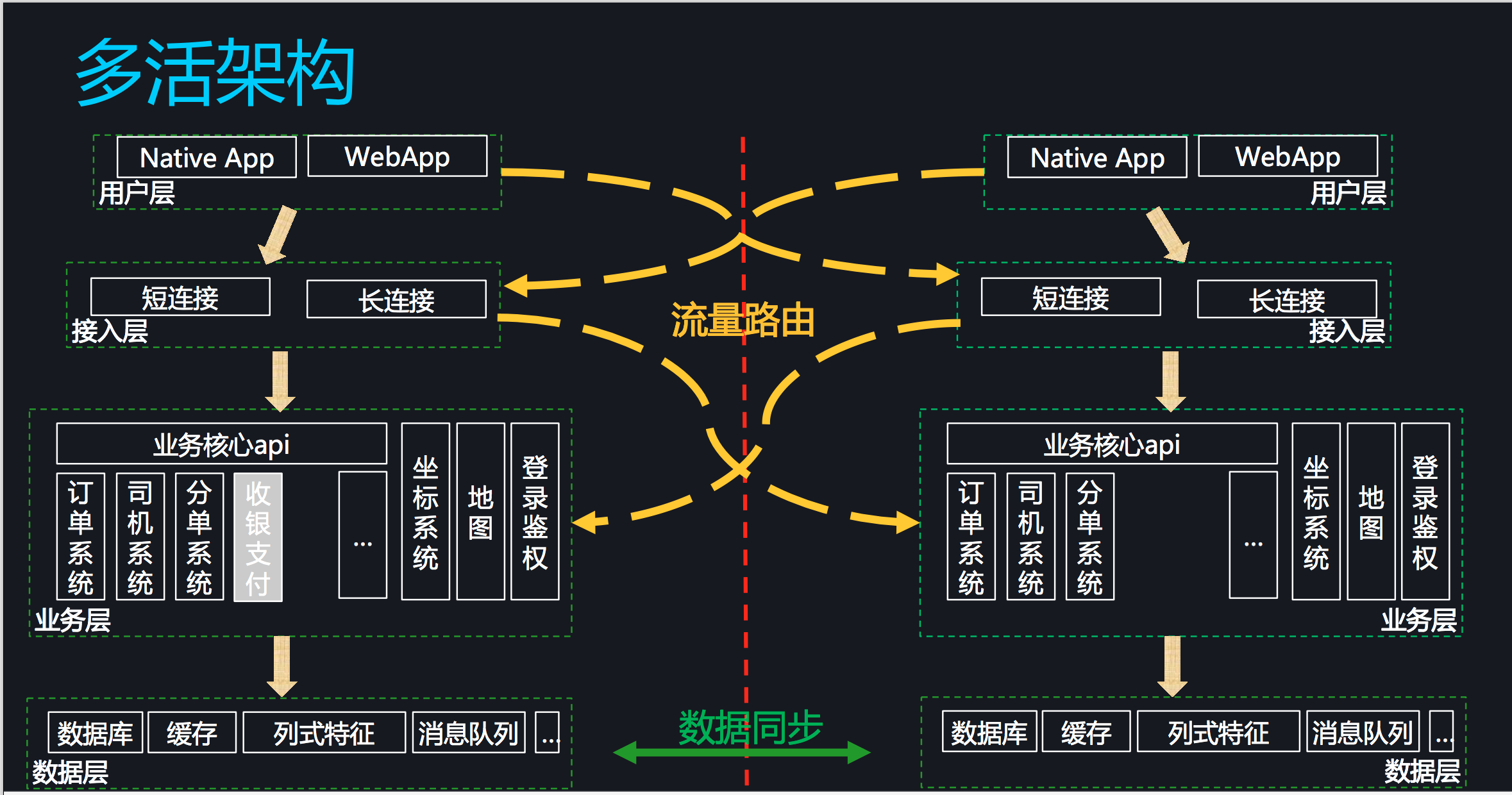

3.滴滴也搞了一套多活的架構,和集團不一樣的地方是滴滴做的是同城多活,可以理解為同城下的單元化架構。

4.滴滴在資料同步方面劃分了不同維度的資料,使用了不同的資料同步方式。

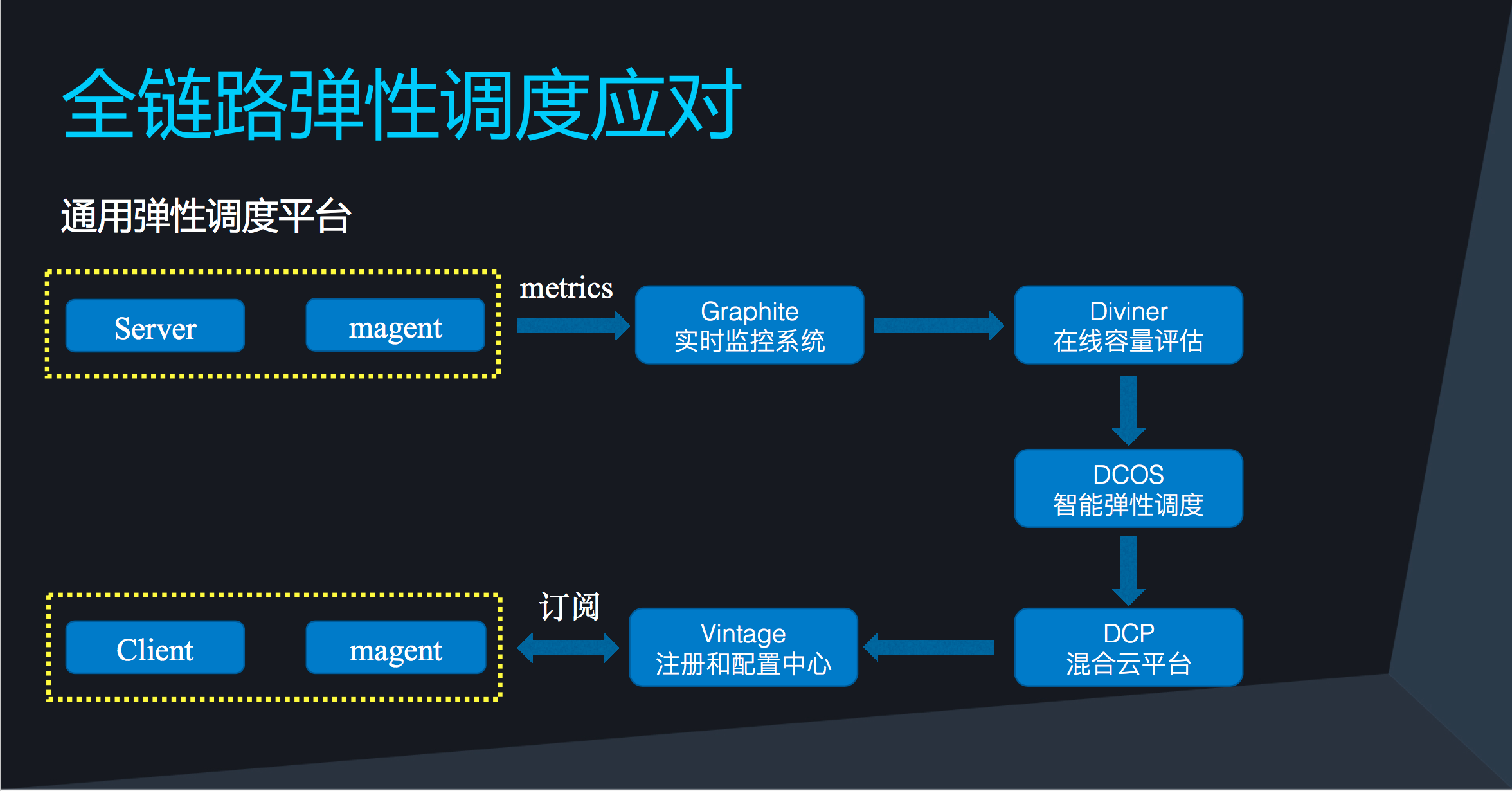

微博的彈性排程

微博的業務場景:熱點事件,如鹿晗戀愛、謝娜懷孕

微博排程系統的架構演進:

- 人工:運維同學手動擴容

- 自動:根據QPS、AvgTime定時定量去擴容

- 智慧化:根據RT/SLA/SUCCESSRATE做容量計算,每分鐘進行採集和水位判定,達到預先設定的閾值水位進行自動擴容。

智慧化彈性擴容中:

1. 為了防抖,每5分鐘滿足3次採集水位點才算達到閾值水位。

2. 為了計算準確性,去掉了效能最好和最差的百分之十的流量,計算中游的80%的流量。

看分散式服務化架構關鍵技術:左耳朵耗子

耗子哥的原標題是:不改一行程式碼提升系統的效能和穩定性並支援秒殺:看分散式服務化架構關鍵技術。看到這個標題還是很好奇的,帶著疑問提前一小時來到耗子哥的專場,發現只有地下可以做了,再晚一點連站著的地方都沒有了。

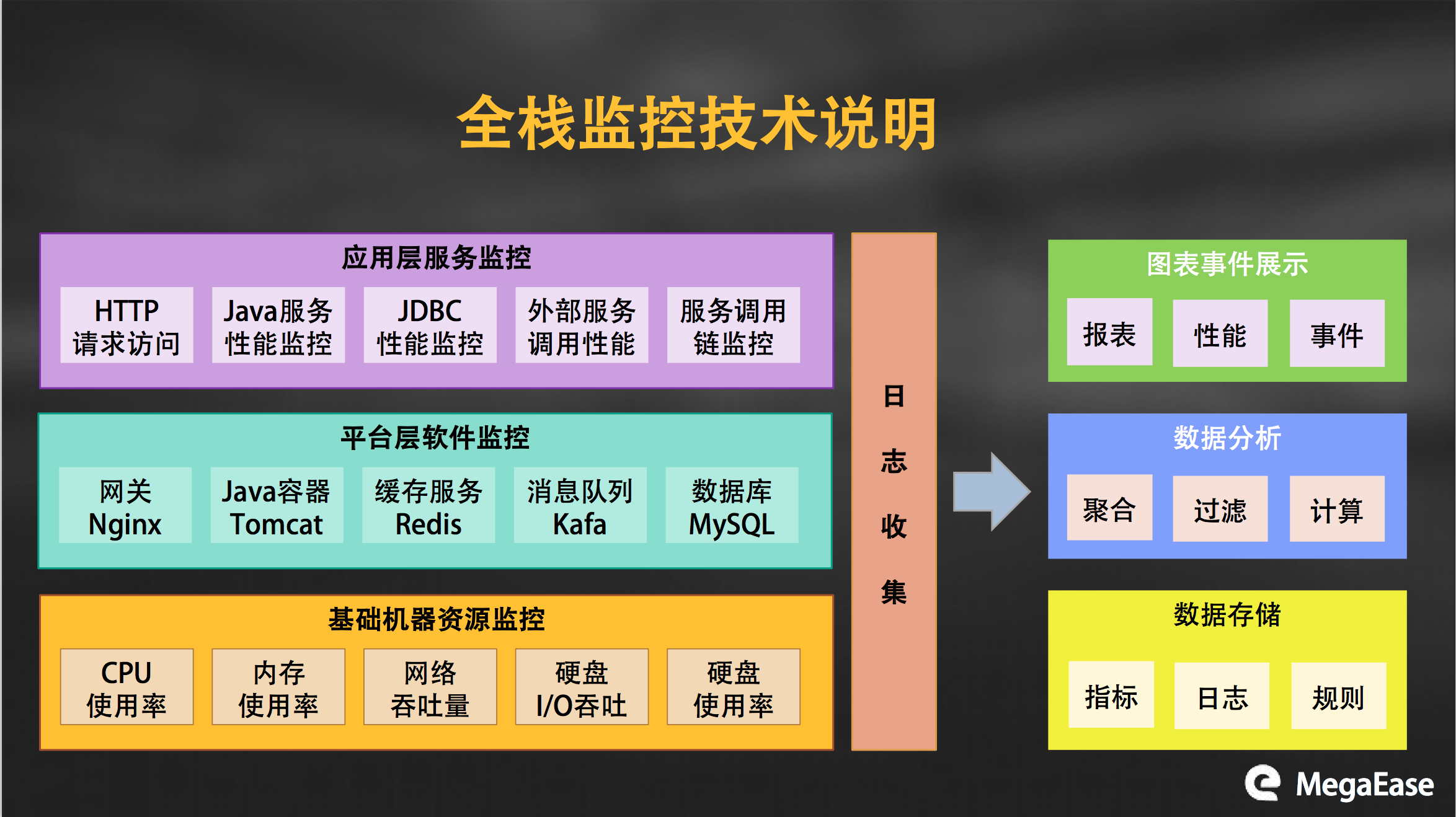

1.耗子哥分享了他們的統一監控架構設計,通過日誌的收集->聚合->計算->執行監控。

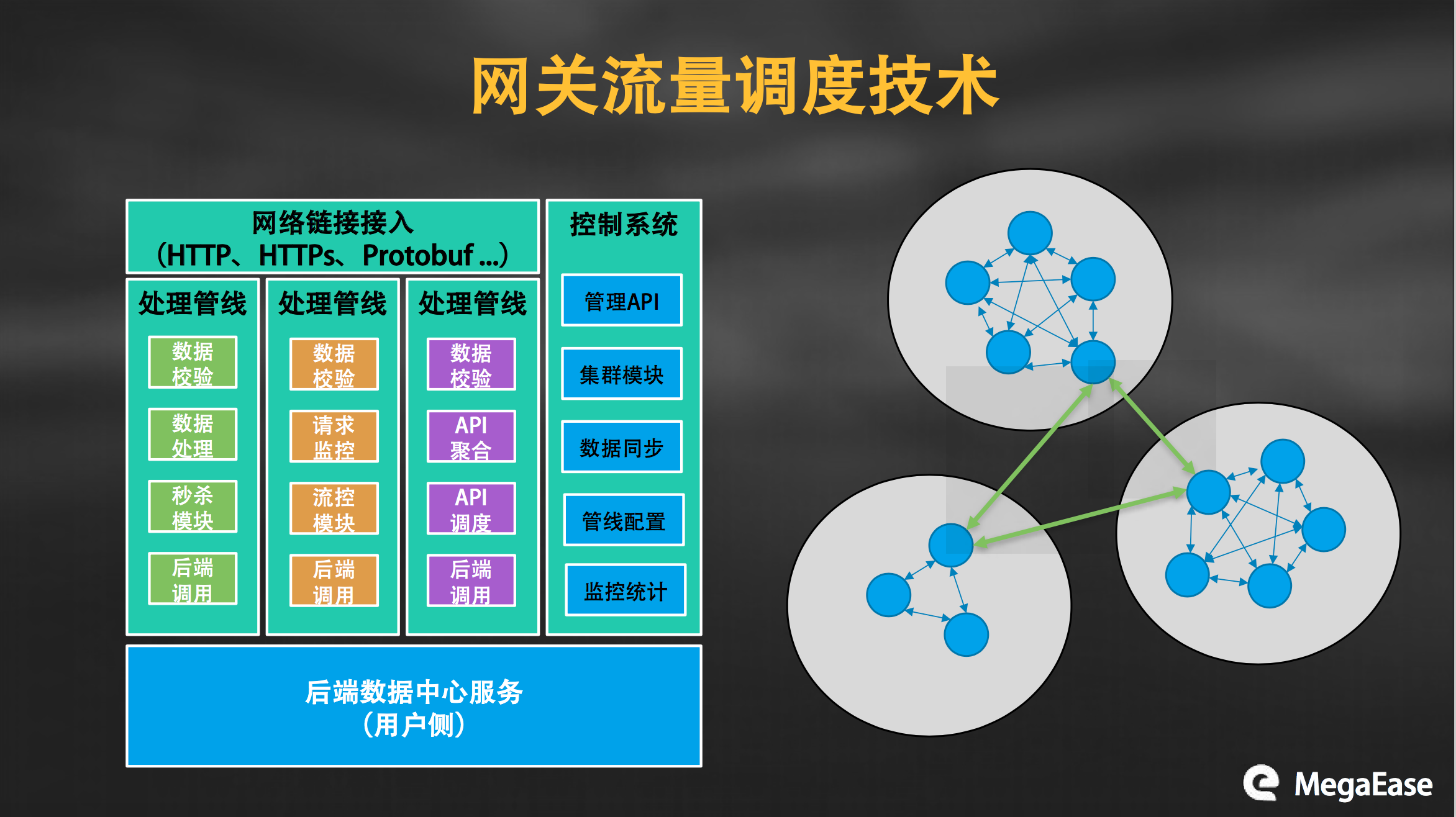

2.基於閘道器的流量排程技術,吧很多的事情前置到閘道器層去做

3.提到了如何不改一行程式碼:做秒殺、提升穩定性

3.1. 先思考下,不改程式碼的情況下如何讓一個效能很差的系統支援秒殺的場景?

耗子哥的案例中:通過流量閘道器,做一個隨機數的規則開關,隨機的結果不符合開關規則就會丟棄該請求,隨機數的規則是根據請求數,以此達到隨機流控的效果,間接的支援了秒殺。

3.2. 如何不改程式碼節省百萬的成本:原系統使用阿里雲端儲存,阿里雲價格較為昂貴,想切換到其他儲存方,但是小廠家的儲存的穩定性沒有保證。最後選擇使用小廠家的儲存做主儲存,阿里雲作為關鍵資料的災備,既節省了成本又保證了資料可靠性。

啟發:在聽這個分享之前,我一直在思考如果是讓我不改程式碼支援秒殺,我會怎麼做,心中一直沒給自己一個滿意的答案,雖然今天在聽了耗子哥的方式之後,會給我們一種標題黨的感覺,但是回頭認真思考會發現,其實作為技術人員,我們往往容易在做事情的時候吧自己限制在自己的思維空間呢,很多事情都行通過技術來改變,但是有些時候一些東西其實是可以換一種方式更輕鬆更高效的解決的。

相關文章

- 2017 JavaOne參會感想Java

- 參加阿里雲北京峰會隨感阿里

- 第三屆PHP全球開發者大會2017·北京PHP

- 參加社群技術活動後的感想

- 【資料合集】2017雲棲大會·北京峰會回顧合集:PDF下載

- 參加了某個群的技術交流會!來到這裡發表一下感想!

- 聚焦零信任|派拉參展2021北京網路安全大會

- 本週參加兩個SAP專案面試後的感想面試

- IBM Rationa變更與配置技術沙龍(北京站)小小感想IBM

- 歡迎參加“甲骨文融合中介軟體11g釋出會 – 北京”活動

- Strata + Hadoop World 北京2017大會講師徵集截止到本週五Hadoop

- AWSSUMMITInLondon參會分享MIT

- 感想

- 求實習機會 java 北京Java

- VUE CONF大會之後的感想(非技術)Vue

- 2010資料庫技術大會感想資料庫

- 開發者論壇一週精粹(第二十期):曬往期雲棲大會的照片或感想,贏2017杭州雲棲大會門票

- 生活感想

- 大學感想

- Strata + Hadoop World 北京大會 - 會場見Hadoop

- 傳智播客上海校區受邀參與“2017華為雲技術私享會

- 微軟AI大師會參會小記微軟AI

- 報名參加Polymer Summit 2017MIT

- 北京-招聘-Thinkphp開發(需要會前端)PHP前端

- Strata + Hadoop World 北京大會Hadoop

- Tech UP——EGO北京分會成立啦Go

- 北京市文化局:2017年北京動漫遊戲產值達627億元遊戲

- 2017年北京Facebook平臺夥伴大會,我看到了全球最酷的五家廣告黑科技!

- 感想與思考

- AWS技術峰會 2018 北京站火熱開場 60多場技術論壇、7000多專業人士參會

- ITPUB北京2008年會(1)-年會前傳

- 微軟陳永正:北京奧運會肯定會用Vista微軟

- Strata+Hadoop World 北京大會Hadoop

- 第五屆雲端計算大會參會有感

- 圖靈教育參會記——移動開發者大會圖靈移動開發

- 全球運維大會(深圳站)參會小結運維

- 大資料技術大會參會小結大資料

- 函式形參與實參的體會與對比函式