剛開始學習tf時,我們從簡單的地方開始。卷積神經網路(CNN)是由簡單的神經網路(NN)發展而來的,因此,我們的第一個例子,就從神經網路開始。

神經網路沒有卷積功能,只有簡單的三層:輸入層,隱藏層和輸出層。

資料從輸入層輸入,在隱藏層進行加權變換,最後在輸出層進行輸出。輸出的時候,我們可以使用softmax迴歸,輸出屬於每個類別的概率值。借用極客學院的圖表示如下:

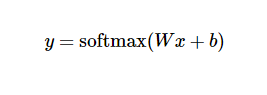

其中,x1,x2,x3為輸入資料,經過運算後,得到三個資料屬於某個類別的概率值y1,y2,y3. 用簡單的公式表示如下:

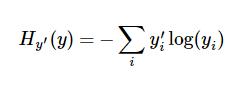

在訓練過程中,我們將真實的結果和預測的結果相比(交叉熵比較法),會得到一個殘差。公式如下:

y 是我們預測的概率值, y' 是實際的值。這個殘差越小越好,我們可以使用梯度下降法,不停地改變W和b的值,使得殘差逐漸變小,最後收斂到最小值。這樣訓練就完成了,我們就得到了一個模型(W和b的最優化值)。

完整程式碼如下:

import tensorflow as tf import tensorflow.examples.tutorials.mnist.input_data as input_data mnist = input_data.read_data_sets("MNIST_data/", one_hot=True) x = tf.placeholder(tf.float32, [None, 784]) y_actual = tf.placeholder(tf.float32, shape=[None, 10]) W = tf.Variable(tf.zeros([784,10])) #初始化權值W b = tf.Variable(tf.zeros([10])) #初始化偏置項b y_predict = tf.nn.softmax(tf.matmul(x,W) + b) #加權變換並進行softmax迴歸,得到預測概率 cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_actual*tf.log(y_predict),reduction_indies=1)) #求交叉熵 train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy) #用梯度下降法使得殘差最小 correct_prediction = tf.equal(tf.argmax(y_predict,1), tf.argmax(y_actual,1)) #在測試階段,測試準確度計算 accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float")) #多個批次的準確度均值 init = tf.initialize_all_variables() with tf.Session() as sess: sess.run(init) for i in range(1000): #訓練階段,迭代1000次 batch_xs, batch_ys = mnist.train.next_batch(100) #按批次訓練,每批100行資料 sess.run(train_step, feed_dict={x: batch_xs, y_actual: batch_ys}) #執行訓練 if(i%100==0): #每訓練100次,測試一次 print "accuracy:",sess.run(accuracy, feed_dict={x: mnist.test.images, y_actual: mnist.test.labels})

每訓練100次,測試一次,隨著訓練次數的增加,測試精度也在增加。訓練結束後,1W行資料測試的平均精度為91%左右,不是太高,肯定沒有CNN高。