Hadoop-寫入資料的幾種方式

create(新建)

import java.io.BufferedInputStream;

import java.io.FileInputStream;

import java.io.InputStream;

import java.io.OutputStream;

import java.net.URI;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IOUtils;

import org.apache.hadoop.util.Progressable;

public class FileCopyShowProgress {

public static void main(String[] args) throws Exception{

String inPath="D:\\file1.txt";//本地路徑

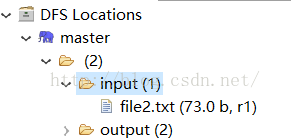

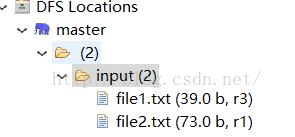

String outPath="hdfs://master:9000/input/file1.txt";//hdfs的路徑

InputStream in =new BufferedInputStream(new FileInputStream(inPath));

Configuration conf=new Configuration();

//create在寫入檔案時會自動產生所有的父目錄

FileSystem fs=FileSystem.get(URI.create(outPath),conf);

OutputStream out =fs.create(new Path(outPath),new Progressable() {

@Override

public void progress() {

System.out.print(".");

}

});

IOUtils.copyBytes(in, out, 4096,true);

}

}FSDataOutputStream不允許定位,因為HDFS只允許對一個開啟的檔案順序寫入,或向一個已有檔案新增(換句話說,不支援除尾部的其他位置的寫入)。

OutputStream out =fs.create(new Path(outPath),new Progressable() {

//替換為

FSDataOutputStream out =fs.create(new Path(outPath),new Progressable() {相關文章

- MySQL 寫入壓測幾種方式MySql

- Express 提交資料的幾種方式Express

- MYSQL資料匯出備份、匯入的幾種方式MySql

- 遍歷資料夾的幾種方式

- MySql資料庫備份的幾種方式MySql資料庫

- 資料庫SQL調優的幾種方式資料庫SQL

- mybatis連線資料庫的幾種方式MyBatis資料庫

- 做微博大資料廣告的幾種方式大資料

- python的幾種輸入方式Python

- 實現登入態的幾種方式

- 資料庫訪問幾種方式對比資料庫

- MySQL 資料庫定時備份的幾種方式MySql資料庫

- SpringBoot讀取配置資料的幾種方式Spring Boot

- Greenplum,PostgreSQL資料實時訂閱的幾種方式SQL

- flask返回資料的幾種方式(字串,json,元祖)Flask字串JSON

- iOS應用資料儲存的幾種常用方式iOS

- Excel快速錄入資料的幾種方法Excel

- tensorflow載入資料的三種方式

- Spring連線資料庫的幾種常用的方式Spring資料庫

- sqlplus常用的幾種登入方式SQL

- 【LISTENER】資料庫連線串的幾種寫法資料庫

- Android回顧--(十二) 資料儲存的幾種方式Android

- AngularJS中獲取資料來源的幾種方式AngularJS

- Oracle資料庫的幾種啟動和關閉方式Oracle資料庫

- MogDB openGauss資料庫擴縮容的幾種方式資料庫

- 直播系統原始碼,MAP的幾種取資料的方式原始碼

- Java寫入檔案的幾種方法分享Java

- TDengine 支援多種寫入協議,四種寫入方式提效大全協議

- Python資料儲存方式有幾種?如何使用?Python

- 線上直播原始碼,java資料分頁幾種方式原始碼Java

- Flutter 頁面間資料傳遞(共享)的幾種常用方式Flutter

- 117 遠端連線mysql資料庫的幾種方式MySql資料庫

- Nagios 快速實現資料視覺化的幾種方式iOS視覺化

- css引入的幾種方式CSS

- COOKIE的幾種操作方式Cookie

- 解析xml的幾種方式XML

- Unity反射的幾種方式Unity反射

- 簡單介紹mysql中資料庫覆蓋匯入的幾種方式MySql資料庫