10分鐘搞定Windows環境下hadoop安裝和配置

Hadoop是大資料的核心武器,下面來介紹在Windows環境下Hadoop的安裝和配置

1.下載Hadoop

2.解壓

hadoop-2.7.3.tar.gz 點右鍵“解壓到hadoop-2.7.3”

資料夾路徑 xxx/xxxx/hadoop-2.7.3

複製hadoop-2.7.3資料夾到 d盤 或者 e盤 的根目錄 (在這裡我安裝到了E盤)

3.原版的Hadoop不支援Windows系統,我們需要修改一些配置方便在Windows上執行

所需檔案hadooponwindows-master.zip 解壓

複製解壓開的bin檔案和etc檔案到hadoop-2.7.3檔案中,並替換原有的bin和etc檔案

4.配置Hadoop的環境變數

配置Java環境變數

新建變數名:JAVA_HOME

輸入路徑:D:\Softwares\jdk1.8 (這裡是以我的jdk地址為例,請根據自己的jdk地址來設定)

在path中最前面加上:%JAVA_HOME%\bin;

配置Hadoop環境變數

新建變數名:HADOOP_HOME

輸入路徑:E:\hadoop-2.7.3

在path中最前面加上:%HADOOP_HOME%\bin;

5.確認hadoop配置的jdk的路徑

在hadoop-2.7.3\etc\hadoop找到hadoop-env.cmd

右鍵用一個文字編輯器開啟

找到 set JAVA_HOME=C:\PROGRA~1\Java\jdk1.7.0_67

將C:\PROGRA~1\Java\jdk1.7.0_67 改為 D:\Softwares\jdk1.8(在環境變數設定中JAVA_HOME的值)

(如果路徑中有“Program Files”,則將Program Files改為 PROGRA~1

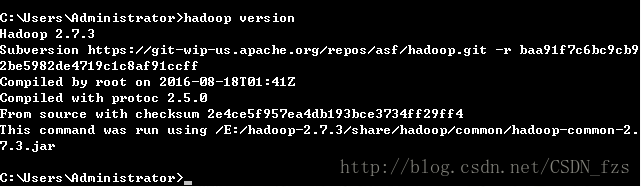

6.配置好上面所有操作後,win+R 輸入cmd開啟命令提示符,然後輸入hadoop version,按回車,如果出現如圖所示結果,則說明安裝成功

7.hadoop核心配置檔案

在hadoop-2.7.3\etc\hadoop中找到以下幾個檔案

開啟 hadoop-2.7.3/etc/hadoop/core-site.xml,

複製下面內容貼上到最後並儲存

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

開啟 hadoop-2.7.3/etc/hadoop/mapred-site.xml,

複製下面內容貼上到最後並儲存

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

開啟 hadoop-2.7.3/etc/hadoop/hdfs-site.xml,

複製下面內容貼上到最後並儲存,

請注意需要建立data 資料夾和兩個子資料夾,本例子是建立在 HADOOP_HOME的目錄裡(注意每個人的hadoop的路徑不一樣,這裡要做修改)

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/E:/hadoop-2.7.3/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/E:/hadoop-2.7.3/datanode</value>

</property>

</configuration>

開啟 hadoop-2.7.3/etc/hadoop/yarn-site.xml,複製下面內容貼上到最後並儲存

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

8.啟動Hadoop服務

建立三個資料夾

E:/hadoop-2.7.3/tmp

E:/hadoop-2.7.3/namenode

E:/hadoop-2.7.3/datanode

格式化 HDFS

以管理員身份開啟命令提示符

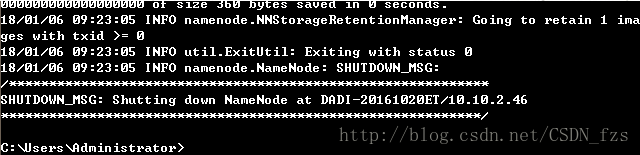

輸入hdfs namenode -format執行到如下圖所示

格式化之後,namenode檔案裡會自動生成一個current檔案,則格式化成功。

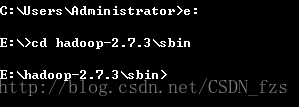

然後轉到Hadoop-2.7.3\sbin檔案下

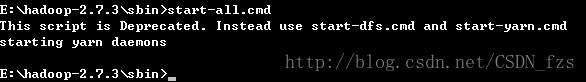

輸入start-all.cmd,啟動hadoop服務

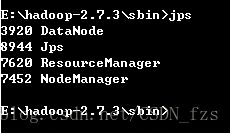

輸入JPS – 可以檢視執行的所有服務 (前提是java路徑設定正確)

相關文章

- CentOS環境下LAMP開發環境的搭建與配置(10分鐘搞定!!!)CentOSLAMP開發環境

- windows下配置安裝YAF環境Windows

- Windows10下如何安裝配置 perl 環境Windows

- Windows環境下的Oracle Data Guard安裝和配置WindowsOracle

- (轉)Windows下安裝Docker, GitBash環境配置WindowsDockerGit

- Windows環境下phpMyAdmin的安裝配置方法WindowsPHP

- CodeMan快速安裝配置教程:Windows下安裝配置Java JDK環境WindowsJavaJDK

- Windows 環境下 Python 環境安裝WindowsPython

- Windows 環境下安裝 LaravelWindowsLaravel

- Windows 環境下安裝 RedisWindowsRedis

- Windows環境下安裝RabbitMQWindowsMQ

- 如何下載安裝jdk和配置環境JDK

- MongoDB Windows環境安裝及配置MongoDBWindows

- Linux & Windows 環境下 RabbitMQ 安裝與基本配置LinuxWindowsMQ

- Linux & Windows 環境下 Redis 安裝與基本配置LinuxWindowsRedis

- Windows環境下嘗試安裝並配置PHP PEARWindowsPHP

- [保姆教程] [Postgres] 3分鐘在Ubuntu環境下安裝PostgresqlUbuntuSQL

- Hadoop安裝手冊2-Hadoop環境配置Hadoop

- Windows環境下安裝LinuxWindowsLinux

- Windows環境下安裝NexusWindows

- windows環境下安裝seleniumWindows

- 五分鐘搞定Docker安裝ElasticSearchDockerElasticsearch

- Java安裝和環境配置Java

- 10分鐘搞定讓你困惑的 Jenkins 環境變數Jenkins變數

- 本地windows搭建spark環境,安裝與詳細配置(jdk安裝與配置,scala安裝與配置,hadoop安裝與配置,spark安裝與配置)WindowsSparkJDKHadoop

- Docker 下安裝配置 lnmp 環境DockerLNMP

- Mac環境下安裝配置RedisMacRedis

- ubuntu下hadoop環境配置UbuntuHadoop

- windows環境docker安裝LNMP環境藉助dockers-compose.yml3分鐘快速完成WindowsDockerLNMP

- Hadoop開發環境配置1-maven安裝配置Hadoop開發環境Maven

- zookeeper安裝和使用 windows環境Windows

- Windows10下JDK8的下載安裝與環境變數的配置WindowsJDK變數

- 10分鐘搞定Mysql主從部署配置MySql

- JDK下載安裝和環境變數的配置JDK變數

- Windows 10下Hadoop 3.2.2 安裝指南WindowsHadoop

- QT Creator配置環境和安裝QT

- MacOS Flutter環境配置和安裝MacFlutter

- Expo 環境配置和安裝指南