hadoop的單機環境搭建

本次實驗參考了官方文件如下:

http://hadoop.apache.org/docs/current/hadoop-project-dist/hadoop-common/SingleCluster.html

版本說明:

作業系統:rhel-linux-64

hadoop版本:hadoop-3.0.0-alpha1 下載地址:http://hadoop.apache.org/releases.html

Java版本:jdk 1.8 下載地址:https://www.java.com/en/download/manual.jsp#lin

一:環境配置

1、安裝jdk:

[root@test2 setup]# rpm -ivh jre-8u111-linux-x64.rpm

2、安裝配置pdsh

[root@test2 setup]# tar -jxf pdsh-2.26.tar.bz2 && cd pdsh-2.26

[root@test2 pdsh-2.26]# ./configure --with-ssh --without-rsh && make && make install

[hadoop@test2 pdsh-2.26] # pdsh -v

3、建立hadoop 使用者:

[root@test1 ~]# useradd hadoop

[root@test1 ~]# passwd hadoop

4、Hadoop使用者解壓縮安裝包:

[hadoop@test2 setup]# gunzip hadoop-3.0.0-alpha1.tar.gz

[hadoop@test2 setup]# tar -xvf hadoop-3.0.0-alpha1.tar

5、在hadoop環境變數檔案中設定java環境變數

[hadoop@test2 hadoop-3.0.0-alpha1]$ vi etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/java/jre1.8.0_111

6、Hadoop使用者設定java環境變數

[hadoop@test2 latest]$ export JAVA_HOME=/usr/java/jre1.8.0_111

7、檢視java為1.8版本

[hadoop@test2 latest]$ java -version

java version "1.8.0_111"

Java(TM) SE Runtime Environment (build1.8.0_111-b14)

Java HotSpot(TM) 64-Bit Server VM (build25.111-b14, mixed mode)

二:搭建偽分散式hadoop

偽分散式搭建(Hadoop的偽分散式就是可以執行在一個節點上但hadoop守護程式執行在每個獨立的java程式中)

1、修改core-site.xml檔案 hadoop-3.0.0-alpha1/etc/hadoop/core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

2、修改hdfs-site.xml檔案 hadoop-3.0.0-alpha1/etc/hadoop/ hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

3、設定ssh信任

[hadoop@test2 ~]$ ssh-keygen -t rsa

[hadoop@test2 ~]$ cat .ssh/id_rsa.pub >> .ssh/authorized_keys

[hadoop@test2 ~]$ cd .ssh

[hadoop@test2 .ssh]$ chmod 0600 authorized_keys

無需密碼既能返回日期即表示成功

[hadoop@test2 .ssh]$ ssh localhost date

Fri Nov 18 10:17:14 CST 2016

4、格式化檔案系統

[hadoop@test2 hadoop-3.0.0-alpha1]$ ./bin/hdfs namenode -format

5、啟動NameNode和DataNode

[hadoop@test2 hadoop-3.0.0-alpha1]$./sbin/start-dfs.sh

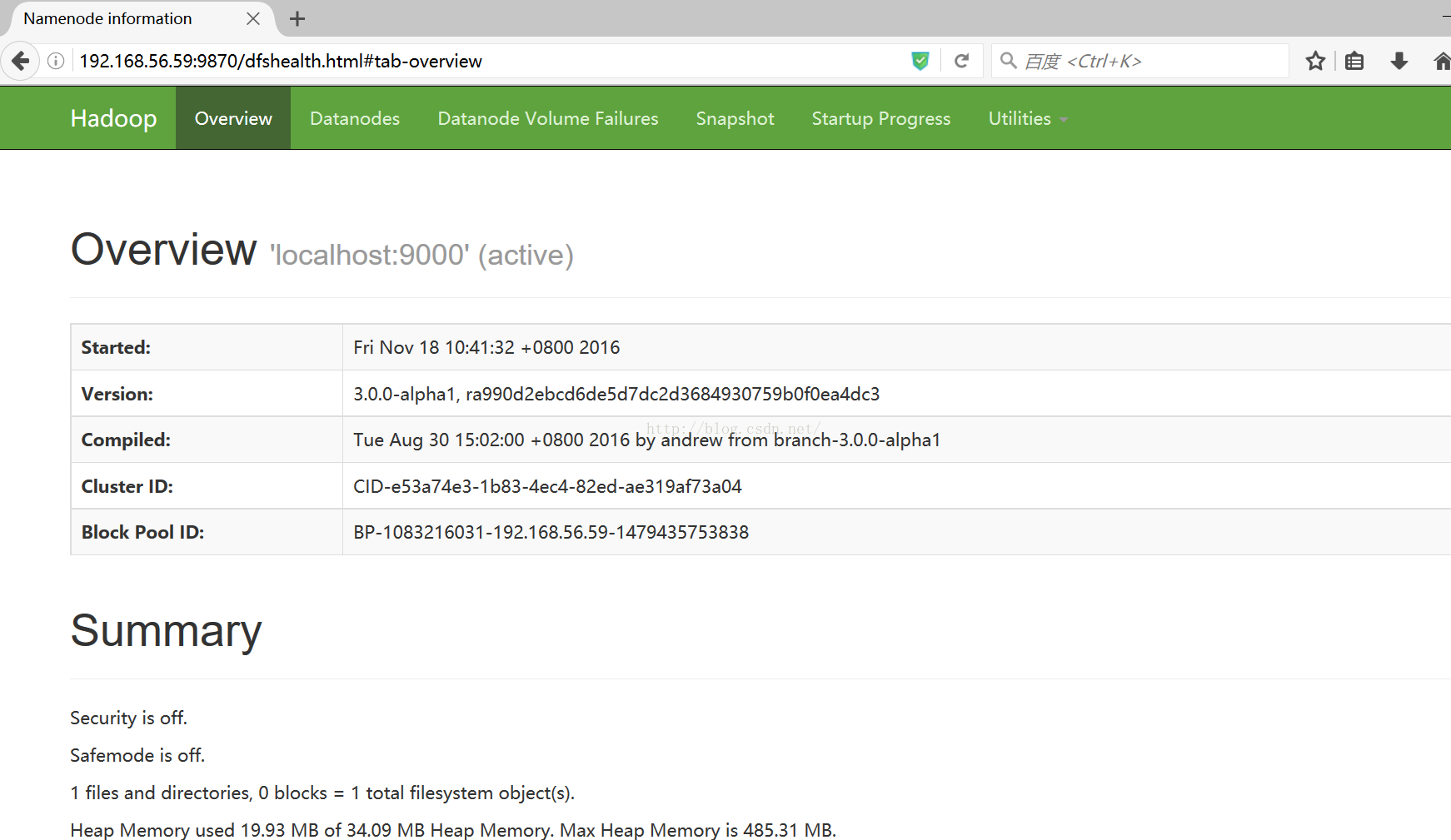

注:hadoop的日誌寫入到 $HADOOP_LOG_DIR 目錄 (預設是 $HADOOP_LOG_DIR /logs)6、NameNode 的預設地址:http://localhost:9870/

(本次測試伺服器的IP是192.168.56.59)

7、生成HDFS的目錄以便執行MapReduce任務

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -mkdir /user

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -mkdir /user/hadoopuser

8、把輸入檔案拷貝一份到分散式檔案系統中

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -mkdir /user/hadoopuser/input

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -put etc/hadoop/*.xml /user/hadoopuser/input

9、執行一些示例程式

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.0.0-alpha1.jar grep

/user/hadoopuser/input output 'dfs[a-z.]+'

10、檢視輸出檔案,將輸出檔案從分散式檔案系統拷貝到本地然後檢視

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -get output output

[hadoop@test2 hadoop-3.0.0-alpha1]$ cat output/*

或者在分散式檔案系統上檢視輸出檔案

[hadoop@test2 hadoop-3.0.0-alpha1]$./bin/hdfs dfs -cat output/*

11、停止服務程式

[hadoop@test2 hadoop-3.0.0-alpha1]$ ./sbin/stop-dfs.sh

三:YARN的配置

1、修改mapred-site.xml檔案 hadoop-3.0.0-alpha1/etc/hadoop/mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.admin.user.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

<property>

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=$HADOOP_COMMON_HOME</value>

</property>

</configuration>

2、修改yarn-site.xml檔案 hadoop-3.0.0-alpha1/etc/hadoop/yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

3、開啟資源管理和節點管理

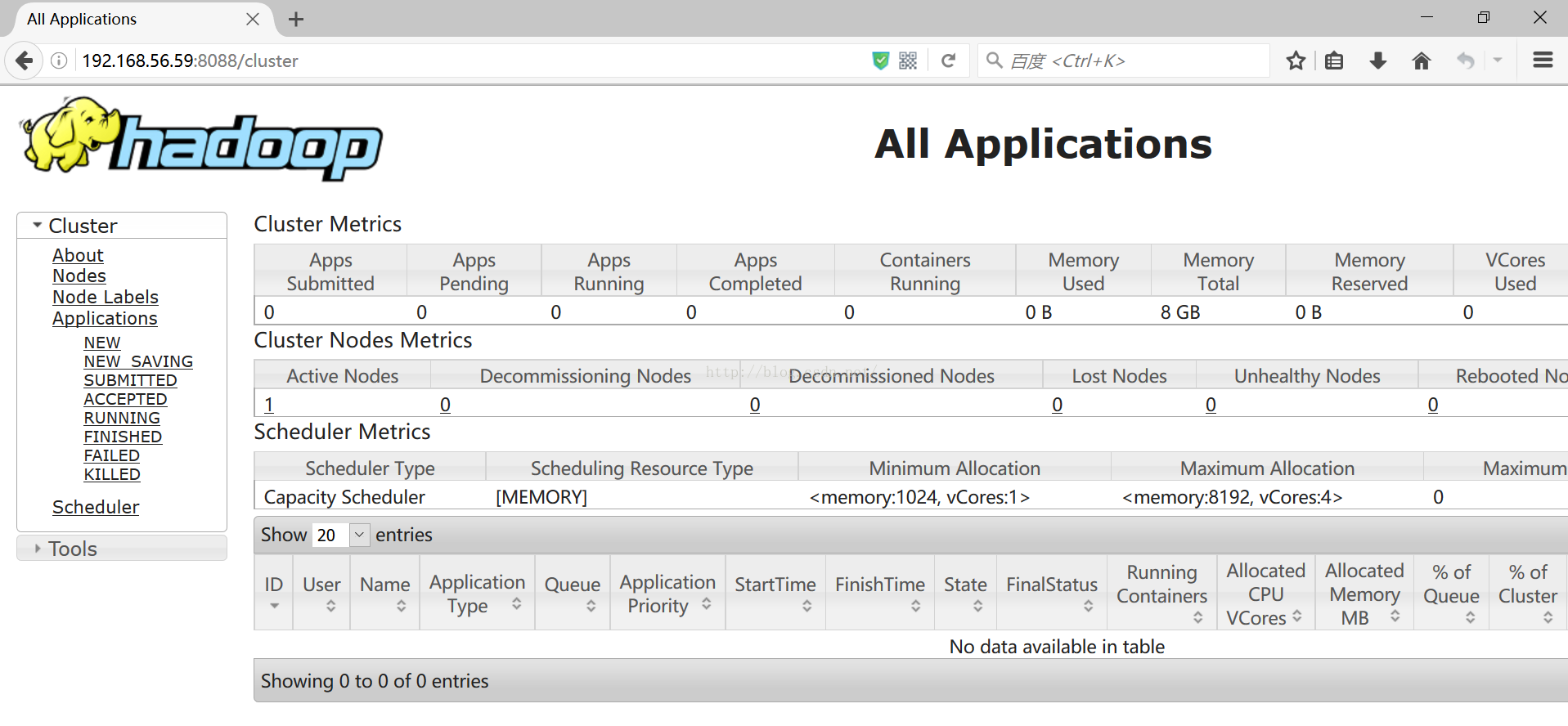

[hadoop@test2 hadoop-3.0.0-alpha1]$./sbin/start-yarn.sh4、資源管理的預設地址:http://localhost:8088/

(本次測試伺服器的IP是192.168.56.59)

5、關閉資源管理和節點管理

[hadoop@test2 hadoop-3.0.0-alpha1]$./sbin/stop-yarn.sh相關文章

- 單機版搭建Hadoop環境圖文教程詳解Hadoop

- 單機搭建ASM環境ASM

- Hadoop2.7.5環境搭建Hadoop

- Hadoop+hive環境搭建HadoopHive

- 搭建Hadoop開發環境Hadoop開發環境

- hadoop叢集環境搭建Hadoop

- 1.單機部署hadoop測試環境Hadoop

- ZooKeeper 系列(二)—— Zookeeper單機環境和叢集環境搭建

- Hadoop 基礎之搭建環境Hadoop

- 搭建本地執行Hadoop環境Hadoop

- hadoop完全分散式環境搭建Hadoop分散式

- HADOOP SPARK 叢集環境搭建HadoopSpark

- Hadoop 系列(四)—— Hadoop 開發環境搭建Hadoop開發環境

- 史上最詳細的Hadoop環境搭建Hadoop

- 搭建Hadoop的Eclipse開發環境HadoopEclipse開發環境

- Storm 系列(三)—— Storm 單機版本環境搭建ORM

- [hadoop]hadoop2.6完全分散式環境搭建Hadoop分散式

- mac搭建hadoop開發環境(二)MacHadoop開發環境

- hadoop 2.8.5偽分散式環境搭建Hadoop分散式

- hadoop 2.8.5完全分散式環境搭建Hadoop分散式

- 基於docker 搭建redis環境—redis單機版DockerRedis

- 單機上快速搭建一個Data Guard環境

- Ubuntu上搭建Hadoop叢集環境的步驟UbuntuHadoop

- Linux 下 Hadoop 2.6.0 叢集環境的搭建LinuxHadoop

- mac下hadoop環境的搭建以及碰到的坑點MacHadoop

- Hadoop入門(一)之Hadoop偽分散式環境搭建Hadoop分散式

- hadoop之旅2-centerOS7: 搭建分散式hadoop環境HadoopROS分散式

- 【Hadoop】:Windows下使用IDEA搭建Hadoop開發環境HadoopWindowsIdea開發環境

- hadoop之旅10-centerOS7 : Flume環境搭建HadoopROS

- hadoop之旅1-centerOS7: 搭建java環境HadoopROSJava

- hadoop之旅7-centerOS7 : Hive環境搭建HadoopROSHive

- Hadoop叢集之 ZooKeeper和Hbase環境搭建Hadoop

- Hadoop2.7.3+Hive2.1.1+Spark2.1.0環境搭建HadoopHiveSpark

- Linux下Hadoop2.6.0叢集環境的搭建LinuxHadoop

- andriod環境搭建(Mac機器)Mac

- scikit-learn 和pandas 基於windows單機機器學習環境的搭建Windows機器學習

- GoldenGate簡單複製環境的搭建Go

- Hadoop框架:叢集模式下分散式環境搭建Hadoop框架模式分散式