人工智慧經歷了幾次低潮時期,這些灰暗時光被稱作「AI寒冬」。這裡說的不是那段時期,事實上,人工智慧如今變得異常火熱,以至於科技巨頭谷歌、Facebok、蘋果、百度和微軟正在爭搶該領域的領袖人物。當前人工智慧之所以引起大家的興奮,在很大程度上是源於「卷積神經網路」的研究進展。這項機器學習技術為計算機視覺、語音識別和自然語言處理帶來了巨大的、激動人心的進步。你可能已經聽過它另一個更加通俗友好的名字——深度學習。

幾乎沒有人比54歲的Yann LeCun更能與深度學習緊密地聯絡在一起。早在20世紀80年代末,LeCun就作為貝爾實驗室的研究員開發出了卷積網路技術,並展示如何使用它來大幅度提高手寫識別能力;目前美國許多手寫支票依然是用他的方法在進行處理。上世紀本世紀初,當神經網路失寵,LeCun是少數幾名一直堅持研究的科學家之一。他於2003年成為紐約大學教授,並從此引領了深度學習的發展。

最近,深度學習及其相關領域已然成為最活躍的計算機研究領域之一。這就是LeCun在2013年底加入Facebook負責新成立的人工智慧實驗室的原因之一,儘管他依然保持著在紐約大學的職務。

LeCun出生在法國,保留了一些本國的「公共知識分子」角色所發揮的重要性。他的寫作和演講主要是集中在他的技術領域,當然,當涉及到其他領域,包括當今時事時,他也不會退讓。

IEEE Spectrum的Lee Gomes與LeCun在他紐約的Facebook辦公室裡進行了一次深度談話,共有九部分。

一、用8個單詞解釋深度學習

IEEE Spectrum:這些天我們看到了許多關於深度學習的新聞。在這些對深度學習的眾多描述中,你最不喜歡哪一種?

Yann LeCun:我最不喜歡的描述是「它像大腦一樣工作」,我不喜歡人們這樣說的原因是,雖然深度學習從生命的生物機理中獲得靈感,但它與大腦的實際工作原理差別非常非常巨大。將它與大腦進行類比給它賦予了一些神奇的光環,這種描述是危險的。這將導致天花亂墜的宣傳,大家在要求一些不切實際的事情。人工智慧之前經歷了幾次寒冬就是因為人們要求了一些人工智慧無法給與的東西。

Spectrum:因此,如果你是一名關注深度學習的記者,而且像所有新聞記者所做的那樣,只用八個單詞去描述它,你會說什麼?

LeCun:我需要考慮一下。我想將會是「學著描繪世界的機器」(machines that learn to represent the world)。可能另外一種描述是「端對端的機器學習」(end-to-end machine learning)。這種理念是:在一個能夠學習的機器中,每一個元件、每一個階段都能進行訓練。

Spectrum:你的編輯可能不大喜歡這樣。

LeCun:是的,公眾將無法理解我所表達的意思。好吧,有另外一種方法。你可以把深度學習看作是,透過整合大量能夠基於相同方式訓練的模組和元件來構建擁有學習能力的機器,比如說模式識別系統等。因此,需要一個能夠訓練每個事物的單一原則。但這又超過了八個字。

Spectrum:有哪些事情是深度學習系統可以做,而機器學習無法做到的?

LeCun:這是個更好的問題。之前的系統,我想我們可以稱之為「膚淺的學習系統」,會受他們能計算的函式的複雜度所限。因此,如果你使用一個類似於「線性分類器」的膚淺學習演算法來識別影像,你將需要從影像中提取出足夠多的引數特徵來提供給它。但手動設計一個特徵提取器非常困難,而且很耗時。 或者使用一個更加靈活的分類器,比如說「支援向量機」或者兩層神經網路,直接將圖片的畫素提供給它們。而問題是這不會提高物體識別在任何程度上的準確性。

Spectrum:這聽起來不像是一個簡單易懂的解釋。或許這就是為什麼那些記者會嘗試著把深度學習描述成……

LeCun:像我們的大腦。

二、有5億個開關的黑盒子

Spectrum:其中有一個問題是,機器學習是一個非專業人士極其難以接近的研究領域。一些經過教育的外行能夠理解一些半技術性的計算問題,比如說谷歌使用的 PageRank演算法。但我敢打賭只有教授才能對線性分類器和向量機瞭若指掌。這是因為該領域從本質上就很複雜難懂嗎?

LeCun:事實上,我認為機器學習的基礎原理非常簡單易懂。我曾經向高中的老師和學生解釋過這一主題,並沒有讓其中的許多人覺得枯燥乏味。 模式識別系統就像一個黑盒子,背面裝有攝像頭,頂上有一個紅燈和一個綠燈,前面裝有一連串開關。比如說一種嘗試著調節開關的學習演算法,當一條狗出現在攝像頭中時控制開關使紅燈亮起;當一輛車出現在攝像頭中時控制開關使綠燈亮起。為了訓練該演算法,你將一條狗放在機器面前,如果紅燈亮起,什麼都不做。如果光線模糊,扭動旋鈕使燈變亮。如果綠燈亮起,扭動旋鈕使燈光變暗;接下來換成汽車,扭動旋鈕使紅燈變暗或綠燈變亮。如果你進行多次嘗試,並且保持每次都對旋鈕進行逐漸微調,最終,機器每次都能得出正確答案。 有趣的是它能正確的區分開它從未見過的汽車和狗。竅門在於要計算出每次扭動旋鈕的方向和幅度,而不是亂動一氣。這包含對「梯度」的計算,旋鈕的每次扭動代表著燈光的相應改變。現在想象一下,有個盒子擁有5億個旋鈕、1000個燈泡,用1000萬張圖來訓練它。這就是一個典型的深度學習系統。

Spectrum:我認為你用「膚淺的學習」這個詞好像有些不太嚴謹;我不認為那些使用線性分類器的人會認為他們的工作很「膚淺」。之所以用「深度學習」這個表述難道就沒有媒體宣傳的因素在裡面?因為這看起來好像它學到的東西很有深度,但實際上,「深度」僅僅是指這個系統的級數?

LeCun:是的,是有點兒滑稽,但這反映了真實情況:膚淺學習系統有一層或兩層,而深度學習系統一般有5-20層。膚淺還是深度指的並不是學習行為本身,而是指被訓練的結構。

三、追尋漂亮的創意

Spectrum:Yann LeCun的標準簡歷裡提到,在他們都對神經網路失去興趣時,你依然堅持著探索神經網路的新方法。是什麼使你能夠無視世俗認知並一直堅持下去?

LeCun:自始至終,我都一直深深沉迷於能夠訓練出一套完整的「端對端」系統。你將未經加工的資料輸入系統,因為系統具有多層結構,每一層都將知道如何對上一層產生的表徵進行轉化,直到最後一層輸出結果。該理念——從頭到尾你都應該把學習融合進來,以便機器能夠學習到好的資料表徵——這就是我在過去三十年終所著迷的東西。

Spectrum:你的工作是符合駭客原則,還是科學原則?你是一直嘗試到它們可以執行為止?還是會從洞悉理論開始?

LeCun:直覺洞察、理論模型、實際執行、實證研究與科學分析之間存在很多相互影響。洞察力是一種創造性思維;模型基於數學;實際執行涉及工程學和純粹的駭客行為;實證研究和分析屬於實實在在的科學。其中我最喜歡的是那些能夠在實施中成功執行的簡潔優美的理論。 有些人傾向使用某種理論的原因僅僅是因為它簡單,或者他們不理會那些真正有用的理論的原因是它們太難了,我對這樣的研究人員完全沒有耐心。在機器學習領域存在一些這樣的現象。事實上,從某種程度上來說,上世紀末本世紀初的「神經網路寒冬」就是那種「研究原則」所導致的。你看似擁有堅不可摧的理論依據,但實證結果卻沒有價值,這非常不利於解決接下來的工程問題。 但採用純粹的實證研究方法也有許多隱患。例如,語音識別領域一直保持實證研究的傳統,只有當你的結果由於基準線時,才能得到本行業的關注。這扼殺了創造力,因為如果你想在測試結果上擊敗其他研究團隊,而他們對此已經做了多年研究,那你首先應該潛心研究4-5年,建造自己的基本架構,這非常困難,且極具風險,因此沒人這麼做。所以對於整個語音識別領域,雖然研究進展連續不斷,但都屬於漸進式。

Spectrum:你看起來一直在竭盡全力的將你的工作與神經科學和生物學拉開距離。例如,你提到了「卷積網路」,而不是「卷積神經網路」。你在你的演算法裡提到了「單位/個體」(units),而非「神經元」。

LeCun:的確如此。我們模型中的一些部分從神經科學中獲得了靈感,但還有相當多部分與神經科學毫不相干,相反,它們是來源於理論、直覺和經驗探索。我們的模型不希望變成大腦的模型,我們也沒有宣稱神經科學方面的相關性。但同時,如果說卷積網路的靈感來源於一些關於視覺皮質的基礎知識,我也可以接受。有些人間接從神經科學獲得靈感,但他卻不肯承認這一點,我承認,這(神經科學)很有幫助。但我會小心翼翼的不去觸碰那些會引發大肆宣傳的詞語,因為這個領域已經出現了瘋狂炒作,這非常危險。

四、大肆宣傳的東西看起來像科學,但實際上不是

Spectrum:炒作毫無疑問是有害的,但你為什麼說這是「危險的」?

LeCun:因為這給基金會、公眾、潛在客戶、創業公司和投資者帶來了預期,他們會因此相信我們正處在風口浪尖——我們正在建造一些像大腦一樣強大的系統,但實際上我們離這個目標還差的很遠。這很容易導致另一次的「寒冬週期」。 這裡會出現一些「草包族科學」(cargo cult science),這是理查·費曼的表達,指描述某些事物貌似科學,但實際上不是(譯者注:這出自理查·費曼1974年在加州理工學院的一場畢業典禮演說,描述某些事物貌似科學,卻遺漏了「科學的品德,也就是進行科學思考時必須遵守的誠實原則」)。

Spectrum:能舉幾個例子嗎?

LeCun:在「草包族科學」下,你往往是複製了機器的表象,卻沒有深入理解機器背後的原理。或者,在航空領域,你製造飛機時會完全複製鳥類的樣子,它的羽毛、翅膀等等。19世紀的人們很喜歡這麼做,但取得的成就非常有限。 在人工智慧領域也是如此,他們嘗試著對我們所知曉的神經元和神經突觸的所有細節進行復制,然後在一臺超級計算機上啟動一套龐大的模擬神經網路,希望從中孕育出人工智慧。這就是「草包族科學」的人工智慧。有許多拿到大筆基金支援的嚴肅的研究者基本上快要相信這些了。

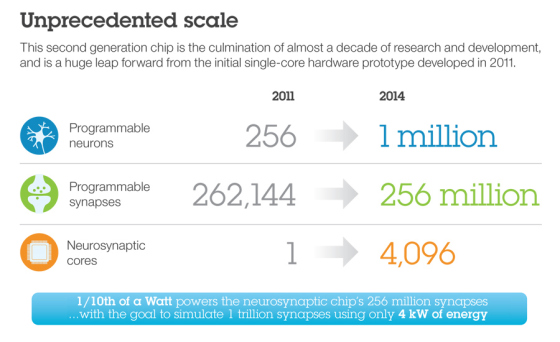

Spectrum:你認為IBM的True North專案(譯者注:IBM的類人腦晶片,整合了 54 億個矽電晶體、 4096 個核心、100 萬個「神經元」和2.56 億個「突觸」)屬於「草包族科學」嗎?

LeCun:這聽起來會有些刺耳。但我的確認為,IBM團隊所聲稱的東西有點偏差並容易造成誤解。從表面上看,他們的公告令人印象深刻,但實際上沒有實現任何有價值的東西。在True North之前,那個團隊用IBM的超級計算機來「模擬了一個老鼠級別的大腦」。但這只是一個隨機的神經網路,除了消耗CPU運算週期以外沒有發揮任何作用。 True North晶片的悲劇在於它本來可以很有用,如果它當初沒有堅持與生物學走的太近以及沒有使用「spiking integrate-and-fireneurons」模型的話。因此在我看來——我曾是一個晶片設計者——當你在開發一個晶片之前,你必須確信無疑它能做些有用的事情。如果你打造了一個卷積網路晶片——很清楚如何去做——它能立刻應用到計算裝置中。IBM創造了錯誤的東西,我們無法用它去完成任何有用的事情。

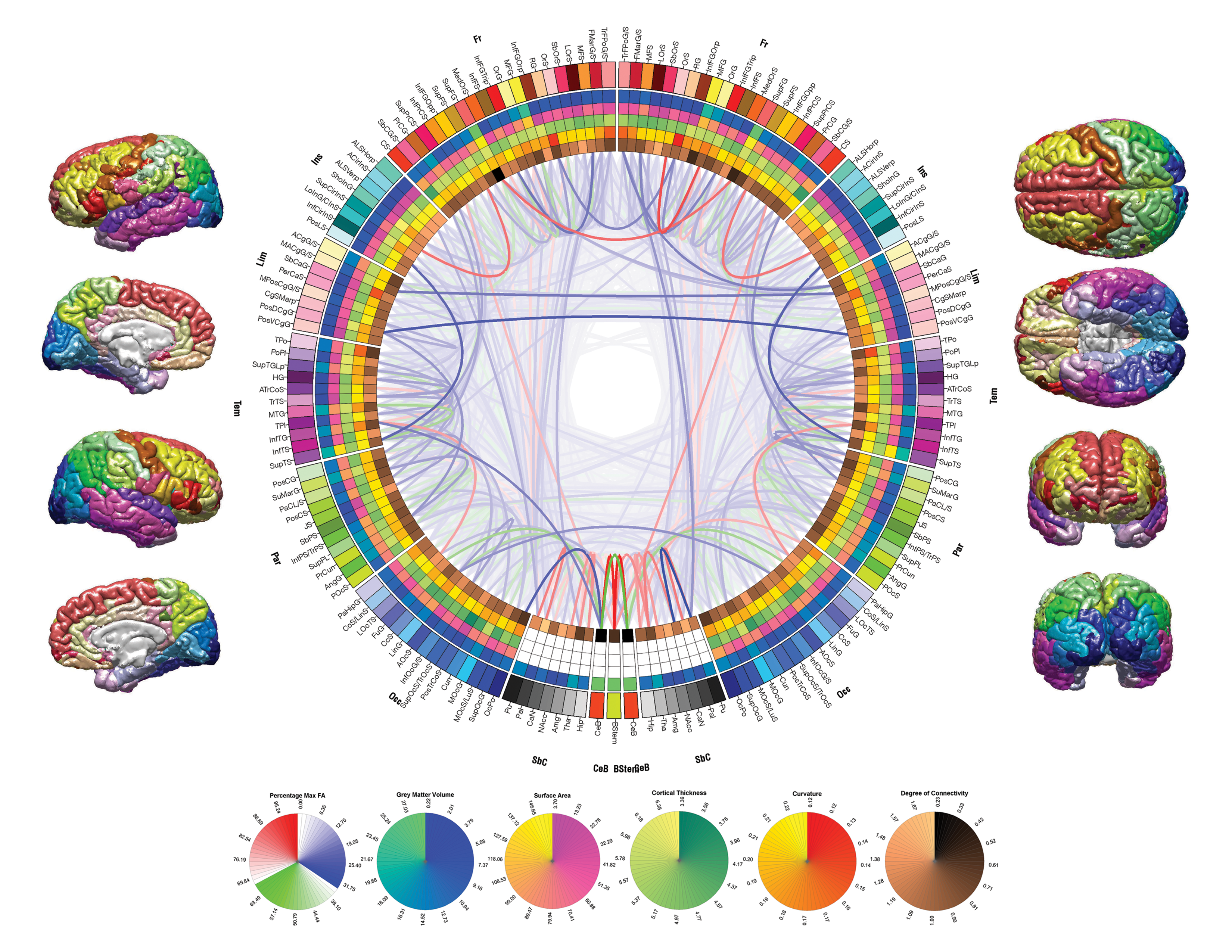

Spectrum:還有其他例子嗎?LeCun:從根本上說,歐盟人腦計劃(Human Brain Project)中的很大部分也是基於這樣一種理念:我們應該建造一種模擬神經元功能的晶片,越接近越好,然後將晶片用於建造超級計算機,當我們用一些學習規則來開啟它時,人工智慧就出現了。我認識這純屬胡說八道。 誠然,我剛才指的是歐盟人腦計劃。並不是諷刺參與這個專案的每個人。許多人參與該專案的原因僅僅是因為它能獲得鉅額資助,這是他們所無法拒絕的。

五、無監督學習——機器需要的學習方式

Spectrum:對於一般意義上的機器學習,還有多少是有待發掘的?

LeCun:太多了。我們在實際的深度學習系統中使用的學習方式還是存在侷限的。在具體實踐中發揮作用的其實是「有監督學習」。你將一張圖片展現給系統並告訴它這是一輛車,它就會相應調整它的引數並在下一次說出「車」。然後你再展現給它一把椅子、一個人。在幾百個例子、耗費幾天到幾周的計算時間(取決於系統規模)之後,它就弄明白了。 但人類和動物不是這種學習方式。當你還是嬰兒時,你並沒有被告知你所看到的所有物體的名字。然而你卻能學會這些物體的概念,你知道世界是三維的,當我把物體放在另一個的後面,你還是知道它的存在。這些概念不是與生俱來的,是你將它們學會了。我們把這種型別的學習稱作「無監督」學習。 2000s中期,我們中的許多人參與到了深度學習的復興運動中,包括Geoff Hinton、Yoshua Bengio和我自己——這就是所謂的「深度學習團體」——還有Andrew Ng,從此使用無監督學習而非有監督學習的理念開始興起。無監督學習可以幫助特定的深度網路進行「預訓練」。我們在這方面取得了不少成果,但最終能夠應用於實踐的還是過去那些能與卷積網路相結合的出色的有監督學習,我們在20年前(1980s)所做的事情。

但從研究的角度來看,我們一直感興趣的是如何恰當地做好無監督學習。我們現在已經擁有了可以實用的無監督技術,但問題在於,我們僅需要收集更多資料,再配合有監督學習就能擊敗它。這就是為什麼在現階段的產業中,深度學習的應用基本上都是有監督的。但將來不會再是這種方式。

從本質上來說,在無監督學習方面,大腦遠好於我們的模型,這意味著我們的人工智慧學習系統缺失了許多生物機理學習的基本原則。

六、Facebook的深度學習

Spectrum:Facebook有興趣建立一個人工智慧實驗室的原因有哪些?

LeCun:Facebook的宗旨是連線人與人(connect people)。這更意味著連線人與數字世界。2013年底,Facebook即將迎來十週年誕辰,MarkZuckerberg決定建立Facebook人工智慧實驗室,就是我領導的那個部門。公司在考慮未來十年間連線人與人意味著什麼,然後意識到人工智慧將發揮關鍵作用。

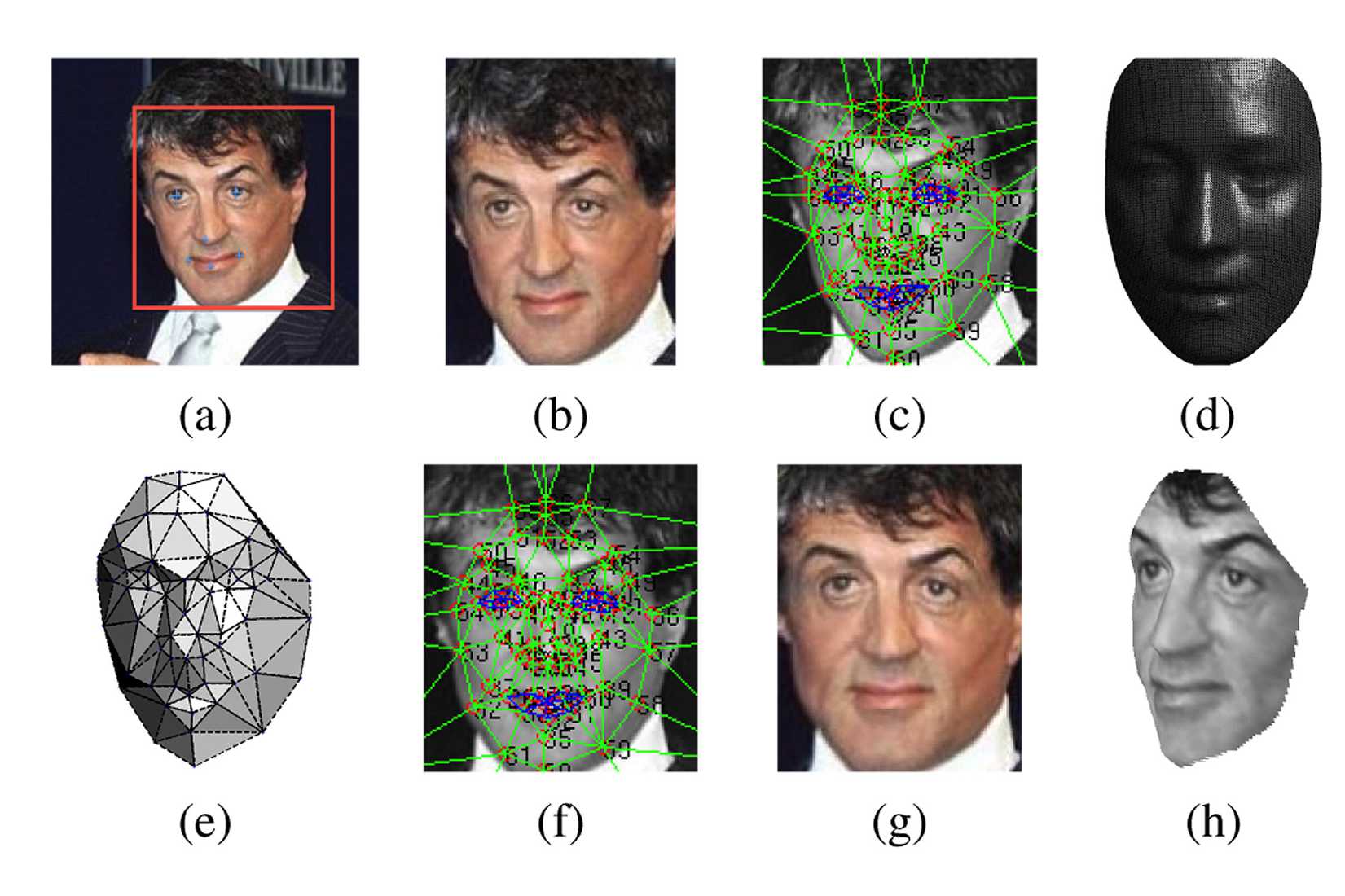

每天Facebook能向每個人展示2000條內容:帖子、圖片和影片等。但沒人有時間看這麼多內容。因此Facebook必須自動篩選100到150項使用者想看或需要看的內容。要深諳此道必須先理解人們,包括他們的口味、興趣、關係、需要,甚至是生活目標等。也需要理解內容,知道帖子或者評論在講些什麼,圖片和影片包含什麼內容。只有這樣,才能把最相關的內容篩選出來並呈現在使用者面前。在某種意義上,出色地完成這項工作是一個「徹頭徹尾的人工智慧」問題:這需要理解人、情緒、文化和藝術。我們在Facebook人工智慧實驗室的大部分工作都是聚焦於制定新理論、新原則、新方法和新系統,以讓機器理解圖片、影片和語言,隨後對其進行推理。Spectrum:我們剛剛談及炒作,我自己也對炒作有些微辭。Facebook最近公佈了一個人臉識別演算法DeepFace,很多報導稱人臉識別技術的準確性已經接近於人。但那些結果難道不是在精心策劃的資料庫中跑出來的麼?如果在網際網路上遇到隨機的圖片,這個系統報告還能取得同樣的成功麼?

LeCun:相比於人類,系統對圖片質量更為敏感,這是肯定的。人們能透過不同的面部鬍鬚等特徵識別出眾多不同構造的人臉,計算機系統在這方面鮮有優勢。但是系統可以在非常大的人類集合中識別出某個人,這個集合會遠遠超出人類的處理能力。

Spectrum:瀏覽網上的圖片並找出譬如說奧巴馬是否出現在圖片裡,DeepFace能否做的比我強?

LeCun:毫無疑問它將會更快。

Spectrum:它會更準確嗎?

LeCun:可能不會。但是它能從數億人中發現某人。我可做不到。

Spectrum:它能像研究中那樣,達到97.25%的準確率麼?

LeCun:沒有在資料庫上進行測試是很難說出一個具體數字的。這完全取決於資料的性質。如果圖片庫裡有數億張臉,那精確性就遠不及97.25%。

Spectrum:這裡有個問題似乎是計算機研究者們使用的某些行話和外行們的理解有著不同含義。當研究人員論及「準確率」,他們實際上可能說的是精選的資料集得出的結果。而外行們可能認為,計算機識別圖片就像我們日常生活中隨意看到的圖片一樣。但是結果對計算機系統的要求要比它們新聞報導中的表現更為苛刻。

LeCun:是的。我們也進行許多基準測試,像其他人一樣利使用者外臉部檢測資料庫等,當然也將我們的方法和別人做比較。當然,我們也有內部資料庫。

Spectrum:所以一般而言,面對你們隨意從網上找的圖片,計算機在人臉識別上的表現有多接近於人?LeCun:相當接近。Spectrum:能給個數字麼?LeCun:不,不行。情景不一樣(結果也不一樣)。Spectrum:在圖片識別之外的領域,深度學習表現如何,尤其是當涉及到諸如自然語言等通用智慧相關問題的時候?LeCun:我們在Facebook的很大一部分工作都是集中於此。我們如何將深度學習的優勢,與其透過學習描繪世界的能力、從短暫的訊號中積累知識的能力(伴隨著語言出現)、推理能力、與當前深度學習系統採取不同方式的知識儲存能力結合起來?在當前深度學習系統下,就像學習一項運動技能。我們訓練它們的方式類似於我們自學騎腳踏車。你學到了一項技能,但實際上卻不涉及大量事實記憶或知識。

但你學的其他一些事情,就必須要求你記住事實,你必須記住並儲存一些東西。在Facebook、Google和其他許多地方,我們做的大量工作是一邊建立神經網路,一邊建立一個獨立的儲存器模組。這能被運用於自然語言理解等領域。

我們開始看到,經由儲存器模組強化的深度學習幫助自然語言處理取得了令人印象深刻的結果。該系統基於這樣的理念,即用連續向量描述詞語和句子,經由深層架構的多層級完成對這些向量的轉化,並將它們儲存在一種聯合型儲存器裡。這對問答和語言翻譯都非常有效。這種模式的一個範例是儲存網路(Memory Network),這個模型是Facebook科學家Jason Weston、Sumit Chopra和 Antoine Bordes最近提出的。Google/Deep Mind的科學家也提出了一個相關概念「神經圖靈機」(Neural Turing Machine)。Spectrum:所以你不認為深度學習將會成為解鎖通用人工智慧的那把鑰匙?LeCun:它將是解決方案中的一部分。在一定程度上,這一解決方案看上去像一張巨大而複雜的神經網路。但這與人們迄今在文獻中看到的有很大不同。我說的這些東西,你已經可以開始看到一些相關論文了。許多人正在研究所謂的「週期神經網路」(recurrent neural nets)。在這些神經網路中,輸出被反饋到輸入端,這樣你就能形成一個推理鏈。你可以藉此來處序列訊號,像語音、音訊、影片和語言,初步結果相當不錯。深度學習的下一個前沿課題是自然語言理解。Spectrum:如果一切順利,我們可以期待機器很快能做到哪些它們現在做不到的事情嗎?LeCun:你或許能看到更好的語音識別系統,但在某種程度上它們是隱藏起來的。你的數字伴侶將會變得更完善;將會有更好的問答和對話系統;你可以和你的計算機進行對話;你可以向計算機發問而它會從知識庫中為你尋找答案;機器翻譯將會更精準;你還能看到自動駕駛汽車和更聰明的機器人,自動駕駛汽車將會使用卷積網路。

七、深度學習能讓機器獲得常識嗎?

Spectrum:在準備這次採訪時,我徵集了一些計算領域從業者想要問您的問題。艾倫人工智慧研究院(Allen Institute for ArtificialIntelligence,簡稱AI2)主任Oren Etzioni對於改進圖靈測試的Winograd Schemas挑戰(簡稱WS挑戰)很感興趣。WS挑戰不僅僅涉及自然語言和常識,還包括對於現代社會執行機制的理解。計算機可能會採取何種辦法來應對這些挑戰?LeCun:這個問題的關鍵是如何表達知識。在「傳統的」人工智慧裡,事實知識以圖形(是一套符號或實體及相互關係)的方式被手工輸入。但我們都知道人工智慧系統是可以透過學習自動獲取知識的。所以問題就變成了「機器如何才能學會表達有關事實和關係的知識?」深度學習毋庸置疑是解決方案的一部分,但不是全部。符號的問題在於它只是一串毫無意義的位元。在深度學習系統裡,代表實體的是大規模的向量,而它們是從資料和反應這些資料的特徵中學習而來的。學習推理要歸結於學會對使這些向量運算的函式。Facebook的研究人員Jason Weston、RonanCollobert、Antonine Bordes和Tomas Mikolov等人已經率先開始嘗試用向量來表達單詞和語言。Spectrum:人工智慧的一個經典問題是讓機器獲得常識。深度學習領域對這個問題有什麼見解?LeCun:我認為透過使用預測式無監督學習可以獲得某種常識。例如,我可以讓機器觀看大量的關於物體被拋擲或下落的影片。我訓練它的方法是給它看一個影片,然後問它:「接下來會發生什麼?一秒鐘之後畫面將如何?」以這種方式訓練機器去預測一秒鐘後、一分鐘後、一小時後、或一天後世界將會如何,它將獲得很好的對世界的描述。這會使得機器瞭解物理世界的眾多限制,如「拋向空中的物體在一段時間後將下落」、或者「一個物體不能同時在兩個地方」、或者「物體被擋住後仍然存在」。瞭解物理世界的限制將使機器能夠「填補空白」以及在被告知包含一系列事件的故事後對世界的狀態進行預測。 JasonWeston、Sumit Chopra和Antoine Bordes正在利用我剛才講到的「記憶網路」建造這樣一個系統。

Spectrum:談及人類的智慧和意識時,很多科學家常說我們甚至不知道我們所不知道的東西到底是什麼。你認為在建造人工智慧時也會遇到這個問題嗎?LeCun:這很難說。我曾說過建造人工智慧就像是開車在迷霧中前行。你只是順著你能看見的路往前開,但是可能會突然出現一堵牆在你眼前。這樣的故事在人工智慧領域屢見不鮮:50、60年代的感知機(Perceptrons)如此;70年代的句法符號方法(syntactic-symbolicapproach)如此;80年代的專家系統如此;90年代初的神經網路(neural nets)依然如此;還有像影像模型、核機器(kernel machines)及其他諸多研究都是如此。每次都會產生一些新的進展和新的理解,但也會產生一些需要突破的限制。Spectrum:另外一個問題是來自加州大學伯克利分校的著名教授Stuart Dreyfus和Hubert Dreyfus兄弟:「媒體有報導說計算機現在已經厲害到能夠識別並且自由攻擊特定目標的程度,你對這件事及背後的道德問題怎麼看?」

LeCun:我想道德問題不應該只丟給科學家!關於人工智慧的倫理道德問題必須進行討論。最終我們應當要建立一套關於人工智慧可以用來做什麼、不可以用來做什麼的倫理準則。這並不是新問題。與很多強大技術伴隨而來的倫理問題都需要社會來解答一樣,比如核武器和化學武器、核能、生物科技、基因操縱與克隆、資訊獲取。我個人認為機器在無人類決策的情況下不可能發起攻擊。但是話又說回來,這一類道德問題需要透過民主與政治程式來集體考察。Spectrum:你常常發表關於政治話題的尖刻評論。Facebook的掌門人不擔心嗎?LeCun:只有一些問題讓我坐不住。一種是不基於事實和證據的政治決策。只要某個重要決策的制定不是基於理性的我都會有所反應。聰明人對於解決問題的最佳方案可以有分歧,但是如果人們對堅定的事實都不能取得一致的話,我認為是非常危險的。這就是我所呼籲的。碰巧在這個國家,那些支援非理性決策與基於宗教決策的人們大部分都是右派的。但是我也要提醒左派的人,比如那些認為所有轉基因生物(Genetically Modified Organisms)都邪惡的人──只有部分轉基因生物是邪惡的,還有那些因非理性原因反對接種疫苗或核能利用的人。我是一個理性主義者。我也是一個無神論者、人文主義者,我並不害怕承認。我的道德理念的目標是,從長遠來看使人類整體幸福最大化及使人類苦難最小化。這些只是我的個人見解,與我的僱主無關。我儘量明確的分隔開我(發表在Facebook個人主頁)的個人見解以及我(發表在我的Facebook公共主頁上)的專業文章。

八、老生常談的奇點理論

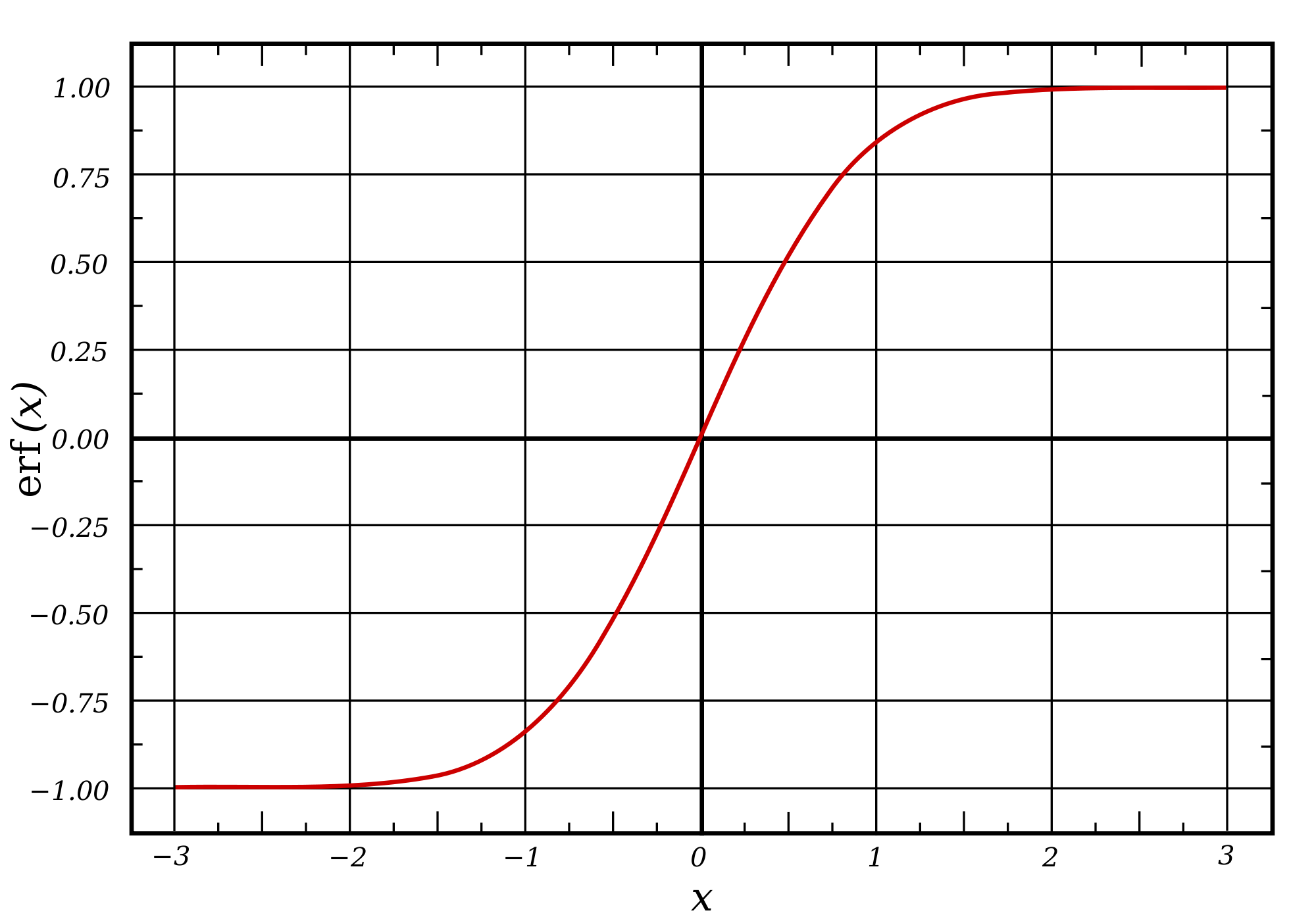

Spectrum:你之前已經說過,不同意那些與「奇點運動」相關的觀點。我很感興趣的是你如何看待與之相關的社會學方面的問題?對於它在矽谷如此受歡迎你怎麼解讀?LeCun: 很難講。對於這個現象我也有點困惑。正如 Neil Gershenfeld(譯者注,麻省理工The Center for Bits and Atoms主任)指出,sigmoid函式曲線的初始部分是指數型上升的,這也意味著現在看起來指數般增長的趨勢很可能會在將來遇到瓶頸,包括物理、經濟,以及社會方面,緊接著經歷拐點,然後飽和。我是樂觀主義者,但同時也是現實主義者。

確實有些人會大肆宣揚奇點理論,比如 Ray Kurzweil。他是個典型的未來主義者,對未來持有實證主義的觀點。透過大捧奇點,他賣了很多書。但據我所知,他卻對人工智慧學科沒有絲毫貢獻。他賣了很多科技產品,其中一些有一定的創新,但並沒有概念性的創新突破。確定無疑的是他沒寫過任何指導人們如何在人工智慧方面有所突破和進展的論文。Spectrum:你覺得他在Google現有的位子上有什麼成就嗎?LeCun:迄今為止,好像寥寥無幾。

Spectrum:我也注意到當我和一些研究者討論奇點理論時,有一個很有趣的現象。私下裡他們好像對此(奇點理論)很不以為然,可是一到公眾場合,他們的評論又會溫和很多。這是因為矽谷的一切大人物都很相信的原因嗎?LeCun:一線的人工智慧研究者需要保證一種微妙的平衡:對於目標要保持樂觀,但也不能過分吹噓。需要指出其中不易,但也不能讓人覺得希望渺茫。你需要對你的投資者、贊助商以及僱員誠實;需要對你的同事、同行誠實;還需要對外界公眾和自己誠實。當未來的進步有很多不確定時,尤其是當那些不夠誠實和自欺欺人的人總是對未來的成功誇下海口時,這(繼續保持誠實)很困難。這就是為什麼我們不喜歡不切實際地大肆宣揚的原因,這是由那些不誠實或者自欺欺人的人幹出來的,但卻會讓那些嚴謹誠實的科學家的工作變得更難。 如果你在Larry Page、Sergey Brin、Elon Musk、和Mark Zuckerberg那樣的位置上,你就得時刻思考長期來看科技到底該走向何處。因為你掌握著大量資源,並且可以利用這些資源讓未來朝你認為更好的方向行進。因此不可避免地你得問自己這些問題:10年,20年甚至30年後的科技到底會是什麼樣子?人工智慧的發展,奇點以及倫理問題到底會是怎樣?

Spectrum:是的,你說的對。但是你自己對於計算機科技如何發展有著很清晰的判斷,我不覺得你會相信我們在未來30年就可以實現下載我們的意識。LeCun:不會很快。Spectrum:或許永遠不可能。LeCun:不,你不能說永遠不可能。科技在加速前進著,日新月異。有些問題需要我們現在就開始關注,而另外一些則很遙遠,或許我們可以在科幻作品中費點筆墨,但現在還沒有擔心的必要。

九、有時我需要親手創造些東西

Spectrum:另一個問題來自一位研究人員,C++之父BjarneStroustrup問:「你曾經做過一些非常酷的玩意兒,其中大多數能夠飛起來。你現在是不是還有時間擺弄它們,還是這些樂趣已經被你的工作壓榨光了?」LeCun:工作裡也有非常多樂趣。但有時我需要親手創造些東西。這種習慣遺傳於我的父親,他是一位航空工程師。我的父親和哥哥也熱衷於飛機制造。因此當我去法國度假的時候,我們就會在長達三週的時間裡沉浸於製造飛機。

Spectrum: 你Google+個人首頁那張圖片上是什麼飛機?LeCun:它是Leduc,它就在鄰近巴黎的Musée de l’Air機場。我非常喜愛這架飛機。它是第一架依靠衝壓式噴氣發動機提供動力的飛機,這種發動機是特有的型號,能夠支援非常高的飛行速度。SR-71黑鳥飛機也許是世界上採用衝壓式噴氣發動機和渦輪噴氣發動機混合動力飛得最快的飛機。第一架Leduc原型機制造於二戰前的法國,在德國入侵法國之前就被毀壞了,二戰以後又先後製造了幾架。這就是非常具有創造性的做事方式。它看上去非常棒,具有難以言表的外形,每一樣設計都是為了滿足速度要求,但是製造這樣一架高效便捷的飛機耗資巨大。這架飛機衝壓式噴氣發動機的噪音也是難以忍受的。

Spectrum:你的網站上有個帖子講了一個有趣的故事,是你多年前偶遇Murray Gell-Mann(美國物理學家,獲得1962年諾貝爾物理學獎),你還讓他糾正你姓氏的發音。看起來你是小小的捉弄了一下這位傑出但自大的科學家前輩。現在你也變得相當有名,會不會擔心自己也一樣變得自大起來?LeCun:我試著不那麼引人注目。當你領導一個實驗室時,需要讓年輕人動用他們的創造力,這一點非常重要。年長者的創造力來自於他們所瞭解的東西,而年輕人的創造力則來自於他們所不瞭解的。這使他們可以進行更加廣泛的探索。你可不想磨滅這種激情。與博士研究生以及年輕研究者交流是應對驕傲自滿情緒的一種非常有效的方式。我認為我並不自大,而Facebook也是一家非常務實的公司。因此我們相當契合。

本文原載IEEE<Spetrum>,作者Lee Gomes,由機器之心獨家翻譯出品,參與成員:電子羊、翬、泥泥劉、赤龍飛、鄭勞蕾、流明。